Page 243 - 《软件学报》2025年第4期

P. 243

李梓童 等: 机器遗忘综述 1649

sample-GD 和 noisy-m-A-SGD 两种算法, 前者适用于高维数据, 后者适用于低维数据, 求解过程中需要保存每个时

刻的状态, 即模型梯度.

除了使用 MCMC 以外, Nguyen 等人 [68] 将逻辑回归看作一个变分推断 (variational inference) 问题. 变分推断通

过优化简单分布和复杂分布间的距离, 使得简单分布能够拟合复杂分布. 针对逻辑回归算法的遗忘, Nguyen 等人

用 M unlear 去拟合 M retrain , 用 KL 散度衡量 M unlear 参数和 M retrai 参数间的距离并进行优化, 继而得到 M unlearn . 以上

n

n

n

方法均生成机器遗忘后参数, 适用于参数空间小的模型.

4.2 深度生成

GAN 是在 2014 年提出的一类深度学习框架, 其中存在两个神经网络, 即生成器和判别器. 生成器生成一系列

样本, 判别器则对这些样本进行评估, 生成器以提高判别器错误率为目标, 若判别器无法甄别生成样本和真实样

本, 则认为生成的样本可用.

Chen 等人 [69] 使用 GAN 来生成 M unlearn . 这种机器遗忘方法适用于各种机器学习模型, 包括损失函数为非凸深

度学习模型. 在 Chen 等人提出的方法中, 生成器生成 M unlearn , 判别器则要求 M unlear 在 x 上的输出分布和 M retrain

n

∗

在从未见过的第三方数据集上的输出分布接近, 以此作为优化目标. 与 Chen 等人的方法相近, Kim 等人 [31] 和

型的开销

Chundawat 等人 [70] 同样使用生成模型来获得 M unlearn , 但不同之处在于, 除了对 M unlear 在 x 上的输出分布有要求

n

∗

外, 他们还考虑了 M unlear 在 D\x 上的准确率. Chundawat 等人使用两个模型作为训练基准: 一是在完整数据集上

n

∗

训练的模型 M 0 (smart teacher, Ts), 二是随机输出的模型 (dumb teacher, Td). Chundawat 等人将两者的输出和

M unlear 输出的距离作为损失函数进行优化, 使 M unlear 在 D\x 上的训练效果与 Ts 相似, 在 x 上的训练效果与 Td

∗

n

n

∗

相似. Kurmanji 等人提出的 SCRUB [46] 同样采取了师生模式, 其中, 学生模型只记住老师模型在待删除数据以外的

知识. 他们还利用“回滚”技术提高了遗忘后模型的隐私性, 避免了待删除数据被成员推理攻击窃取. Zhang 等人 [71]

在图像检索场景探索遗忘方法. 他们通过生成器生成噪声, 同时执行一对静态和动态训练过程, 使生成的噪声数据

淡化模型对待删除数据的记忆, 同时保留剩余数据集的信息.

OptLearn 同样使用深度神经网络预测 M unlearn [34] , 但仅限于损失函数为凸函数的模型, 如 SVM 等. OptLearn 分

为离线训练和在线估计两个阶段: 离线训练阶段, 深度神经网络从训练集中采样训练, 该过程的损失函数中加入

了 KKT (Karuch-Kuhn-Tucker) 正则项和衡量模型可用性的正则项, 使得深度神经网络预测的模型参数是其损失函

数上所对应的最优点; 在线估计阶段, 使用训练好的神经网络预测 M unlear 参数.

n

4.3 小 结

本节介绍基于生成的机器遗忘方法. 这些方法根据所用生成模型可细分为传统机器学习和深度学习两类. 表 7

列出了各子类代表方法、已知条件、时空开销和优缺点.

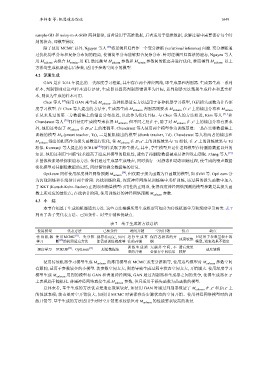

表 7 基于生成的方法总结

使用模型 代表方法 已知条件 时间开销 空间开销 优点 缺点

[33]

传 统 机 器 使用MCMC 、变分推 视算法而定, 如可 运 行 生 成 算 保存各状态的开 速度较快 只适用于参数量较小的

学习 断 [68] 的机器遗忘方法 能需要训练梯度等 法的开销 销 模型, 遗忘效果不稳定

训 练 生 成 模 无额外空间, 不 遗忘效果

深度学习 SCRUB [46] 、OptLearn [34] 原始数据集 速度较慢

必保存中间结果 较好

使用传统机器学习模型生成 M unlear 的常用模型有 MCMC 或变分推断等, 使用这些模型对 M unlear 参数空间

n

n

有限制, 适用于参数较少的小模型. 若参数空间太大, 则将导致生成过程中状态空间太大, 开销增大. 使用深度学习

模型生成 M unlear 用到的模型有 GAN 和普通神经网络, GAN 通过判别器和生成器之间的竞争, 使得生成器在 x ∗

n

上表现趋于随机化. 普通神经网络直接生成 M unlear 参数, 但只适用于损失函数为凸函数的模型.

n

总体来看, 基于生成的方法优点是遗忘效果较好, 如使用 GAN 时通过判别器保证了 M unlear 在 x 和 D\x 上

∗

n

∗

的性能表现; 缺点是时空开销较大, 如使用 MCMC 时需保存各步骤状态的空间开销、使用神经网络模型时的训

练开销等. 基于生成的方法适用于对时空开销要求较低但对 M unlear 的性能要求较高的场景.

n