Page 239 - 《软件学报》2025年第4期

P. 239

李梓童 等: 机器遗忘综述 1645

数据片内其他用户的协同关系, 这样的协同关系是不完整的. LASER 在给用户做划分时, 有更细致的划分策略: 事

先将用户映射到一个向量空间, 用向量来表示用户信息, 并根据向量值来划分用户. 向量距离越小, 用户相似性就

越高. LASER 使用优先队列进行划分, 使各个划分更加均匀. 在训练过程中, LASER 先在内部用户相似性大的数

据集上训练, 再在相似性小的数据集上训练, 以此降低模型损失. Chen 等人 [55] 在对 SISA 方法做改进时, 除用户相

似性外, 还考虑了商品相似性. 在聚合各子模型输出结果时, Chen 等人采用注意力模型来获取聚合参数, 从而提高

聚合结果的准确性.

2.4 小 结

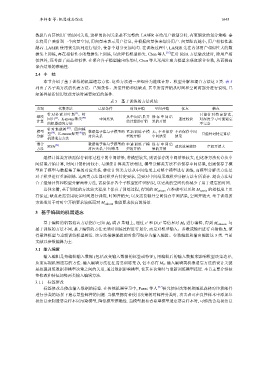

本节介绍了基于训练的机器遗忘方法. 这些方法进一步细分为继续计算、模型分解和混合方法这 3 类. 表 5

列出了各子类方法的代表方法、已知条件、所需开销和优缺点. 其中所需开销从时间和空间两部分进行说明, 已

知条件是指使用这些方法时需要知道的条件.

表 5 基于训练的方法总结

类别 代表方法 已知条件 时间开销 空间开销 优点 缺点

针对朴素贝叶斯 、岭 只能针对特定算法,

[9]

从而实现机器遗忘的方法. 输入编辑方法往往需要训练集

继续 回归 、K-means聚类 [40] 中间结果 从中间结果开 保 存 中 间 结 速度较快 对深度学习可能遗忘

[2]

计算 始计算的开销 果的开销

的机器遗忘方法 不完全

针对集成树 [24] 、回归模

模型 型 [50] 、K-means聚类 [40] 的 数据集子集与子模型的 重新训练子模 无, 不必保存 不必保存中间 只能针对特定算法

分解 对应关系 型的开销 中间结果 结果

机器遗忘方法

混合 SISA [26] 数据集子集与子模型的 中途训练子模 保 存 中 间 结 遗忘效果较好 空间开销大

方法 对应关系, 中间结果 型的开销 果的开销

继续计算类方法需保存训练过程中的中间结果, 若模型较大, 则需保存的中间结果较大; 但这种方法允许从中

间结果开始计算, 时间开销相对较小. 与继续计算类方法相比, 模型分解类方法不必保存中间结果, 但需保存子模

型和子模型与数据集子集的对应关系. 继续计算类方法从中间结果上对整个模型进行训练, 而模型分解类方法是

对子模型进行重新训练. 这两类方法都对模型有特定要求, 需要对中间结果或模型分解方法有所设计. 混合方法结

合了继续计算和模型分解两种方法, 需要保存各个子模型的中间结果, 以更高的空间代价减少了用于遗忘的时间.

总体来看, 基于训练的方法较大程度上保真了训练过程, 得到的 M unlear 在准确率以及和 M retrai 的相似度上更

n

n

有保证; 缺点是需要用较多时间进行训练, 时间开销大; 以及需要额外空间保存中间结果, 空间开销大. 基于训练的

方法适用于对时空开销要求较低而对 M unlear 性能要求较高的场景.

n

3 基于编辑的机器遗忘

基于编辑的机器遗忘方法指在已知 M 0 或 D 基础上, 通过 x 和 D\x 等信息对 M 0 进行编辑, 得到 M unlearn . 与

∗

∗

基于训练的方法不同, 基于编辑的方法无须对训练过程进行划分, 而是对模型输入、参数或输出进行直接修改, 使

得最终模型与重新训练模型接近. 该方法根据编辑的对象可细分为输入编辑、参数编辑和输出编辑这 3 类. 当前

文献以参数编辑为主.

3.1 输入编辑

输入编辑是指编辑输入数据 (包括改变输入数据的标签或特征), 用编辑后的输入数据来影响模型决策边界,

D, 但不必有 M 0 . 输入编辑类机器遗忘方法的设计关键

是挖掘训练数据和模型决策之间的关系, 通过数据影响模型, 使其在决策时与重新训练模型接近. 本节主要介绍标

签修改和特征加噪两类输入编辑方法.

3.1.1 标签修改

标签修改是修改输入数据的标签. 在传统机器学习中, Parne 等人 [47] 研究使用决策树和随机森林对垃圾邮件

进行分类的场景下遗忘某些邮件的问题. 当模型拥有者使用决策树对邮件分类时, 攻击者可在良性样本中添加垃

圾信息来制造恶意样本以污染模型, 降低模型准确性. 当模型拥有者希望模型遗忘恶意样本时, 可修改含垃圾信息