Page 242 - 《软件学报》2025年第4期

P. 242

1648 软件学报 2025 年第 36 卷第 4 期

化方法和随机方法等. Linear Filtration 方法让模型输出不包含待遗忘标签, 对模型内部结构则不作改动.

3.4 小 结

本节介绍了基于编辑的机器遗忘方法. 这些方法进一步细分为输入编辑、参数编辑和输出编辑这 3 类. 表 6

是对这些方法的总结. 输入编辑类方法通过数据来影响模型, 遗忘效果较不稳定; 由于需要从头训练模型, 时间开

销大; 需要的已知条件较多, 如需知道原始数据集 D. 参数编辑类方法直接给出 M unlear 计算方式, 速度较快, 时间

n

开销小; 在 M 0 基础上进行更新, 性能更加稳定; 不同参数编辑类方法已知条件不同, 如采用梯度更新法, 则需要知

∗

道 x 对应的梯度等. 输出编辑类方法目前只有 Linear Filtration 这 1 种. 该方法直接在 M 0 输出上增加映射矩阵, 使

x 的类别. 该方法运行速度快, 但使用限制大, 只适用于以标签为单位进行遗忘的场景, 且要求

∗

输出标签不包含

M 0 输出数据点在各个标签的可信度.

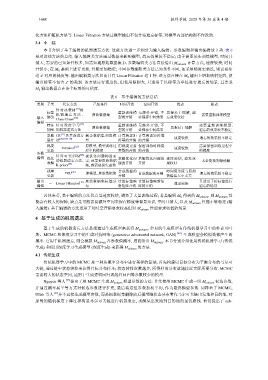

表 6 基于编辑的方法总结

类别 子类 代表方法 已知条件 时间开销 空间开销 优点 缺点

针对决策树 [31] 的

标签 重新训练模 无额外开销, 不 思想易于理解, 遗

n

输入 修改 机 器 遗 忘 方 法 、 原始数据集 型的开销 必保存中间结果 忘效果较好 需要重新训练模型

[27]

Class Clown

编辑

特征 针对深度学习 [44] 原始数据集 重新训练模 无额外开销, 不 思想易于理解 需要重新训练模型,

加噪 的机器遗忘方法 型的开销 必保存中间结果 遗忘的效果较不稳定

泰勒 CR [11] 及其改进方 剩余数据集和原模 计算海瑟矩 计算海瑟矩阵等 速度较快 遗忘的效果较不稳定

展开 法 [20,39,56–58] 型 阵等的开销 的开销

梯度 Forsaken [62] 原模型, 模型训练过 用梯度更新 保留训练时梯度 速度较快 需要保留训练过程中

更新 程中的梯度 参数的开销 的开销 的梯度

参数

针对可变SVM [28] 视优化问题构造而

编辑 优化 求解优化问 求解优化问题的 速度较快, 遗忘效

的机器遗忘方法、定, 或需要原始数据 未必能找到最优解

求解 [29] 题的开销 开销 果较好

K-priors 集, 或需要损失函数

残差 PRU [43] 原模型, 原始数据集 合成数据的 合成数据的开销 时间复杂度与原始 遗忘的效果较不稳定

更新 开销 数据集大小无关

输出 - Linear Filtration [30] 原始数据集标签分 计算标签映 计算标签映射矩 速度较快 只适用于按标签进行

编辑 布 射矩阵开销 阵的开销 遗忘的场景

总体来看, 基于编辑的方法优点是速度较快, 避免了大量训练过程; 若是编辑 M 0 得到的 M unlearn , 则 M unlear 性

n

能会有较大的保障; 缺点是可能需要额外空间来保存梯度等背景知识, 空间开销大, 以及 M unlear 性能不够稳定 (输

n

入编辑). 基于编辑的方法适用于对时空开销要求较高但对 M unlear 性能要求较低的场景.

n

4 基于生成的机器遗忘

基于生成的机器遗忘方法是指通过生成模型来获得 M unlearn . 常见的生成模型有传统机器学习中的朴素贝叶

斯、MCMC 和深度学习中的生成对抗网络 (generative adversarial network, GAN) [66] . 生成模型会模拟数据产生的

概率. 它用于机器遗忘, 则会模拟 M unlear 各参数值概率, 进而给出 M unlearn . 本节分别介绍使用传统机器学习 (传统

n

生成) 和使用深度学习生成模型 (深度生成) 来获得 M unlear 的方法.

4.1 传统生成

传统机器学习中的 MCMC 是一种从概率分布中进行采样的算法, 首先构建以目标分布为平衡分布的马尔可

夫链, 通过链中状态转移来获得目标分布样本; 状态转移次数越多, 所得样的分布就越接近实际所需分布. MCMC

需要较大的状态空间, 适用于生成逻辑回归或线性回归等参数较少的模型.

n

n

Nguyen 等人 [33] 提出了用 MCMC 生成 M unlear 模型参数的方法: 首先使用 MCMC 生成一组 M unlear 候选参数,

并通过概率展平等方式对候选参数进行扩充, 最后将这组参数加权平均, 作为最终模型参数. 同样基于 MCMC,

Ullah 等人 [67] 并不直接生成模型参数, 而是把数据集删除前后模型隐状态分布看作马尔可夫链出发地和目的地, 对

加噪的随机梯度下降过程构造马尔可夫链进行机器遗忘, 求解从出发地到目的地的最优路线. 他们提出了 sub-