Page 462 - 《软件学报》2024年第4期

P. 462

2040 软件学报 2024 年第 35 卷第 4 期

network fusing human and scene contexts is designed to predict absolute human depth. The experiments are carried out on public datasets,

namely MuPoTS-3D and Human3.6M, and results show that compared with those by the state-of-the-art models, the relative and absolute

position accuracies of 3D key points by the proposed HSC-Pose are improved by at least 2.2% and 0.5%, respectively, and the position

error of mean roots of the key points is reduced by at least 4.2 mm.

Key words: multi-person 3D pose estimation; keypoint region proposal; human context; scene context; absolute human depth

人体姿态估计是人体行为识别的重要技术, 广泛应用于安全监控, 自动驾驶, 人机交互, 虚拟现实和运动分析

等领域, 深受学术界和工业界青睐. 随着社会的进步和技术的发展, 识别理解人体动作和人体间位置关系变得日愈

重要. 3D 人体姿态估计即从单张图像或视频估计 3D 人体关键点位置. 由于单视角人体深度和尺度模糊, 从单张

图像恢复多人场景 3D 姿态是一个挑战性问题 [1] . 多人场景绝对 3D 姿态估计不仅包含相对 3D 姿态估计 (相对深

[2]

度), 还包含绝对人体位置及位置间的关系估计 (绝对深度) . 相对深度指人体关键点间的距离, 关联肢体朝向, 关

键点间的运动学约束等人体上下文信息. 绝对深度指人体根关键点与相机间的距离, 关联相机位置, 人体位置及人

体间的位置关系等场景上下文信息 [3,4] .

当前主流的多人 3D 姿态估计分为自顶向下 (top-down) 和自底向上 (bottom-up) 两类方法 [4,5] . 自顶向下方法

通过逐一检出场景中的人体恢复 3D 姿态, 对获取人体上下文优势明显, 但无法获取场景上下文. 自底向上方法直

接检测场景中的人体关键点再逐一恢复 3D 人体姿态. 虽然能够显式获取场景上下文, 但在相对深度估计方面处

于劣势.

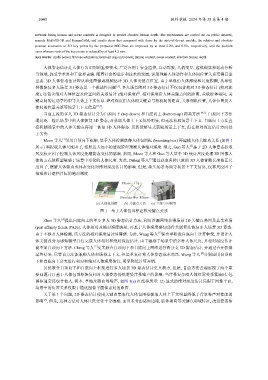

Moon 等人 [3] 采用自顶向下框架, 基于人体检测获得人体包围框 (bounding box) 再建模人体关键点关系 (如图 1

所示) 和提取人体尺度因子, 按照近大远小的透视原理预测人体绝对深度. 继之, Guo 等人 [2] 基于 2D 人体姿态提取

尺度校正因子控制人体尺度免遭姿态变化的影响. 然而, Moon 等人和 Guo 等人基于 3D 统计尺度处理 2D 图像人

体的方式使模型敏感于场景中变化的人体尺度. 为此, Dabral 等人 [5] 通过获取各种尺度的 3D 人体骨骼长度修正尺

度因子, 缓解人体姿态或体态变化对绝对深度估计的影响. 但是, 缺失场景布局等场景上下文信息, 仅靠尺度因子

很难估计遮挡目标的绝对深度.

Z

Elbow Hip X

...

Y

Shoulder Hip Elbow

(a) 人体包围框 (b) 关键点关系 (c) 三维空间模型

图 1 基于人体包围框建模关键点关系

Zhen 等人 [4] 提出自底向上的单步多人 3D 姿态估计方法, 利用沙漏网络获得场景 2D 关键点热图及其亲和场

(part affinity fields, PAFs), 人体相对及绝对深度映射, 再基于人体深度感知部件关联算法恢复多人场景 3D 姿态.

由于不涉及人体检测, 该方法的相对深度估计显薄弱. 为此, Wang 等人 [6] 提出单阶段自底向上计算框架, 并设计人

体关键点分布感知模型并行完成人体相对和绝对深度估计. 由于敏感于场景中的多种人体尺度, 其相对深度估计

尚不如自顶向下方法. Cheng 等人 [7] 交叉联合自顶向下和自底向上网络进行两分支 3D 姿态估计, 并通过合并获得

最终结果. 尽管该方法能兼顾人体和场景上下文, 但是重复计算人体姿态成本高昂. Wang 等人 [8] 分别应用自顶向

下和自底向上分支进行相对和绝对人体深度估计, 明显降低计算开销.

虽然联合自顶向下和自底向上框架进行多人场景 3D 姿态估计更具潜力, 但是, 目前方法普遍忽视了两个重

要问题: (1) 基于人体包围框恢复相对人体姿态仍然遭受背景噪声的影响, 当背景复杂或人体位置关系紧凑时, 包

围框通常还包含他人, 树木, 草地及路面等噪声, 如图 1(a) 红线框所示. (2) 显式的绝对深度估计局限于图像平面,

场景中的位置关系仅限于描述图像平面像素间的距离.

关于第 1 个问题, 2D 姿态估计使用关键点集取代人体包围框提取人体上下文明显降低了背景噪声对性能的

影响 [9] . 但是, 这种方法对人体尺度变化十分敏感, 而且未考虑诸如边缘, 肢体朝向等关键点邻域特征, 改进姿态估