Page 286 - 《软件学报》2024年第4期

P. 286

1864 软件学报 2024 年第 35 卷第 4 期

特征的低维度模型表示为数据的流形. 流形学习认为在高维空间的距离度量中, 欧氏距离只适用于低维流形展开

的空间, 而不能直接在高维的空间中进行度量. 直接使用欧氏距离在高维空间进行度量, 会丢失高维数据的绝大部

分内部特征. 流形学习旨在刻画数据的本质, 这一点与深度学习利用模型提取并学习数据本质的特征相同.

1.3 标签平滑

DNN 的性能和损失函数的选取紧密相连. 传统 DNN 图像分类模型的损失函数为交叉熵损失函数 (CE), 其公

式如下:

L CE (x,y) = −log(p t ) (1)

其中, p t 为目标类别的模型输出概率. DNN 通过训练使其预测的输出向量逐渐贴近正确标签的热独向量 (one-hot).

而 Szegedy 等人 [9] 提出的标签平滑技术修改了 CE 中的硬标签, 将目标类别的部分概率以均匀分布的方式分给其

他标签, 使硬标签成为软标签, 从而更贴近人类对事物的判别逻辑. Müller 等人 [14] 对标签平滑技术的有效性进行了

验证, 结果表明标签平滑可以提高模型的集束搜索能力, 泛化能力和修正能力, 同时减少模型对输出的过度

“自信”, 在一定程度上防止模型过拟合, 标签平滑技术将 CE 损失函数修改为:

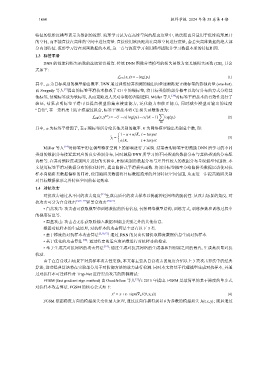

∑

LS

L CE (x,y ) = −(1−α)log(p t )−α/(K −1) log(p i ) (2)

i,t

其中, α 为标签平滑因子, 表示硬标签所分给其他类别的概率. K 为网络模型输出类别总个数, 即:

1−α+α/K, i = target

⌢

i

y = (3)

α/K, i , target

Müller 等人 [14] 对标签平滑在模型特征空间上的影响进行了实验. 结果表明标签平滑鼓励 DNN 所学习的不同

类别的数据分布接近其对应的真实类别分布, 同时鼓励 DNN 所学习的不同类别的数据分布与其他类别的分布距

离相等. 在其对细粒度类别图片进行的实验中, 相似类别的数据分布与差异性较大的数据分布呈现弧型包围状. 本

文使用标签平滑对数据分布的优化特性, 提出陷阱式平滑损失函数. 将部分标签概率分给陷阱类数据以诱使对抗

样本向陷阱类数据偏移的同时, 使用陷阱类数据将目标数据流形的外部特征空间包围, 从而进一步提高陷阱类别

对目标数据流形之外特征空间的标记效率.

1.4 对抗攻击

对抗攻击通过从不同的攻击角度 [15] 生成高质量的攻击样本以揭露神经网络的脆弱性. 从攻击场景的角度, 对

抗攻击可分为白盒攻击 [5,16−19] 和黑盒攻击 [20,21] .

• 白盒攻击: 攻击者可获取模型和训练数据的所有信息, 包括网络模型结构, 训练方式, 训练参数和训练过程中

的梯度信息等.

• 黑盒攻击: 攻击者无法获取除输入数据和输出类别之外的其他信息.

根据对抗样本的生成原理, 对抗样本的攻击算法主要有以下 3 类.

• 基于梯度的对抗样本攻击算法 [5,16,17] : 通过 DNN 的反向传播提取梯度数据信息生成对抗样本.

• 基于优化的攻击算法 [18] : 通过特定的适应度函数进行对抗样本的搜索.

• 基于生成式对抗网络的攻击算法 [19] : 通过生成对抗式网络的生成器和判别器之间的博弈, 生成高质量对抗

扰动.

由于在白盒攻击场景下对抗样本攻击性更强, 本文将主要从白盒攻击的角度介绍以上 3 类攻击算法中的经典

算法, 这些经典算法将在实验部分用于对防御方法的效力进行检测. 同时本文将基于代理模型生成对抗样本, 并通

过对抗样本可迁移性对 Trap-Net 进行黑盒攻击的防御测试:

FGSM (fast gradient sign method) 由 Goodfellow 等人 [5] 在 2015 年提出. FGSM 是最简单的基于梯度的单步式

对抗样本攻击算法. FGSM 的核心公式如下:

x = x+ε· sign(∇ x J(θ, x,y)) (4)

∗

FGSM 依据梯度方向的模型损失变化最大原理, 通过反向传播得到以 θ 为参数的模型损失 J(θ, x,y) ; 随后通过