Page 290 - 《软件学报》2024年第4期

P. 290

1868 软件学报 2024 年第 35 卷第 4 期

疑的权力, 则可以在一定程度上避免模型因目标类别特征信息不足和输出类别受限而导致的被迫犯错. 模型可通

过判别输入数据是否命中可攻击空间以判别输入数据是否为对抗样本. 我们将这种新的对抗防御思路称之为陷阱

式防御思维.

Pang 等人 [23,24] 的研究表明, 对单个深度神经网络而言, 提升其从不同类别数据之间所学习到的特征的多样性,

能极大提升深度神经网络的对抗鲁棒性. 这表明可通过给予深度神经网络更多的数据特征信息以提升网络模型的

鲁棒性. 这启发了我们可以从陷阱式防御思维的角度, 通过为 DNN 增添更多的数据特征信息以作为陷阱标签来

标记未定义的可攻击空间, 以此赋予 DNN 对输入怀疑的权力. 通过判定输入样本是否命中靶标可攻击空间来分

辨对抗样本与干净样本. 理论上, 当被标记的陷阱区域等于可攻击空间时, 可消除对抗样本对 DNN 鲁棒性的影响.

综上, 我们构建了陷阱式网络. 通过向 DNN 增添多个有别于训练数据类别, 且不影响原目标数据精确度的其

他类别数据作为陷阱数据, 使用相同的深度神经网络训练过程生成陷阱式网络. 陷阱式网络通过提取陷阱数据中

的特征信息进行学习, 利用所学习到的新的特征信息以标记原本未被定义的可攻击空间. 这些被陷阱数据类别所

定义的可攻击空间被称为靶标可攻击空间. 因为目标数据与陷阱数据之间的差异性, 干净输入数据不会被分类为

陷阱数据类别, 所以在应用中我们可以将被分类为陷阱类别的输入样本判定为对抗样本.

假设原干净样本 x 在特征空间中处于其自身的数据流形之中, 对抗攻击通过向 x 添加对抗扰动 ε 生成对抗样

∗ x 远离并偏移至可攻击空间中对抗样本所存在的特征空间. 理论上, Trap-Net 的有效性是因为以

本 x , 从而使得

下 4 种情况.

情况 1. 陷阱数据所带来的特征信息优化了深度神经网络的分类能力, 使得原目标数据类别之间的差异性变

∗

大, 不同类别间的数据流形距离变大, 导致被 ε 扰动后的 x 无法偏移至其他流形区域中.

情况 2. 在邻近可攻击空间中, 陷阱数据流形的加入改变了原本不同目标数据类别流形之间的决策边界, 从而

∗

使原本邻近可攻击空间被陷阱数据流形所定义, 最终截获了被 ε 扰动后的 x .

情况 3. 在邻近可攻击空间中, 陷阱数据的流形插入到了原本不同数据类别流形之间. 使得被 ε 扰动后的 x 只

∗

能偏移至陷阱数据流形之中.

情况 4. 陷阱数据定义了背景可攻击空间, 从而使得被 ε 扰动后的 x 偏移至已被定义的背景可攻击空间.

∗

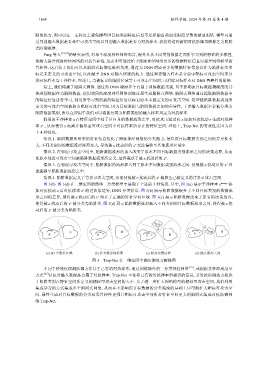

图 3(b)–图 3(d) 在二维空间的简单二分类模型中展现了上述前 3 种情况. 其中, 图 3(a) 展示干净样本 x benign 添

∗

加对抗扰动 ε 后对抗样本 x 跨过决策边界, DNN 分类错误. 图 3(b) 展示陷阱数据提升了不同目标类别的数据流

∗

形之间的差异, 使得被 ε 扰动后的 x 留在了正确的特征空间区域. 图 3(c) 展示陷阱数据改变了原有的决策边界,

x 被分类为陷阱类. 图 ε 扰

∗

使得被 ε 扰动后的 3(d) 展示陷阱数据流形插入不同类别的目标数据流形之间, 使得被

∗

动后的 x 被分类为陷阱类.

x * Trap *

x * x

x *

x benign B x benign B x benign Trap B

A A x benign B A

A

(a) 2D 子流形区域 (b) 扩大流形间距离 (c) 修改决策边界 (d) 插入流形之间

图 3 Trap-Net 在二维空间中的防御效力解释图

不同于传统仅探测防御方法基于已有的对抗样本, 通过训练额外的二分类神经网络 [25] , 或根据某种距离度量

方式 [26] 以区分输入数据是否属于对抗样本. Trap-Net 不依靠已有的对抗样本所提供的信息, 其对抗防御效力取决

于陷阱类别在特征空间所定义的靶标可攻击空间的大小. 为了进一步扩大网络模型的靶标可攻击空间, 我们利用

集成学习的方式集成多个陷阱式网络, 从而在不影响原目标数据的分类精度的基础上尽可能扩大靶标可攻击空

间. 最终生成对目标数据的分类结果鲁棒性更强且靶标可攻击空间所占特征空间更大的陷阱式集成对抗防御网

络 Trap-Net.