Page 288 - 《软件学报》2024年第4期

P. 288

1866 软件学报 2024 年第 35 卷第 4 期

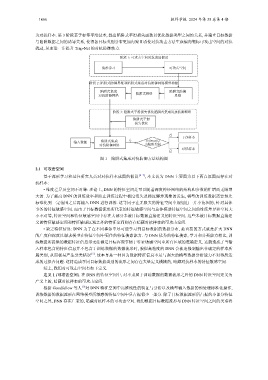

为对抗样本. 第 3 阶段基于标签平滑技术, 提出陷阱式平滑损失函数以优化数据类型之间的关系, 并建立目标数据

与陷阱数据之间的诱导关系, 使得各目标类别分布更加内聚且诱使对抗攻击方法生成偏向靶标可攻击空间的对抗

扰动, 从而进一步提升 Trap-Net 的对抗防御效力.

阶段 1: 可攻击空间对抗成因假设

流形学习 可攻击空间

阶段 2: 陷阱式防御思维和陷阱式集成对抗防御网络模型构建

陷阱式集成 陷阱式防御

对抗防御网络 陷阱式网络 思维

阶段 3: 陷阱式平滑损失优化陷阱式集成对抗防御网络

陷阱式平滑

损失优化

否

干净样本

输入数据 陷阱式集成 l f Softmax(l f )

对抗防御网络 为陷阱类别

对抗样本

是

图 1 陷阱式集成对抗防御方法结构图

2.1 可攻击空间

基于流形学习和过往研究人员对对抗样本成因的假设 [4−7] , 本文认为 DNN 主要因为以下两点原因而存在对

抗样本:

• 维度差异及空间不对等: 理论上, DNN 的特征空间是可以随着深度神经网络的结构和参数的扩增而无限增

大的. 为了提高 DNN 的训练效率和防止训练过程中梯度消失及梯度爆炸现象的发生, 模型的训练数据需要预先

标准化到一定范围之后再输入 DNN 进行训练. 这等同于在无限大的特征空间中规划出一片小范围的, 针对具体

事务的特征敏感空间. 而由于目标数据流形所代表的特征敏感空间与总体模型特征空间之间的维度差异和空间大

小不对等, 特征空间和特征敏感空间中存在大部分未被目标数据直接定义的特征空间. 这些未被目标数据直接定

义的特征敏感空间和特征敏感区域之外的特征空间则存在暗藏对抗样本的可攻击空间.

• 缺乏特征信息: DNN 为了在不同事务中尽可能学习到目标数据的数据分布, 最直接的方式就是扩大 DNN

的广度和深度以谋求模型在特征空间中更佳的特征搜索能力. 与 DNN 优秀的特征搜索, 学习和分类能力相比, 训

练数据所提供的数据特征信息却无法满足目标客观事物于特征敏感空间中所有区域的准确定义. 这就造成了当输

入样本包含的特征信息并不包含于训练数据的数据流形时, 貌似高精度的 DNN 会被迫强制输出非确定的样本所

属类别, 从而极易产生分类错误 [5] . 这本身是一种因为数据特征信息不足与强大的模型数据分析能力不对等所造

成的过拟合问题. 这将造成不同目标数据类别的流形之间存在大量定义模糊的, 暗藏对抗样本的特征敏感空间.

综上, 我们对可攻击空间有如下定义.

定义 1 (可攻击空间). 在 DNN 的特征空间中, 对不隶属于训练数据的数据流形之外的 DNN 特征空间定义为

广义上的, 暗藏对抗样本的可攻击空间.

根据 Goodfellow 等人 [5] 对 DNN 特征空间中高维线性的验证与分析以及模型输入数据的预处理标准化操作,

训练数据的数据流形在网络模型所敏感的特征空间中只占据很少一部分. 除了目标数据流形所占据的小部分特征

空间之外, DNN 存在广袤的, 暗藏对抗样本的可攻击空间. 我们根据目标数据流形与 DNN 特征空间之间的关系将