Page 224 - 《软件学报》2021年第5期

P. 224

1448 Journal of Software 软件学报 Vol.32, No.5, May 2021

容易产生过分割和欠分割现象.

(5) Navid Alemi:将多尺度特征共享网络与跳跃连接模式相结合,提出基于 SpaghettiNet 的细胞核分割模

型.训练过程使用 Dice 和交叉熵损失加权组合,以实现精确检测和分割的目的.由于该模型在预测结

果上应用分水岭变换,得到最终的实例分割结果,因而易产生过分割现象.

针对 Warwick-QU 腺数据集,代表性深度学习分割模型主要包括 CUMedVision1、CUMedVision2、CVML,

ExB、Freiburg 和 vision4GlaS,分别采用 FCN 与腺区域掩膜多级特征表示相结合的方法、深度轮廓感知网络模

型、两个卷积-池化层对和两个全连接层构成的 CNN 模型、多路卷积神经网络模型、U-Net 网络模型以及 CNN

与主动轮廓相结合的方法.而 ExB 和 Freiburg 根据后处理的使用进一步分类为 ExB1、ExB2、ExB3 和 Freiburg1、

Freiburg2.

在实现过程中,以上方法主要采用两种分割策略:(1) 识别和分组腺目标像素;(2) 对腺候选目标做有无腺

体的分类.针对前者:CVML、ExB 和 vision4GlaS 分别构建了一个 CNN 分类器,并使用像素周围的一个图像块

作为 CNN 分类器的输入用于训练和预测;而 CUMedVision 和 Freiburg 则均基于 FCN 网络框架从抽象的特征

中恢复出每个像素所属的类别,完成像素级的预测.为了解决腺实例分割问题,CVML 和 vision4GlaS 将轮廓信息

推理引入端到端的网络学习过程,由此建模腺实例轮廓间的交互关系;ExB 通过额外的网络训练获取实例分割

结果;而 CUMedVision 和 Freiburg 则显式地定义基于边缘的损失函数项.另外,针对后者,LIB 首先识别出部分腺

目标(例如管腔或上皮细胞核),然后对部分目标进行分类和分割.需要注意的是:ExB、LIB 和 vision4GlaS 分割

方法均引入腺的组织学分级,例如 ExB 所使用的边缘检测参数值取决于图像的组织学分级预测值、vision4GlaS

的像素分类取决于组织学分级信息等.

模型分割性能的排名综合考虑了两组评估标准:(1) glas 挑战赛评估标准,即 F1 分数+Dice 相似性系数

+Hausdorff 距离;(2) 分割精度评估标准,即 F1 分数+调整兰德系数+Hausdorff 距离.通过 Warwick-QU 多组腺病

理图像的分割实验结果表明:CUMedVision2、ExB1 和 ExB3 在多个指标上均优于其他分割方法,可以更好地避

免过分割和欠分割,对于腺图像分割具有较好应用前景.此外,通过结合深度轮廓感知网络模型的使用,

CUMedVision2 在良恶性腺分割上均超出 CUMedVision1.而 ExB2 和 ExB3 相比,ExB2 通过分离边界,也较好地

解决了恶性腺的分割问题.

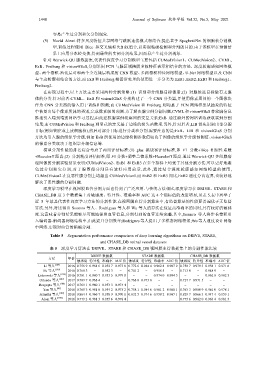

深度学习模型在视网膜血管分割方面也得到了广泛应用.与传统方法相比,深度学习在 DRIVE、STARE 和

CHASE_DB 这 3 个数据集上对敏感度、特异性、准确率和 AUC 这 4 个指标值的改进明显,见表 5.表中列举了

近 5 年最具代表性深度学习方法的分割性能.在视网膜血管分割算法中,有监督算法的性能要普遍优于无监督

算法.另外,对比得出 Soomro 等人、Rodrigues 等人和 Wu 等人的算法在保证高准确率的同时,具有较好的敏感

度.这意味着分割结果能够尽可能地保留血管信息,分割得到的血管连续完整.其中,Soomro 等人将步长卷积引

入编码器-解码器网络结构中,由此提升分割效率;Rodrigues 等人提出了多模态网络框架;Wu 等人通过设计网络

中网络,实现对血管的精确分割.

Table 5 Segmentation performance comparison of deep learning algorithms on DRIVE, STARE,

and CHASE_DB retinal vessel datasets

表 5 深度学习算法在 DRIVE、STARE 和 CHASE_DB 视网膜血管数据集上的分割性能比较

DRIVE 数据集 STARE 数据集 CHASE_DB 数据集

方法 年份

敏感度 特异性 准确率 AUC 值 敏感度 特异性 准确率 AUC 值 敏感度 特异性 准确率 AUC 值

Li 等人 [184] 2016 0.756 9 0.981 6 0.952 7 0.973 8 0.772 6 0.984 4 0.962 8 0.987 9 0.750 7 0.979 3 0.958 1 0.971 6

Fu 等人 [185] 2016 0.760 3 − 0.952 3 − 0.741 2 − 0.958 5 − 0.713 0 − 0.948 9 −

Liskowski 等人 [186] 2016 0.781 1 0.980 7 0.953 5 0.979 0 − − 0.974 0 0.994 3 − − 0.962 8 0.982 3

Orlando 等人 [187] 2017 0.789 7 0.968 4 − − 0.768 0 0.973 8 − − 0.727 7 0.971 5 − −

Dasgupta 等人 [188] 2017 0.769 1 0.980 1 0.953 3 0.974 4 − − − − − − − −

Yan 等人 [46] 2018 0.765 3 0.981 8 0.954 2 0.975 2 0.758 1 0.984 6 0.961 2 0.980 1 0.763 3 0.980 9 0.961 0 0.978 1

Srinidhi 等人 [189] 2018 0.864 4 0.966 7 0.958 9 0.970 1 0.832 5 0.974 6 0.950 2 0.967 1 0.829 7 0.966 3 0.947 4 0.959 1

Alom 等人 [190] 2018 0.779 2 0.981 3 0.955 6 0.978 4 − − − − 0.775 6 0.982 0 0.963 4 0.981 5