Page 196 - 《软件学报》2021年第5期

P. 196

1420 Journal of Software 软件学报 Vol.32, No.5, May 2021

1997 年约 2.7 万名法学学生,包括法学院学生、毕业学生和参加律师考试的学生,其记录了大量有抱负

的律师的人口统计学、经验和成果.虽然这些数据有局限性,但它对研究与法律教育相关问题是有价

值的.

• The UCI Bank Marketing 数据集:The UCI Bank Marketing 数据集包含 41 188 个个体的 20 个属性.这些

数据与一家葡萄牙银行机构的直接营销活动(电话)有关,其目标是预测客户是否会认购定期存款.

• Tetrad 生成数据集:吴勇楷等人 [46,47] 建立的因果模型,给定模型中所有外生变量和函数,利用模型生成

相应的人工数据库,可以用来验证公平算法的可靠性.

• Diversity in Faces (DiF)数据集:DiF 数据集 [86] 是 IBM 研究院为推进人脸识别技术的公平性和准确性研

究而发布的具有多样性的平衡数据集,其包含 100 万张有标注的人脸图像,标注的编码方案有颅面特

征(如头部长度、鼻子长度、前额高度等)、面部比例(对称性)、视觉属性(年龄、性别)、姿势以及分

辨率等.DiF 数据集旨在加深对公平的人脸表征的理解,并改进人脸识别技术.

• iNaturalist 数据集:iNaturalist 数据集 [87] 包含 80 万张层次标注的动植物图像,其目标是物种分类,可能存

在不同类别物种的分类正确率相差很大 [88] 的不公平现象.

• ML-fairness-gym 仿真环境:ML-fairness-gym [89] 是用于构建模拟的一组组件,其探索机器学习决策的潜

在长期影响.文献[90]发现:在简化的动态模拟环境中,长期影响实际上可能抵消预期目标.在 ML-

fairness-gym 的模拟场景中,代理与环境互动,有助于帮助研究突破静态环境公平的局限,实现长期交互

环境下的动态公平.

4.3 公平检测工具

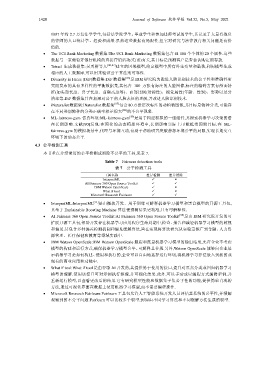

本节重点介绍常用的公平检测或消除不公平的工具,见表 7.

Table 7 Fairness detection tools

表 7 公平检测工具

工具名称 差异检测 差异消除

InterpretML 9 8

AI Fairness 360 Open Source Toolkit 9 9

IBM Watson OpenScale 9 8

What if tool 9 8

Microsoft Research Fairlearn 9 9

• InterpretML:InterpretML [91] 是由微软开发、用于训练可解释机器学习模型和黑盒模型的开源工具包,

其基于 Explainable Boosting Machine 算法使预测结果更精准,且有可解释性.

• AI Fairness 360 Open Source Toolkit:AI Fairness 360 Open Source Toolkit [92] 是由 IBM 研究院开发的可

扩展开源工具包,帮助开发者在机器学习应用程序生命周期中,检查、报告和减轻机器学习模型的歧视

和偏见.其包含多种偏差检测机制和偏见缓解算法,旨在实现将算法研究从实验室推广到金融、人力资

源管理、医疗保健和教育等领域实践中.

• IBM Watson OpenScale:IBM Watson OpenScale 跟踪和度量机器学习模型的输出结果,允许企业不考虑

模型的构建和运行方式,确保机器学习模型公平、可解释且合规.另外,Watson OpenScale 能够向企业展

示机器学习是如何构建、使用和执行的,企业可以自由地选择运行环境,将机器学习算法嵌入到新的或

现有的商业应用和功能中.

• What if tool:What if tool 是由谷歌 AI 开发的,其提供易于使用的接口,提升对黑盒分类或回归机器学习

模型的理解.使用该接口可对示例执行推理,并可视化结果.此外,可以手动或以编程方式编辑示例,并

重新运行模型,以查看更改后的结果.它有研究模型性能和数据集子集公平性的功能,提供简单直观的

方法,通过可视化界面在数据上使用机器学习模型,而不需要编程操作.

• Microsoft Research Fairlearn:Fairlearn 工具包允许人工智能系统开发人员评估其系统的公平性,并缓解

观察到的不公平问题.Fairlearn 可以比较多个模型,例如由不同学习算法和不同缓解方法生成的模型.