Page 193 - 《软件学报》2021年第5期

P. 193

刘文炎 等:可信机器学习的公平性综述 1417

(, , ) ⎯⎯→X A Y ˆ h , Y

其中,h 表示输出结果变换,Y 表示符合公平定义的输出结果.表 6 总结了公平决策任务的主要性质.

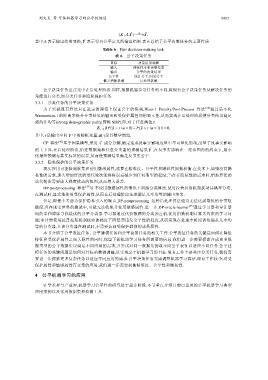

Table 6 Fair decision-making task

表 6 公平决策任务

目标 决策结果调整

输入 训练样本和决策结果

输出 公平的决策结果

公平性 统计公平,因果公平

偏差消除机制 后处理机制

公平决策任务重点集中在后处理阶段.同样,根据机器学习任务的不同,将现有公平决策任务从解决任务的

角度进行分类,即分类任务和隐私保护任务.

3.3.1 分类任务的公平决策任务

为了突破现有算法只在选定的阈值上保证公平的限制,Wass-1 Penalty/Post-Process 算法 [54] 通过最小化

Wasserstein-1 的距离来提升分类结果的输出和受保护属性间的独立性,从而实现在后处理阶段使分类结果满足

强统计均等(strong demographic parity,简称 SDP).即,对于任意阈值τ:

E τ ~Y (| ˆ ( P y > | τ = 0) − a ˆ ( P y > | τ a = 1) |) = 0,

其中,τ是输出空间 Y 中的随机变量,E(⋅)是其数学期望.

CF 算法 [47] 基于因果模型,采用 C 成分分解,确定造成反事实影响度量中不可量化的项,度量了反事实影响

ˆ

的上下界.在后处理阶段,给定数据集和任意分类器的预测结果 Y ,在反事实影响在一定范围内的约束下,最小

化最终预测与真实标签的误差,从而使预测结果满足反事实公平.

3.3.2 隐私保护的公平决策任务

现实应用可能限制收集和使用敏感属性,需要在精准度、公平性和隐私性间做权衡.在技术上,如果没有隐

私性的需求,那么增加算法的迭代轮次能够将误差减少到任何期望的程度;当存在隐私性的需求时,增加算法的

迭代轮次需要放大梯度扰动的范围,从而增大误差.

DP-postprocessing 算法 [55] 在不使用敏感属性的情况下训练分类算法,使用拉普拉斯机制扰动其概率分布,

在测试时,显式地使用受保护属性,从而在后处理阶段生成满足几率均等的输出结果.

但是,即使不考虑为保护隐私引入的噪音,DP-postprocessing 这种后处理算法通常无法达到最优的分类准

确度,且在现实世界的测试中,可能无法收集并使用敏感属性.进一步,DP-oracle-learner [55] 通过学习器和审计器

间的零和博弈寻找最优的公平分类器.学习器通过代价敏感的分类预言机,使用指数机制计算无约束的学习问

题;审计器使用拉普拉斯机制扰动的梯度下降惩罚违反公平性的程度,从而实现在处理中阶段训练满足几率均

等的分类器,且该分类器在测试时,不需要访问受保护群体的成员属性.

本节介绍了公平表征任务、公平建模任务和公平决策任务的相关工作.公平表征任务的关键是如何在降低

特征和受保护属性之间关联性的同时,保留下游机器学习任务所需要的信息.我们进一步需要探索合成更多数

据类型的公平数据集以满足不同应用的需求,并尝试对同一数据集提取不同公平表征以适应不同任务.公平建

模任务的关键问题是如何对目标函数做调整,以实现公平机器学习的目标.现有工作主要关注分类任务,我们需

要进一步探索更多复杂任务以适应不同应用的需求.公平决策任务无需调整机器学习算法,现有工作较少;对受

保护属性和敏感属性有交集的应用,我们进一步需要权衡精准度、公平性和隐私性.

4 公平机器学习的应用

在学术界与产业界,机器学习公平性的研究处于起步阶段.本节重点介绍目前已出现的公平机器学习典型

应用案例以及常用数据集和检测工具.