Page 333 - 《软件学报》2020年第11期

P. 333

3648 Journal of Software 软件学报 Vol.31, No.11, November 2020

{0.2,0.3,0.4,0.5}.由于注意力图具有类别信息,对于类别 c 的注意力图,如果空间位置 n 的值大于等于 th,则标注

该位置的像素类别为 c,否则为背景.最后,将这些像素标注与真实像素标注做 IoU 运算,并计算 21 个类别的平均

IoU 值(如表 1 所示,采用 PASCAL VOC 训练集数据).表 1 中,DCSM 方法(第 2 列)的结果均使用 Shimoda 等人 [45]

所提供的代码,并且表 1 的所有结果均没有加入 dense CRF 后续优化过程.通过表 1 可以说明,本文所提方法生

成的注意力图在所有阈值设定下所生成的伪像素标注都要比 DCSM 方法的结果更加准确(表 1 中,第 3 列为本

文方法的结果).

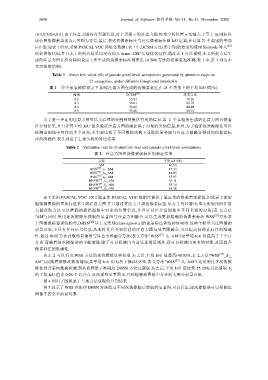

Table 1 Mean IoU value (%) of pseudo pixel-level annotations generated by attention maps on

21 categories, under different foreground thresholds

表 1 多个前景阈值设定下,根据注意力图生成的伪像素标注在 21 个类别上的平均 IoU 值(%)

阈值 DCSM [45] 本文方法

0.2 33.64 38.66

0.3 36.01 41.78

0.4 36.48 42.25

0.5 35.40 40.61

为了进一步证明注意力图可以为后续的分割网络提供有用的信息,第 2 个实验将生成的注意力图直接看

作分割结果,并且计算平均 IoU 值来验证注意力图的确提供了对象的类别信息.此外,为了验证逐次擦除法可以

检测出图像中存在的多个对象,本实验比较了不同擦除次数下获取的显著图与注意力图融合得到的伪像素标

注的准确性.表 2 列出了上述实验的对比结果.

Table 2 Validation results of attention map and pseudo pixel-level annotations

表 2 注意力图和伪像素级标注的验证结果

方法 平均 IoU(%)

AM 40.53

WSS [27] _S 1_AM 47.33

WSS [27] _S 2_AM 48.05

WSS [26] _S 3_AM 45.97

DHSN [28] _S 1_AM 53.11

DHSN [28] _S 2_AM 55.14

DHSN [28] _S 3_AM 55.20

表 2 采用 PASCAL VOC 2012 验证集.PASCAL VOC 数据库提供了验证集的准确类别标签,因此表 2 的实

验根据图像的类别标签来生成注意力图,并且通过算法 2 生成伪像素标签.从表 2 可以看出,本文所提出的注意

力图获取方法可以准确地提供图像中对象的位置信息,并且可以区分出图像中不同类别的对象(表 2,方法

“AM”).同时,采用逐次擦除法获取的显著图与注意力图融合,可以生成更加精确的伪像素标注.WSS [27] 方法基

于图像级标签训练模型,DHSN [28] 基于无类别(class-agnostic)的前景标注训练神经网络.这两个模型关注图像的

前景对象,不具有任何语义信息.从而将具有类别信息的注意力图与显著图融合,可以提高伪像素标注的准确

性.通过 WSS 方法获取的显著图与注意力图融合方法(表 2,方法“WSS [27] _S 1 _AM”)使平均 IoU 值提高了 7 个百

分点.而随着逐次擦除法的不断擦除,除了可以检测出当前显著的区域外,还可以检测出更多的对象,从而提升

像素标注的准确性.

从表 2 可以看出,WSS 方法的逐次擦除法在获取 S 2 之后,平均 IoU 值最高(48.05%,表 2,方法“WSS [27] _S 2 _

AM”);而随着擦除次数的增加,其平均 IoU 值有所下降(45.97%,表 2,方法“WSS [27] _S 3 _AM”).这说明过多次的擦

除使得背景图像被检测,到从而降低了准确度.DHSN 方法在获取 S 3 之后,平均 IoU 值达到 55.20%,只比获取 S 2

的平均 IoU 值多 0.06 个百分点.从而说明显著图 S 2 已经检测到图像中存在的大部分前景对象.

图 4 列出了图像基于上述方法获取的分割结果.

图 5 展示了 WSS 方法和 DHSN 方法经过不同次数擦除后获取的显著图,可以看出,逐次擦除法可以检测出

图像中的更多前景对象.