Page 332 - 《软件学报》2020年第11期

P. 332

李阳 等:基于对象位置线索的弱监督图像语义分割方法 3647

其中,w 1 ,γ α ,γ β ,w 2 ,γ δ 为模型参数.根据 dense CRF 参数推理方法 [48] ,w 1 ,w 2 ,γ α ,γ β ,γ δ 通过网格搜索技术(grid search)优

化(实验中,w 1 =w 2 =1,γ α =30,γ β =10,γ δ =3).k(f n ,f n′ )的第 1 个核函数依赖于像素位置(表示为 S n )及颜色特征(表示为

T n ),而第 2 个核函数仅依赖于像素的位置特征.Krahenbuhl 等人 [48] 提供了上述能量函数(公式(6)))的近似推理.

最后,经过全连接条件随机场模型的优化,分割结果可以更好地匹配对象的轮廓.

3 实验结果及分析

为了验证本文所提方法能够获得更好的分割结果,本节在 PASCAL VOC 数据集上进行了一系列验证和对

比实验.第 3.1 节详细地描述了实验的各种设置.第 3.2 节~第 3.5 节列出本文所提方法的分割结果.

3.1 实验设置

• 数据集

为了验证本文所提方法的有效性,我们采用 PASCAL VOC 2012 [49] 分割数据集合,包括 20 个前景对象类别

和一个背景类别.其原始分割数据集中有 1 464 幅训练图像、1 449 幅验证图像及 1 456 幅测试图像.遵循现有

方法的惯例 [16,22] ,本文拓展了训练数据集 [50] :10 582 幅图像.与其他方法的对比实验分别在验证集及测试集上进

行.本文方法的实验结果均是通过官方 PASCAL VOC 提供的评估服务器获取.

• 评价指标

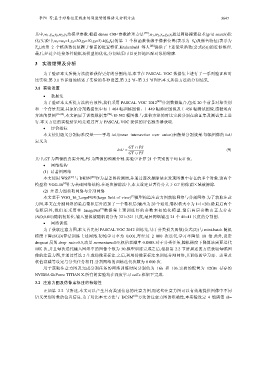

本文使用语义分割标准度量——平均 IoU(mean intersection over union)来衡量分割效果.每幅图像的 IoU

定义为

GT ∩ PS

IoU = (9)

GT ∪ PS

其中,GT 为图像的真实分割,PS 为图像的预测分割.实验中计算 21 个类别的平均 IoU 值.

• 网络结构

(1) 显著图网络

本文使用 WSS [27] 与 DHSN [28] 作为显著图检测器,并通过逐次擦除法来发现图像中存在的多个对象.这两个

[4]

模型将 VGG-16 作为基础网络结构.在逐次擦除法中,本文设定显著得分大于 0.7 的像素区域被擦除.

(2) 注意力图获取网络与分割网络

[9]

本文基于 VGG_16_LargeFOV(large field of view) 模型构造注意力图获取网络与分割网络.为了获取注意

力图,本文在分割网络的最后卷积层外追加了一个卷积层(输出为 20 个通道,卷积核大小为 1×1×20).除最后两个

[3]

卷积层外,我们还采用在 ImageNet 数据集上预训练好的参数来初始化模型.最后两层参数由正太分布

(N(0,0.01))随机初始化.输入图像被随机切分为 321×321 尺度,最后网络输出 21 个 41×41 尺度的分割图.

• 网络训练

为了获取注意力图,本文首先用 PASCAL VOC 2012 训练集,基于分类损失函数(公式(2))与 mini-batch 随机

梯度下降(SGD)算法训练上述网络.初始学习率为 0.001,每经过 2 000 次迭代,学习率降低 10 倍.此外,设定

dropout 层的 drop_rate=0.5,动量 momentum=0.9,权值衰减率 0.0005.对于分类任务,随机梯度下降算法需要迭代

10K 次,并且每次迭代输入网络中的图像个数为 30.模型训练完成之后,根据第 2.2 节所描述的方法获取每幅图

像的注意力图,并通过算法 2 生成伪像素标注.之后,利用伪像素标注来训练分割网络,其训练的学习率、动量及

权值衰减等设定与分类任务相同.分割网络的训练迭代次数为 8 000 次.

用于获取注意力图及完成分割任务的网络训练时间分别约为 16h 和 10h.实验的配置为 12GB 显存的

NVIDIA GeForce TITIAN X.所有的实验均在深度学习 caffe 框架下完成.

3.2 注意力图及伪像素标注的有效性

正如第 2.2 节所述,本文可以产生具有类别信息的注意力图,而这些注意力图可以有效地提供图像中不同

语义类别对象的位置信息.为了对比本文方法与 DCSM [45] 方法的注意力图的准确性,本实验设定 4 组阈值 th=