Page 329 - 《软件学报》2020年第11期

P. 329

3644 Journal of Software 软件学报 Vol.31, No.11, November 2020

定位对象的位置.受该方法的启发,本文提出了具有空间类别得分概念和分类/分割共享网络结构的注意力图生

成方法,从而避免了额外构建分类网络的过程.此外,考虑到 Simonyan 等人的方法存在梯度减弱或者消失等问

题,本次采用空间类别得分对网络中间特征层的导数值作为注意力图,从而可以有效地保留更多的高层语义并

获取更加准确的对象位置信息.

为了获取图像中对象的注意力图,我们在分割网络最后的卷积层之后再加入一个卷积层(卷积核尺寸为

1×1×|C′|,对于 PASCAL VOC 数据集,|C′|=20)和一个全局平均池化层,用于获取图像的|C′|个类别得分.正如 Oqual

等人 [47] 将多标签分类问题看作|C′|个独立的二分类问题来训练网络参数,那么当前图像分类任务的损失函数为

)

P

Loss ( ) θ =− 1 ∑ log ( | c X − 1 ∑ log(1 P c X− ( | )) (2)

c | Z | cZ | Z | c Z

∈

∈

\ ′

其中,Z 为图像真实的语义类别集, Z = CZ 为图像中缺失的语义类别集,P(c|X)为网络预测的类别概率.根据公

式(2)训练卷积神经网络,就可以得到每幅图像的类别得分,同时还可以得到|C′|个类别的对象空间位置得分 H.

该空间类别得分 H 包含了对象在图像的位置信息,它虽然不能提供精准的对象定位线索,但是它可以在二维空

间范围内给出对象在不同位置的类别得分.因此,不同于 Simonyan 等人的方法 [25] 使用图像类别得分对图像求导

数,本文通过阈值化的 H 对中间卷积层的特征求导数.语义类别 c 的空间类别得分 H c 尺度为 w×h,根据设定好的

阈值(实验中,threshold=0.8):如果 H , ij > threshold (i∈ {1,2,..., },w j ∈ {1,2,..., })h ,则 H , ij =1;否则 H , ij =0.那么 H c 对

c c c

0

第 n 层特征 L n 在激活值 L 的导数为

n

∂ H

n

V = c (3)

c ∂ L

n 0 n L

n

n

其中, V 通过网络反向传递过程计算得到.因为网络的最大池化(max pooling)运算使得 V 的尺度要小于原始

c c

n

n

图像的尺度,所以下一步通过上采样方法将V 恢复为原始图像的尺度(W×H),记为W .那么第 n 层的注意力图

c c

A ∈ c n R W H × , A c n ,,i j = max |W c i ki ,, j | .其中,k n 表示第 n 层特征的通道(channel)个数,k i 表示第 n 层特征的第 k i 个通道,

n k

n

i,j 分别为二维空间的坐标.最后,将注意力图 A 归一化.

c

n

对于图像的类别标签 Z 中的每个语义类别 c,上述方法都可以生成第 n 层的注意力图 A .为了更准确地区

c

分每个类别的注意力图,并且解决不同类别的注意力图相互重叠的问题,我们借鉴了 DCSM 方法 [45] ,将当前类别

n

c 的注意力图 A 减去其他语义类别 Z\c 的注意力图,从而去掉其他语义类别的噪声:

c

A ni ,, j = max(A n ,,i j − ∑ A ni , , j ,0) [c ≠ c′ ] (4)

c cZ c c′

′∈

, ij

最后整合各个层的注意力图,生成类别 c 的注意力图 A :

c

A , ij = 1 ∑ tanh(A n , ,i j ) (5)

c nL c

∈

|| L

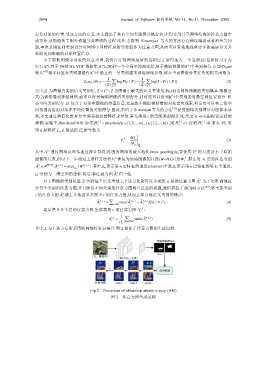

其中,L 为上述方法所采用的网络特征层集合.图 2 描述了注意力图的生成过程.

Fig.2 Procedure of obtaining attention map (AM)

图 2 注意力图生成过程