Page 198 - 《软件学报》2020年第11期

P. 198

3514 Journal of Software 软件学报 Vol.31, No.11, November 2020

H-TSK-FS 的分类性能由原始特征信息,上一层部分样本点构成的特征信息以及所有层的部分决策信

息.为了打开训练数据的流形结构,同时使训练数据结构发生较大的改变,我们应该考虑融合的特征数

不易过大.更重要的是,我们认为,在大多数情况下,NL 可能是一个较小的整数.

• 分析 2:我们认为原始训练样本信息、上一层部分样本点构成的特征信息以及所有已训练完成的部分

决策信息在一定程度上可以打开原始输入空间的流形结构.所有已训练完成的决策信息可以作为当

前层的融合特征,这种模式可以实现预期增强的分类性能.同时,训练原样本空间中的部分样本点在一

定程度上也可以降低计算成本,提高分类性能.换句话说,当前训练模块的部分决策信息既被投影到下

一个训练模块输入空间中,同时也作为下一个训练模块输入空间的融合特征.这种训练方式对下一个

训练模块实际上起到双层保护的作用,提高了整个系统的分类性能和泛化性能.

2.3 时间复杂度对比分析

整个 H-TSK-FS 的时间复杂度分为两部分:第 nl 个训练模块的时间复杂度以及整个 H-TSK-FS 的时间复杂

度.根据算法 1,第 nl 个训练模块的时间复杂度大致由以下几部分组成:生成 TR nl 的时间复杂度为

’

O(c(d+d +nl)K nl ),这里,d 是原始样本相应特征数, d′ 是选取部分样本点的特征数, K 的是模糊规则数.对于 MR

nl

nl

的时间复杂度表示为 ((Od + d′ + nl )K nl ) ,计算矩阵 H 的时间复杂度 (OcN (d + d′ + nl ) K nl ) ,计算β nl 时间复杂度

2

nl

是 (ON + 3 nl NK + nl K nl ) ,因此,训练第 nl 个单元时间复杂度大致可以表示为 (OcN (d + d ‘ + )nl K + 2 nl N nl 3 ).

根据算法 2,由于 H-TSK-FS 的深度是 NL,所以,训练 H-TSK-FS 的时间复杂度大致是:

⎛ NL 3 ⎞

2

O ⎜ (cN (d + d + ' nl ) K + nl N nl ⎟∑ ) .

⎝ nl= 1 ⎠

很明显,当 N 不是很大而模糊规则数 K 比较小时,训练 H-TSK-FS 的时间复杂度可以看成是线性的.

3 实验和结果

本小节通过实验展现 H-TSK-FS 的性能.我们采用 UCI(https://archive.ics.uci.edu/ml/datasets.html)数据集中

的 5 个数据集,同时选取零阶和一阶 TSK 模糊分类器以及 KEEL 软件工具箱中两个优化的模糊分类器

(FURIA&C4.5),目的是用这些算法与 H-TSK-FS 进行对比.关于 KEEL 更多的信息可以参考 http:www.keel.es/

download.php.表 1 展示了这些二分类/多分 类 UCI 数据集以及现实世界案例数据集 Bank-Marketing

dataset [19,20] .在本实验中,所有数据集都预先归一化处理,并且随机抽取每个数据集中的 75%的样本用于训练,其

余样本则用于测试.本研究中,使用分类精度和训练/测试时间作为性能指标来评估所有对比方法的性能.本实

验在具有 64GB 内存的 E5-2609 v2 2.5GHZ CPU(2 个处理器)的计算机上进行.

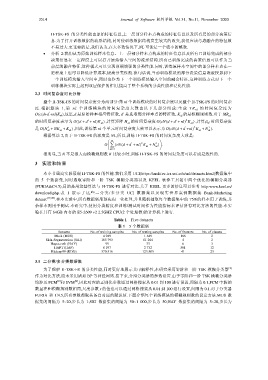

Table 1 Five datasets

表 1 5 个数据集

Datasets No. of training samples No. of testing samples No. of features No. of classes

Musk (MUS) 4 949 1 649 168 2

Skin-Segmentation (SKI) 183 793 61 264 4 2

Hayes-roth (HAY) 99 33 6 3

HAPT (HAP) 8 197 2 732 561 12

Kddcup99 (KDD) 370 516 123 505 41 23

3.1 二分类/多分类数据集

为了观察 H-TSK-FS 的分类性能,同时更好地展示其可解释性,本研究采用零阶和一阶 TSK 模糊分类器 [2]

作为对比方法,而未采用诸如 BP 等神经网络.接下来,介绍分类器的参数设置.由于零阶和一阶 TSK 模糊分类器

[2]

[2]

均涉及 FCM 和 SVM ,因此对应的正则化参数通过网格搜索从 0.01 到 100 进行设置,间隔为 0.1,FCM 中簇的

数量在和模糊规则数相同,尺度参数 r 的值也可以通过网格搜索从 0.01 到 100 进行设置,间隔为 0.1.对于分类器

FURIA 和 C4.5,所有参数都取其各自对应的默认值.下面介绍每个训练模块的模糊规则数的设定方法.MUS 数

据集的间隔为 5~20,步长为 1;SKI 数据集的间隔为 50~1 000,步长为 50;HAY 数据集的间隔为 5~20,步长为