Page 195 - 《软件学报》2020年第11期

P. 195

周塔 等:基于训练空间重构的多模块 TSK 模糊系统 3511

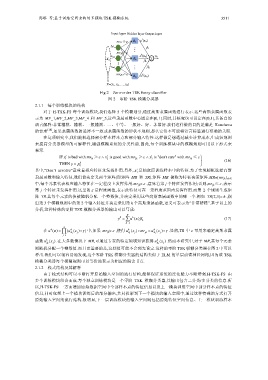

Input layer Hidden layer Output layer

1

mr 11≥ R 1 u (x n)

x n1

1

mr 2k≤ k

x n2 u (x n) y n

X n R k

k

x nd K

mr dK≥ K

R K u (x n)

X=(x 1, x 2, …, x d)

Fig.2 Zero-order TSK fuzzy classifier

图 2 零阶 TSK 模糊分类器

2.1.1 每个训练模块的结构

对于 H-TSK-FS 每个训练模块,我们选择 5 个模糊划分,通过高斯隶属函数进行表示.这些高斯隶属函数表

示为 MF_1,MF_2,MF_3,MF_4 和 MF_5,这些隶属函数中心固定在[0,1].同时,其核宽也可设定在[0,1],其各自的

语言解释:非常糟糕、糟糕、一般糟糕、…、中等、一般好、好、非常好.我们这样做的目的是满足 Kuncheva

的要求 [18] ,如果隶属函数的选择不一致或隶属函数的形状不规则,那么它们不可能将语言标签进行准确的关联.

在这项研究中,我们随机选择部分样本样本点和部分输入特性.这样做是想通过减少计算成本,生成短规则

来提高分类器模型的可解释性,增强模糊系统的分类性能.因此,每个训练模块中的模糊规则可用以下形式来

表示.

IF is bad with x′ mr ≥ ε ∧ x′ is good with mr ≥ ε x′ is "don't care" with mr ≤ ε ∧ ⎫ ⎪

1 1k 2 2k 3 3k ⎬ (16)

THEN y = p 0 k ⎪ ⎭

其中,“Don’t involve”意味着相应特征未发挥作用.另外, ′ x 是抽取原训练样本中的特征.为了实现随机选择高斯

i

隶属函数和输入特征,我们首先定义两个矩阵(即矩阵 MR 和 TR).矩阵 MR 被称为特征决策矩阵.MR=[mr jk ] d×K

ε

中,每个元素代表相应输入特征在一定程度上发挥作用.mr jk > ε ,意味着第 j 个特征发挥作用;否则,mr jk ≤ ,表示

第 j 个特征未发挥作用.这里的 ε 是程度阈值,表示此特征可在一定程度范围内发挥作用.而第 2 个规则生成矩

阵 TR.其每个元素的值被随机分配一个整数值,并决定采用这些高斯隶属函数中的哪一个.例如 TR[2,3]= h ,指

出第 3 个模糊规则中的第 2 个输入特征并决定采用第 h 个高斯隶属函数,语义可表示为“非常糟糕”.基于以上的

分析,这种特殊的零阶 TSK 模糊分类器的输出可以写成:

K

0

y = ∑ u k ()βx k (17)

k = 1

d

() = ∏

k

在 u x (u k i A ( )x ) γ 中,如果 mr jk > ε ,使得 u k i A ()x j mr = u k i A ( )x j γ .显然,TR 中 ε 可用来确定高斯隶属

jk

j

j= 1

函数 u k ()x .在大多数情况下 MR,可通过专家的特定领域知识获得 u k ()x .然而本研究中,对于 MR,其每个元素

i A j i A j

则随机分配一个整数值.而且更重要的是,这些值可能不会预先设定.这样的零阶 TSK 模糊分类器在图 2 中可以

看出.我们可以很容易地发现,这个零阶 TSK 模糊分类器的结构类似于 ELM 的单层前馈神经网络,因为该 TSK

模糊分类器每个模糊规则可以等价地表示为相应的隐含节点.

2.1.2 栈式结构及其解释

由于栈式结构可以不断打开原始输入空间的流行结构,能够保证系统的泛化能力不断增强.H-TSK-FS 由

多个训练模块组合而成.每个独立训练模块是一个零阶 TSK 模糊分类器,其输出包含二分类/多分类的信息.所

以,H-TSK-FS 一方面增加原始数据空间中全部样本点的特征信息以及上一模块训练空间中部分样本点的特征

信息,同时包括上一个模块训练后的部分输出,共同投影到下一个模块的输入空间中,通过这种特殊的方式打开

原始输入空间的流行结构.很明显,下一层训练模块的输入空间既包括原始特征空间信息、上一模块训练样本