Page 26 - 《软件学报》2020年第9期

P. 26

葛道辉 等:轻量级神经网络架构综述 2647

输入 Block Block Block Block Block Block Block

图像 1 2 3 4 5 6 7 输出

Layer Layer Layer Layer

2-1 ... 2-N 2 4-1 ... 4-N 4

F 2 F 4

CONV CONV DCONV SE CONV

3*3 1*1 5*5 0.25 1*1

Fig.25 Decomposition of hierarchical search space

图 25 分解层次搜索空间

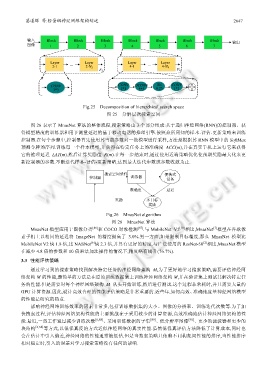

图 26 表示了 MnasNet 算法的整体流程,搜索策略由 3 个部分组成:基于递归神经网络(RNN)的控制器、获

得模型精度的训练器和用于测量延迟的基于移动电话的推理引擎.按照众所周知的样本-评估-更新策略来训练

控制器.在每个步骤中,控制器首先使用其当前参数对一批模型进行采样,方法是根据其 RNN 模型中的 SoftMax

预测令牌的序列.训练每一个样本模型,并获得在特定任务上的准确度 ACC(m),并在真实手机上运行它来获得

它的推理延迟 LAT(m).然后计算奖励值 R(m).在每一步结束时,通过使用近端策略优化使预期奖励最大化来更

新控制器的参数.不断迭代样本-评估-更新策略,达到最大迭代步数或参数收敛为止.

搜索空间采样 便携式

控制器 训练器 设备

准确度 延迟

奖励 多目标

奖励

Fig.26 MnasNet algorithm

图 26 MnasNet 算法

[7]

MnasNet 模型应用于图像分类 [86] 和 COCO 对象检测 [87] .与 MobileNet V2 [10] 相比,MnasNet 模型在谷歌像

素手机上以相同的延迟将 ImageNet 的精度提高了 3.0%.另一方面,如果限制目标精度,那么 MnasNet 模型比

[6]

[2]

MobileNet V2 快 1.8 倍,比 NASNet 快 2.3 倍,并具有更好的精度.与广泛使用的 ResNet-50 相比,MnasNet 模型

在减少 4.8 倍的参数和 10 倍乘法加法操作的情况下,精度略有提升(76.7%).

3.3 性能评估策略

通过学习到的搜索策略找到解决特定任务的神经网络架构 M,为了更好地学习搜索策略,需要评估神经网

络架构 M 的性能,最简单的方法是在原始训练数据集上训练神经网络架构 M,并在验证集上测试其解决特定任

务的性能.但是需要对每个神经网络架构 M 从头开始训练,然后进行测试.这个过程非常耗时,并且需要大量的

GPU 计算资源.因此,设计高效合理的性能评估策略是非常重要的.近些年,如何高效、准确地度量神经网络模型

的性能是研究的热点.

影响神经网络训练效率的因素非常多,包括训练数据集的大小、图像的分辨率、训练迭代次数等.为了加

快搜索过程,评估神经网络架构性能的主要挑战在于采用较少的计算资源,高效准确地估计神经网络架构的性

能.最近,一些工作通过减少训练次数 [6,88] 、采用训练数据的子集 [89] 、低分辨率图像 [90] 、更少的滤波器和更少的

块结构 [6,54] 等方式,以低保真度的方式近似神经网络的真实性能.虽然低保真评估方法降低了计算成本,同时也

会在估计中引入偏差,神经网络的性能通常被低估.但是当搜索策略只依赖不同构架间性能的排序,当性能排序

相对稳定时,引入的误差对学习搜索策略没有任何的影响.