Page 37 - 《软件学报》2020年第10期

P. 37

徐梦炜 等:面向移动终端智能的自治学习系统 3013

3.6 应用实例

我们基于 AutLearn 构建了两个应用实例以验证其功能及效果.

3.6.1 输入法中的词预测

输入法是移动设备上最为重要的应用之一.输入法应用的主要功能之一是输入词预测:以英文输入法为例,

基于用户已有的输入序列(包括单词和字母),预测用户想要的输入词.词预测功能在大部分主流输入法应用,如

Gboard 中都基于神经网络实现,是自然语言处理任务中最常见的任务之一.当前处理该任务的主流算法之一是

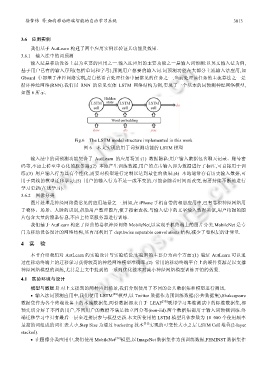

循环神经网络(RNN).我们以 RNN 的常见变体 LSTM 网络结构为例,实现了一个基本的词预测神经网络模型,

如图 6 所示.

Fig.6 The LSTM model structure implemented in this work

图 6 本文实现的用于词预测功能的 LSTM 模型

输入法中的词预测功能契合了 AutLearn 的应用场景:(1) 数据隐私:用户输入数据包含聊天记录、账号密

码等,不应上传至中心化的服务器;(2) 本地产生训练数据,用户的点击输入即为数据进行了标注,可直接用于训

练;(3) 用户输入行为具有个性化,需要对模型进行定制以达到最佳的效果;(4) 本地通常存有历史输入数据,可

用于离线的模型迁移学习;(5) 用户的输入行为不是一成不变的,可能会随着时间而改变,需要持续不断地进行

学习更新(在线学习).

3.6.2 图像分类

图片处理是神经网络最常见的应用场景之一.例如,在 iPhone 手机自带的相册应用中,已有卷积神经网络用

于物体、场景、人脸的识别,帮助用户整理图片,便于搜索查找.与输入法中的文字输入数据类似,用户拍摄的图

片包含大量的隐私信息,不应上传至服务器进行训练.

我们基于 AutLearn 构建了经典的卷积神经网络 MobileNet,以实现手机终端上的图片分类.MobileNet 是专

门为移动设备设计的网络结构,其内部利用了 depthwise separable convolutions 结构,减少了卷积层的计算量.

4 实 验

本节介绍我们对 AutLearn 的实验设计与实验结论.实验目的主要分为两个方面:(1) 验证 AutLearn 可以通

过在移动终端上的迁移学习获得较高的神经网络模型准确率;(2) 常用的移动终端平台上的硬件资源足以支撑

神经网络模型的训练,尤其是上文中提到的一系列优化技术对减小神经网络模型训练开销的效果.

4.1 实验环境与设计

模型与数据.针对上文提到的两种应用场景,我们分别使用了不同的公共数据集和模型进行测试.

• 输入法词预测应用中,我们使用 LSTM [29] 模型,以 Twitter 数据作为预训练数据(公共数据集),Shakespeare

数据集作为各个终端设备上的本地数据集.两份数据都来自于 LEAF [30] 联邦学习基准测试中的标准数据集,都

预先切分好了不同的用户,不同用户的数据不满足独立同分布(non-iid).两个数据集都用于输入词预测训练.终

端迁移学习中只有最后一层全连接层参与模型更新.本文所使用的 LSTM 模型具体参数为 10 000 个使用频率

最高的词组成的词汇表大小,Step Size 为通过 bucketing 技术 [31] 实现的可变长大小,2 层 LSTM Cell 堆叠(2-layer

stacked).

• 在图像分类应用中,我们使用 MobileNet [32] 模型,以 ImageNet 数据集作为预训练数据,FEMINST 数据集作