Page 191 - 《软件学报》2026年第1期

P. 191

188 软件学报 2026 年第 37 卷第 1 期

( ) ( )

′ ′

ˆ Z = ˆ Z+∆ 1 , ˇ Z = ˇ Z+∆ 2 , ˆ Z = ˆ Aσ ˆ A ˆ XW 1 W 2 , ˇ Z = ˇ Aσ ˇ A ˇ XW 1 W 2 (9)

其中, ∆ 1 、∆ 2 代表随机噪声. 对比公式 (8) 和 (9), 可以发现它们本质上都是给嵌入表征添加随机噪声. 不同的是,

公式 (8) 通过间接方式添加噪声, 而公式 (9) 则直接对嵌入表征添加噪声.

AFGRL 是一种摒弃了负样本对和图数据增强的图对比学习算法. 具体来说, 它设计了非对称的图神经网络编

码器 (我们将在第 3.2 节进行具体介绍), 从而使得模型仅需要对比正样本对. 此外, 在构造正样本对时, 它通过邻

接矩阵、k-NN 和 k-means 方法形成每个节点的正样本节点. 最终, AFGRL 的优化目标形式化定义如下所示:

1 ∑ Z i H T j

|V| ∑

L = − (10)

|V| ||Z i ||·||H j ||

i=1 j∈P i

其中, P i 表示由邻接矩阵、k-NN 和 k-means 这 3 种方法得到的节点 i 的正样本节点集, Z i 、H j 表示两个非对称编

码器得到的节点嵌入表征.

3.2 基于不同图神经网络编码器结构的图对比学习方法

当前图对比学习方法中的图神经网络编码器结构主要包括两类: 一类是对称的编码器结构, 另一类是非对称

的编码器结构.

3.2.1 基于对称图神经网络编码器的图对比学习方法

传统的图对比学习算法采用对称的编码器结构, 在这种结构中, 两个通道上的编码器采用了共享参数的形式,

如图 2 所示. 在具有共享编码器参数的图对比学习中, 一个关键思想是使用同一个编码器网络来嵌入正样本对和

负样本对. 该共享编码器负责将节点或子图映射到进行相似性对比的共享潜在空间. 通过共享编码器参数, 模型可

以学习捕捉数据中的常见模式和特征, 使表示更具信息性和可转移性.

DGI [39] 是一个典型的基于对称图神经网络编码器的图对比学习方法. 其主要步骤如下: (1) 通过变形函数得到

˜ ˜ ˇ Z; (4) 基

一个变形图 G; (2) 使用编码器得到输入图 G 的节点嵌入表征 ˆ Z; (3) 使用编码器得到变形图 G 的节点嵌入表征

ˇ Z, 使用 ˆ

于 ˆ Z 和 readout 函数得到输入图 G 的图嵌入表征 G; (5) 根据对比损失函数优化更新编码器中的网络参数.

3.2.2 基于非对称图神经网络编码器的图对比学习方法

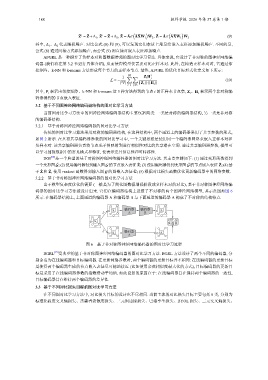

出于模型复杂度优化的需要 (一般是为了简化图数据增强阶段或负样本对的对比), 基于非对称图神经网络编

码器的图对比学习方法被设计出来. 它们在编码器结构上设置了不对称的两个图神经网络模型, 其示意图如图 6

所示. 在编码器结构上, 上面通道的编码器 A 和编码器 B 与下面通道的编码器 A 构成了不对称的结构特点.

X i ˆ 编码器 编码器 Z i ˆ

ˆ θ A B

对比损

X i

失函数

θ ˆ ˆ 编码器 ˆ

A

X i Z i

图 6 基于非对称图神经网络编码器的图对比学习流程

[73]

BGRL 是典型的基于非对称图神经网络编码器的图对比学习方法. BGRL 方法设计了两个不同的编码器, 分

别命名为在线编码器和目标编码器. 在更新网络参数时, 两个编码器的更新目标并不相同: 在线编码器的更新目标

是使得两个编码器生成的节点嵌入表征尽可能地接近 (比如使用余弦相似度最大化的方式), 目标编码器的更新目

标是采用了在线编码器参数的指数滑动平均值. 如此设置的原因在于: 在线编码器旨在保持两个编码器的一致性,

目标编码器旨在维持两个编码器的差异性.

3.3 基于不同对比损失目标的图对比学习方法

在不同图对比学习方法中, 对比损失目标的设计也不尽相同. 当前主流的对比损失目标主要包括 8 类, 分别为

标准化温度交叉熵损失、杰森香农散度损失、三元组边缘损失、巴洛孪生损失、BYOL 损失、二元交叉熵损失、