Page 188 - 《软件学报》2026年第1期

P. 188

刘子扬 等: 图对比学习方法综述 185

不同节点嵌入表征的距离. 尽管用的是表征距离而非表征相似度, 但它们的本质思想仍然是拉近同一节点的嵌入

表征同时拉远不同节点的表征, 故它们的形式化和公式 (3) 十分相像, 这里就不再赘述.

以上 3 个图对比学习阶段基于原始图 G, 计算出了对比损失函数 L 的具体值. 基于深度学习中常用的随机梯

度下降方法和 Adam 优化器, 不断更新编码器的网络参数 W 1 、 W 2 . 在模型训练结束之后, 编码器直接对原始图 G

进行嵌入表征的映射, 即可得到 G 上的节点嵌入表征 Z. 作为嵌入表征的初始值, Z 保存了原始图 G 上的一系列自

监督信号引导下学习到的判别性特征, 可直接用作下游任务的输入矩阵.

3 图对比学习方法

以上介绍了图对比学习中的 3 个基本过程, 下面基于这 3 个过程进行图对比学习方法的分类, 分别是: 基于不

同图数据增强策略的图对比学习方法、基于不同图神经网络编码器结构的图对比学习方法、基于不同对比损失

目标的图对比学习方法.

3.1 基于不同图数据增强策略的图对比学习方法

现有的图数据增强策略包括 3 类. 第 1 类是固定式图数据增强, 这类策略往往在图对比学习算法训练之前就

确定好了图增强的参数, 该参数在整个对比训练的过程中保持不变. 第 2 类是可学习式图数据增强, 这类策略相比

于传统的固定式图数据增强更加灵活, 在对比训练的过程中图增强参数不断更新, 以进一步释放图对比学习的潜

力. 第 3 类是无图数据增强的策略, 和前两类策略不同的是, 该策略摒弃了图数据增强环节, 一方面减少了模型结

构的复杂性, 另一方面也降低了使用到不兼容图数据增强策略的风险.

3.1.1 基于固定式图数据增强策略的图对比学习方法

ˆ

ˇ

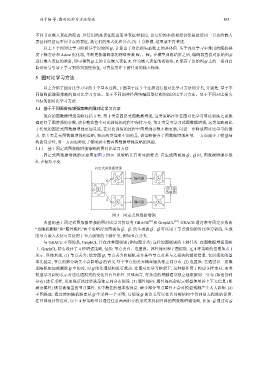

固定式图数据增强的示意图如图 3 所示. 该策略具有明显的特点: 在生成图视角 G、G 时, 图数据增强参数

ˆ θ、 ˇ θ 保持不变.

固定式图数据增强

X i ˆ 编码器 Z i ˆ

θ ˆ

对比损

X i

失函数

θ ˆ ˆ ˆ

X i 编码器 Z i

图 3 固定式图数据增强

典型的基于固定式图数据增强的图对比学习算法有 GRACE [41] 和 GraphCL [40] . GRACE 通过带有固定参数的

ˆ

ˆ ˇ G、G 可以用于节点级别的对比学习训练, 生成

ˇ

“边随机删除”和“属性掩码”两个策略得到图视角 G、G. 所生成的

的节点嵌入表征可直接用于节点级别的下游任务, 例如节点分类.

与 GRACE 不同的是, GraphCL 旨在改善图级别 (例如图分类) 这样的图级别的下游任务. 在图数据增强策略

上, GraphCL 精心设计了 4 种增强策略, 包括: 节点丢弃、边置换、属性掩码和子图提取. 这 4 种策略的信息如表 1

所示. 具体来说, (1) 节点丢弃: 给定图 G, 节点丢弃将随机丢弃某些节点及其与之相关的链接信息. 它所强化的基

G 的语义.每个节点的丢弃概率服从独立同分布. (2) 边置换: 它通过以一定概

本先验是, 节点的部分缺失不会影响

率随机添加或删除 G 中的边, 对 G 的连通结构进行扰动. 在图对比学习框架下, 这种操作用于构建正样本对, 要求

模型学习到的表示对边连通模式的变化具有鲁棒性. 具体而言, 每条边的增删通常独立地依据同一分布 (如伯努利

分布) 进行采样, 从而保证该过程满足独立同分布假设. (3) 属性掩码: 属性掩码会提示模型使用其上下文信息 (即

剩余属性) 恢复被掩盖的节点属性. 其中潜在的基本假设是: 缺少部分节点属性不会对模型预测产生太大影响. (4)

子图提取: 通过使用随机游走从 G 中采样一个子图, 它假设 G 的语义可以在其局部结构中得到很大程度的保留.

在具体设计算法时, 以上 4 种策略可以通过任意两两组合的形式来得到具体的图数据增强策略, 比如: G ˆ 通过对 G