Page 190 - 《软件学报》2026年第1期

P. 190

刘子扬 等: 图对比学习方法综述 187

是最小化两个图视角之间的互信息; 在第 2 阶段, AD-GCL 的优化目标是最大化两个图视角之间的互信息. 这种对

抗训练目标的形式化表示如下:

( ( ( )) ( ( )))

Aug G, ˇ θ (6)

minmaxI GNN W 1 ,W 2 Aug G, ˆ θ ,GNN W 1 ,W 2

ˆ θ, ˇ θ W 1 ,W 2

其中, I (·,·) 表示两个嵌入表征之间的互信息. AD-GCL 主要侧重图级别的下游任务, 因此在图数据增强方法的选

择上, AD-GCL 采用了边删除这一方法, ˆ θ、 ˇ θ 代表了全部边集合中有多少概率的边被删除.

在 LP-InfoMin 和 LP-InfoBN 方法中, 在最大化图视角的嵌入表征一致性时, 它们鼓励两个图视角的互信息最

小化. 因此, LP-InfoMin 和 LP-InfoBN 可以显式地推动生成器以不同的方式工作, 避免嵌入表征出现坍塌危机. 直

观来看, 互信息最小化可以使编码器丢弃更多不相关的信息 (或干扰因素), 以促进模型在下游任务上能够有效泛

化. LP-InfoMin 和 LP-InfoBN 的训练目标形式化定义如下:

( ( ( )) ( ( ))) ( ( ( )) ( ( )))

Aug G , ˇ θ Aug G, ˇ θ

′

Aug G, ˆ θ ,GNN W 1 ,W 2 − I GNN W 1 ,W 2 Aug G, ˆ θ ,GNN W 1 ,W 2

min I GNN W 1 ,W 2

W 1 ,W 2

(7)

( )

′ ′ ′

ˆ θ, ˇ θ = argmin ˆ θ ′ , ˇ θ ′ R G,G , ˆ θ , ˇ θ ,W 1 ,W 2

其中, R(·) 表示奖励函数, G 表示通过负采样得到的除 G 以外的图.

′

3.1.3 无图数据增强的图对比学习方法

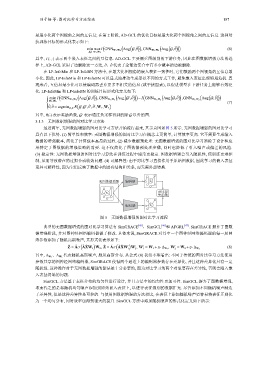

最近两年, 无图数据增强的图对比学习方法开始流行起来, 其示意图如图 5 所示. 无图数据增强的图对比学习

具有以下优势. (1) 简单性和效率: 无图数据增强的图对比学习在概念上更简单, 计算效率更高. 它不需要生成输入

数据的增强版本, 简化了计算成本高昂的过程. (2) 减少数据预处理: 无图数据增强的图对比学习消除了设计和应

用特定于图数据的增强策略的需要. 这不仅简化了图数据预处理步骤, 同时也降低了引入噪声或偏差的风险.

(3) 稳定性: 无图数据增强的图对比学习算法在训练过程中通常更稳定. 图数据增强会引入随机性, 使训练更难控

制, 从而导致潜在的过拟合或收敛问题. (4) 可解释性: 由于对比学习直接作用于原始图数据, 因此学习的嵌入表征

更具可解释性, 因为它们反映了数据中的固有结构和关系, 而无需外部转换.

无图数据增强 编码器 Z i ˆ

对比损

X i

失函数

编码器 Z i ˆ

图 5 无图数据增强的图对比学习流程

典型的无图数据增强的图对比学习算法有 SimGRACE [45] 、SimGCL [46] 和 AFGRL [47] . SimGRACE 摒弃了图数

据增强阶段, 并对图神经网络编码器做了修改. 具体来说, SimGRACE 对其中一个图神经网络编码器的每一层网

络参数添加了随机高斯噪声, 其形式化表示如下:

( ) ( )

′ ′ ′ ′ (8)

2

1 2 1 , W = W 2 +η·∆ W 2

ˆ Z = ˆ Aσ ˆ A ˆ XW 1 W 2 , ˇ Z = ˇ Aσ ˇ A ˇ XW W , W = W 1 +η·∆ W 1

其中, 代表随机高斯噪声, 服从高斯分布. 从公式 (8) 我们不难看出: 不同于传统的图对比学习方法使用

∆ W 1 、∆ W 2

参数共享的图神经网络编码器, SimGRACE 使得两个通道上的编码器参数存在差异化, 并且这种差异化具有一定

随机性. 这种操作对于无图数据增强的算法是十分必要的, 因为对比学习的两个对象要存在差异性, 否则会陷入嵌

入表征坍塌的问题.

SimGCL 方法基于表征分布的均匀性进行设计, 并且方法中的均匀性更加可控. SimGCL 摒弃了图数据增强,

取而代之的是将随机均匀噪声添加到原始嵌入表征上, 以进行表征级别的数据扩充. 尽管添加不同随机噪声制造

了差异性, 但是这种差异性是可控的. 与使用图数据增强的方法相比, 在表征上添加随机噪声更容易将表征正则化

为一个均匀分布, 同时效率也得到很大的提升. SimGCL 方法中添加随机噪声的形式化定义如下所示: