Page 322 - 《软件学报》2025年第12期

P. 322

钱忠胜 等: 结合时间间隔数据增强的对偶视图自监督会话推荐模型 5703

过程. 即, 对于输入的会话序列, 首先使用 3 组可学习的权重矩阵产生 query、key 和 value 表示; 然后计算 attention

分数, 进行 Softmax 操作生成权重系数; 最后加权求和 value 值得到最终的 self-attention 表示. 这一过程使模型可

提取会话序列内项目的位置信息. 前馈全连接子层可捕获序列的局部特征, 与多头自注意力子层的输出表示互补.

这样, 将增强会话和原始会话通过 Transformer 编码器获得相应嵌入表示以实现下游任务.

本节阐述了从会话间 (见第 3.2.1 节) 及会话内 (见第 3.2.2 节) 两个不同视角构建对偶视图编码器, 对原始会

话和增强会话实施多角度建模. 对偶视图编码器构建的具体过程见算法 2.

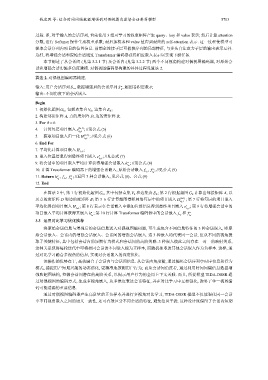

算法 2. 对偶视图编码器构建.

a

输入: 用户会话序列 S u , 数据增强后的会话序列 S , 超图卷积层数 θ;

u

输出: 不同角度下的会话嵌入.

Begin

1. 初始化超图 G h , 包括点集合 V h , 边集合 E h ;

2. 构建邻接矩阵 A, 点的度矩阵 D, 边的度矩阵 B;

3. For ϑ ∈ θ:

4. 计算每层项目嵌入 e (l+1) ; //见公式 (5)

s u ,i

5. 获取项目嵌入归一化 H (l+1) ; //见公式 (6)

s u ,i

6. End For

7. 平均化计算项目嵌入 H s u ,i ;

e ; //见公式 (7)

∗

8. 嵌入位置信息得到最终项目嵌入 s u ,i

h ; //见公式 (8)

a

9. 将会话中的项目嵌入平均计算获得增强会话嵌入

s u

10. 计算 Transformer 编码器下的增强会话嵌入, 原始会话嵌入 f , a ; //见公式 (9)

f s u

s u

a

11. Return h , f , a ; //返回 3 种会话嵌入, 见公式 (8)、公式 (9)

s u f s u s u

12. End

在算法 2 中, 第 1 行初始化超图 G h , 其中包括点集 V h 和边集合 E h ; 第 2 行根据超图 G h 计算出邻接矩阵 A, 以

及点的度矩阵 D 和边的度矩阵 B; 第 3–6 行计算超图卷积网络每层中的项目嵌入 H (l+1) ; 第 7 行将每层的项目嵌入

s u ,i

H s u ,i ; 第 8 e ; 第 9 行将增强会话中的

∗

平均化得到项目嵌入 行表示在会话嵌入中添加位置信息得到最终项目嵌入

s u ,i

a

a

项目嵌入平均计算获得其嵌入 h ; 第 10 行计算 Transformer 编码器中的会话嵌入 f s u 和 f .

s u s u

3.3 运用对比学习优化推荐

将原始会话信息与增强后的会话信息送入对偶视图编码器, 可生成包含不同信息特征的 3 种会话嵌入, 即原

始会话嵌入、会话内的增强会话嵌入、会话间的增强会话嵌入. 这 3 种嵌入均代表同一会话, 但从不同的视角提

取了关键特征, 其中包括会话内的短期行为模式和会话间的高阶关联. 3 种嵌入彼此之间存在一对一的映射关系,

这种关系使得每轮迭代中可将相同会话的不同嵌入视为正样本, 而随机抽取的其他会话嵌入作为负样本. 这样, 通

过对比学习融合多视角的信息, 实现对会话嵌入的深度优化.

该操作的优势在于, 高效融合了会话内与会话间信息. 从会话内角度看, 通过编码会话序列中时序信息和行为

模式, 捕捉用户短期兴趣的动态演化, 更精准地预测用户行为; 而从会话间角度看, 通过利用时间间隔信息数据增

强和超图结构, 挖掘会话间潜在的高阶关系, 以揭示用户行为的全局上下文关联. 而且, 所提模型 TIDA-DSSR 通

过对偶视图的编码方式, 生成多视角嵌入, 从多维度表达会话特征, 并在对比学习中互相强化, 弥补了单一视图编

码可能遗漏的重要信息.

通过对偶视图编码器产生高质量的正负样本并进行多视角对比学习, TIDA-DSSR 模型不仅能强化同一会话

中不同视角嵌入之间的语义一致性, 还可有效区分不同会话的特征, 避免信息干扰. 这种设计既保留了会话内短期