Page 179 - 《软件学报》2025年第12期

P. 179

5560 软件学报 2025 年第 36 卷第 12 期

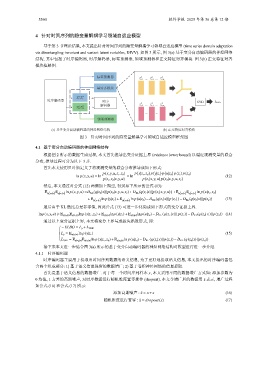

4 针对时间序列的隐变量解耦学习领域自适应模型

基于第 3 节理论结果, 本文提出针对时间序列的隐变量解耦学习领域自适应模型 (time series domain adaptation

via disentangling invariant and variant latent variables, DIVV). 如图 3 所示, 图 3(a) 基于变分自动编码器的神经网络

结构, 其中包括了时序编码器, 时序解码器, 标签预测器, 领域预测器和正交特征对齐模块. 图 3(b) 正交特征对齐

模块框架图.

标签预测器 S S S

··· ··· z c,n c

z c,1 z c,i

基对齐模块

S T

Z c Z c

时序编码器 时序 SVD L RSD

T

T

解码器 z c,1 ··· z c,i T ··· z c,n c

S T

Z d Z d

··· ···

领域预测器

(a) 基于变分自动编码器的神经网络结构 (b) 正交特征对齐模块

图 3 针对时间序列的隐变量解耦学习领域自适应模型框架图

4.1 基于变分自动编码器的神经网络结构

根据图 2 所示的数据生成过程, 本文首先推导出变分证据上界 (evidence lower bound) 以逼近观测变量的联合

分布, 推导过程可分为以下 3 步.

首先本文使用贝叶斯定义了将观测变量的联合分布推导成如下形式:

)

) (

(

) (

p(x,y,u,z c ,z d ) p x|z c ,z d p y|z c p u|z d p(z c ) p(z d )

ln p(x,y,u) = ln = ln ( ) ( ) (12)

p(z c ,z d |x,y,u) p z c |x,y,u p z d |x,y,u,z c

然后, 本文通过对公式 (12) 两侧加上期望, 得到如下所示的公式 (13):

(

(

)

E q( z d |x) E q( z c |x) ln p(x,y,u) =D KL (q(z d |x)||p(z d |x,y,u,z c )+ D KL (q(z c |x)||p z c |x,y,u )+E q( z d |x) E q( z c |x) ln p x|z c ,z d )

(

(

)

)

+E q( z c |x) ln p y|z c +E q( z d |x) ln p u|z d − D KL (q(z c |x)||p(z c ))− D KL (q(z d |x)||p(z d )) (13)

最后由于 KL 散度总是非零值, 因此公式 (13) 可进一步化简成如下形式的变分证据上界.

lnp(x,y,u) ⩾ E q(z d |x) E q(z c |x) lnp(x|z c ,z d )+E q(z c |x) lnp(y|z c )+E q(z d |x) lnp(u|z d )− D KL (q(z c |x)|| p(z c ))− D KL (q(z d | x)||p(z d )) (14)

通过以上变分证据上界, 本文将变分上界写成损失函数形式, 即:

−ELBO = L y + L VAE

L y = E q(z c |x) ln p(y|z c ) (15)

L VAE = E q(z d |x) E q(z c |x) ln p(x|z c ,z d )+E q(z d |x) ln p(u|z d )− D KL (q(z c |x)||p(z c ))− D KL (q(z d |x)∥p(z d ))

接下来本文进一步结合图 3(a) 所示的基于变分自动编码器的神经网络结构对模型进行进一步介绍.

4.1.1 时序编码器

时序编码器主要用于提取出时间序列数据的语义信息, 为了更好地提取语义信息, 本文提出的时序编码器包

含两个组成部分: 1) 基于语义信息保留的数据增广; 2) 基于卷积神经网络的信息提取.

x, 本文采用不同的数据增广方式如: 添加参数为

首先是基于语义信息的数据增广. 对于每一个时间序列样本

0 均值, 1 方差的高斯噪声, 对时序数据进行随机维度置零操作 (dropout). 本文令增广后的数据用 ˜ x 表示, 增广过程

如公式 (16) 和公式 (17) 所示:

添加高斯噪声 : ˜x = x+ϵ (16)

随机维度进行置零 : ˜x = dropout(x) (17)