Page 411 - 《软件学报》2025年第9期

P. 411

4322 软件学报 2025 年第 36 卷第 9 期

能是否有促进作用; model3 表示去除基于掩码注意力机制的图卷积网络组件的 SAMG-LP 算法, 探究空间特征对

链路预测性能的重要程度; model4 表示将融合注意力网络换为直接对不同粒度时空特征相加融合的 SAMG-LP

算法, 探究融合不同粒度的注意力网络组件的有效性; model5 表示将稀疏惩罚损失函数替换为 MSE 损失函数的

SAMG-LP 算法, 探究网络稀疏特性对 SAMG-LP 算法预测性能的影响. 消融实验的结果如表 3 所示, 其中加粗部

分表示最佳结果. 可以观察到, 所有变体模型的综合表现都不如 SAMG-LP 算法, 实验表明 SAMG-LP 算法各个组

件的有效性.

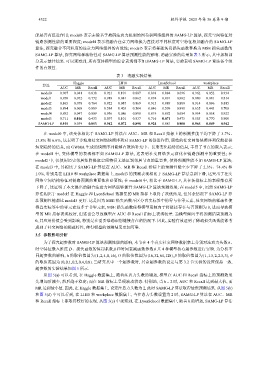

表 3 消融实验结果

Haggle LH10 LyonSchool workplace

算法

AUC MR Recall AUC MR Recall AUC MR Recall AUC MR Recall

model0 0.907 0.041 0.838 0.921 0.101 0.887 0.818 0.084 0.696 0.962 0.052 0.934

model1 0.870 0.072 0.772 0.918 0.081 0.862 0.874 0.091 0.802 0.880 0.081 0.814

model2 0.865 0.078 0.764 0.922 0.087 0.869 0.915 0.089 0.889 0.914 0.096 0.885

model3 0.894 0.068 0.809 0.584 0.403 0.504 0.846 0.509 0.891 0.635 0.443 0.708

model4 0.892 0.047 0.809 0.936 0.086 0.890 0.819 0.082 0.684 0.954 0.058 0.922

model5 0.711 0.016 0.433 0.897 0.101 0.837 0.716 0.071 0.475 0.585 0.770 0.900

SAMG-LP 0.915 0.039 0.853 0.942 0.072 0.898 0.924 0.081 0.900 0.965 0.049 0.942

在 model0 中, 该变体相比于 SAMG-LP 算法在 AUC、MR 和 Recall 指标上的预测性能平均下降了 3.7%、

13.8% 和 6.6%, 这表明了多粒度社交网络快照序列对 SAMG-LP 的促进作用, 原始的社交网络快照序列仅能提供

短期趋势的信息, 而 GWMA 生成的快照序列能够有效地补充中、长期变化趋势的信息, 丰富了节点的嵌入表示;

在 model1 中, 变体模型的表现都不如 SAMG-LP 算法, 这表明社交网络多元演化在链路预测中的重要性; 在

model2 中, 仅使用历史邻居矩阵提取空间特征无法区别邻居节点的重要性, 使得预测性能不如 SAMG-LP 算法;

在 model3 中, 其相比于 SAMG-LP 算法在 AUC、MR 和 Recall 指标上的预测性能至少下降了 2.3%、74.4% 和

1.0%, 特别是在 LH10 和 workplace 数据集上, model3 的预测表现相比于 SAMG-LP 算法急剧下滑, 这突出了社交

网络空间结构特征对链路预测的重要性和必要性; 在 model4 中, 相比于 SAMG-LP, 其在各指标上的表现都有所

下降了, 这证明了本文提出的融合注意力网络能够提升 SAMG-LP 算法预测效果; 在 model5 中, 虽然 SAMG-LP

算法相比于 model5 在 Haggle 和 LyonSchool 数据集的 MR 指标上取得了次优结果, 但其余情况下 SAMG-LP 算

法预测性能都比 model5 更好. 这是因为 MSE 损失函数不区分真实标签中的零与非零元素, 社交网络的稀疏性使

得真实标签中的零元素远多于非零元素, MSE 损失函数使得模型更倾向于将链接存在与否预测为 0, 进而导致模

型的 MR 指标表现较好, 但这也会导致模型在 AUC 和 Recall 指标上表现较差. 当模型倾向于将预测结果预测为

0, 其应用价值会受到影响, 特别是在需要准确识别链接存在的情况下. 因此, 实验有效证明了稀疏损失函数能够考

虑到了社交网络的稀疏特性, 使得模型的预测结果更加可靠.

3.5 参数影响分析

为了探究超参数对 SAMG-LP 算法预测性能的影响, 本节在 4 个真实社交网络数据集上分别对注意力头数 h、

时空特征嵌入维度 D、损失函数的惩罚系数 β 和时间衰减函数参数 共 θ 4 种模型核心超参数进行实验. 为分析不

同超参数的影响, h 的取值范围为 {1,2,4,8,16}, D 的取值范围为 {16,32,64,128}, β 的取值范围为 {1,1.5,2,2.5,3}, θ

{0,0.1,0.2,0.4,0.8}. 当研究其中一个超参数时, 其余超参数的设定与第 3.2 节实验的设置保持一致.

的取值范围为

超参数的实验结果如图 5 所示.

从图 5(a) 可以看到, 在 Haggle 数据集上, 随着注意力头数的增加, 模型在 AUC 和 Recall 指标上的预测效果

先增加后减少, 然后趋于稳定; 而在 MR 指标上呈现波动状态. 特别地, 当 h = 2 时, AUC 和 Recall 达到最大值, 而

MR 达到最小值. 因此, 在 Haggle 数据集上, 设定注意力头数为 2, 此时 SAMG-LP 算法取得最优预测结果. 从图 5(b)

和图 5(d) 中可以看到, 在 LH10 和 workplace 数据集上, 当注意力头数设置为 2 时, SAMG-LP 算法在 AUC、MR

和 Recall 指标上都取得较好的表现. 从图 5(c) 中观察到, 在 LyonSchool 数据集中, 随着 h 的增加, SAMG-LP 算法