Page 305 - 《软件学报》2025年第9期

P. 305

4216 软件学报 2025 年第 36 卷第 9 期

● VLTVG (visual-linguistic verification for visual grounding) [19] 也是一种基于 Transformer 设计的视觉定位方法,

它设计了一种语言引导的视觉特征聚合方法和多级跨模态解码器, 用以关注图像中与文本描述相关的特征, 同时

抑制与文本不相关的区域特征, 从而提供视觉特征的显著性. 然而, 由于忽略了多层次的模态信息, 其性能仍有待

提高.

● QRNet (query-modulated refinement network) [20] 和 VLTVG 同样希望更多地关注到视觉特征信息. QRNet 认

为视觉分支模型提取的图像特征和多模态推理真正需要的特征是不一致的. 因此, 它通过一个新颖的查询感知动

态注意力 (QD-ATT) 机制和查询感知的多尺度融合策略来调整视觉模型的中间特征, 从而解决不一致问题. 在视

觉模型生成的图像特征图的空间和通道级别中, QD-ATT 可动态计算依赖于文本查询的视觉注意力.

(2) 全监督多模态预训练模型

文本的预训练推动了多模态预训练的发展. 通过在大规模多模态数据上进行预训练, 模型捕捉文本和视觉信

息之间的语义关系的能力得以提升, 从而提高了其在多种多模态下游任务上的性能. 本文选取了两种在 PVG 下游

任务上有优异性能的模型来验证 ICM 方法的潜力.

[7]

● MDETR (modulated detector) 是一种基于 DETR [29] 目标检测网络的预训练模型, 它将 PVG 任务建模为一个

调制检测任务, 使用 130 万个图像文本对 (包含 Flickr30k Entities) 进行预训练, 而这些图像文本对来自现有的多模

态数据集, 且文本中的短语与图像中的区域有明确的对应关系.

[8]

● GLIP (grounded language-image pre-training) 将目标检测任务和 PVG 任务联合训练, 使用了比 MDETR 更

多的 2 700 万个图像文本对 (包含 Flickr30k Entities) 进行预训练, 其中包括 300 万个人工标注的高质量图像文本

对和 2 400 万个网络抓取的图像文本对.

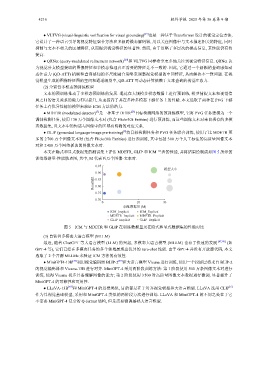

本文在隐式和显式数据集的测试集上评估 MDETR, GLIP 和 ICM 三者的性能, 并将结果绘制成如图 5 所示的

训练数据量-性能散点图, 其中, M 代表百万个图像-文本对.

0.95

模型大小

0.90

Recall@1 0.85

0.80

0.75

0.70

0 20 30

训练数据量 (M)

ICM_Implicit ICM_Explicit

MDETR_Implicit MDETR_Explicit

GLIP_Implicit GLIP_Explicit

图 5 ICM 与 MDETR 和 GLIP 在训练数据量及在隐式和显式数据集的性能对比

(3) 自监督多模态大语言模型 (MLLM)

最近, 随着 ChatGPT 等大语言模型 (LLM) 的兴起, 多模态大语言模型 (MLLM) 也有了快速的发展 [47,48] (如

GPT-4 等), 它们已经在多模态任务的多个领域展现出优异的 zero-shot 性能. 由于 GPT-4 并没有开放源代码, 本文

选取了 2 个开源 MLLMs 来验证 ICM 方法的有效性.

[47] [49]

● MiniGPT4-13B 利用视觉编码器 BLIP-2 和大语言模型 Vicuna 进行训练, 使用一个投影层将来自 BLIP-2

的视觉编码器和 Vicuna-13B 进行对齐. MiniGPT-4 采用两阶段训练方法: 第 1 阶段使用 500 万条图像文本对进行

训练, 使得 Vicuna 初步具备理解图像的能力; 第 2 阶段使用 3 500 对高质量图像文本数据进行微调, 显著提升了

MiniGPT-4 的可靠性和可用性.

● LLaVA-13B [48] 和 MiniGPT-4 的思想类似, 目的都是在于对齐视觉模型和大语言模型. LLaVA 选用 CLIP [6]

作为其视觉基础模型, 采用和 MiniGPT-4 类似的两阶段方法进行训练. LLaVA 和 MiniGPT-4 的不同之处在于它

不需要 MiniGPT-4 复杂的 Q-former 结构, 但是需要微调基础大语言模型.