Page 301 - 《软件学报》2025年第9期

P. 301

4212 软件学报 2025 年第 36 卷第 9 期

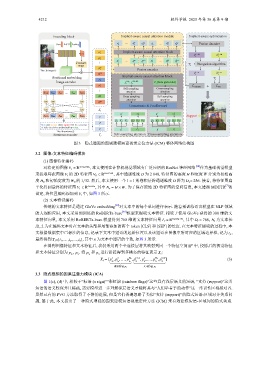

Encoding block Implicit-aware causal attention module Implicit-aware optimization

1 Nv CLS 1 N l SEP Fusion decoder

Conv ReLU Pooling o i v ... o i v o i l o i l ... o i v o i l

1 Implicit-aware causal attention block

1×1 p i v 1...M 1...M

r i b i

2

p i v

1 Nv CLS 1 N l SEP

Feature ... f i v ... f i v f i l f i l ... f i v f i l Hungarian algorithm

map T i

Nv

Fusion encoder

p i v

The i-th image V i

1...n 1...n

CLS

p i l r i b i

Implicit-aware causal attention block

Positional embedding

1 T i

p i l

Image encoder f i v 1...N v f i v CLS...SEP C i (from global dict)

,

2

p i l contrast box

Self-sampling Cross-sampling

...

... attention attention

S [CLS] S Man S and S sign S [SEP]

N l

p i l Cross-sampling Self-sampling

attention attention

trm trm ... trm p i l SEP

Concatenate & Feedforward

trm trm ... trm X i w

f i ′ C i ′ f i ′′ C i ′′

E [CLS] E Man E and ... E sign E [SEP] t i 1 Support (x, y) h

... Q F K F V F Q C K C V C Q F K C V C Q F K C V C

p ...

t i

...

n

t i

f i C i f i C i

The i-th sentence S i

Sentence encoder T i Self-sampling attention Cross-sampling attention

图 3 隐式增强的因果建模短语视觉定位方法 (ICM) 整体网络结构图

3.2 图像-文本特征编码模块

(1) 图像特征编码

V i ∈ R 3×H 0 ×W 0 , 本文使用在计算机视觉领域有广泛应用的 ResNet 神经网络 [38] 作为基础视觉模型

对给定的图像

来提取每张图像 V i 的 2D 特征图 V 0 ∈ R D×H×W , 其中通道维度 D 为 2 048, 特征图的高度 H 和宽度 W 分别为初始高

D v = 256. 接着, 将特征图扁

度 H 0 和初始宽度为 W 0 的 1/32. 然后, 本文使用一个 1×1 的卷积层将通道维度 D 降为

[7]

V i ∈ R Dv×Nv N v = H ×W. 为了保存原始 2D 特征图的空间信息, 本文遵循 MDETR 的

平化得到最终的特征图 , 其中

设定, 将位置编码添加到 V i 中, 如图 3 所示.

(2) 文本特征编码

传统的文本特征是通过 GloVe embedding [39] 对文本中的每个单词进行表示. 随着预训练语言模型在 NLP 领域

的大规模应用, 本文采用预训练的 RoBERTa-base [40] 模型来提取文本特征. 相较于使用 GloVe 获得的 300 维的文

本特征向量, 本文采用 RoBERTa-base 模型得到 768 维的文本特征向量 L i ∈ R D l ×(N l +2) , 其中 D l = 768 N l 为文本长

,

度, 2 为在编码文本时在文本的头部和尾部添加的两个 token [CLS] 和 [SEP] 的长度. 在文本特征提取的过程中, 本

t p ,

文根据数据集中已标注的信息, 记录下文本中短语的起始位置以及该短语在图像中所对应的区域边界框, 记为

最终得到 T i =[t 1 ,...,t p ,...,t n ], 其中 n 为文本中短语的个数, 如图 3 所示.

R 中, 投影后的视觉特征

D

在得到图像特征和文本特征后, 我们采用两个全连接层将其映射到同一个特征空间

和文本特征分别为 p i v , p i l . 将 p i v 和 p i l 进行拼接得到多模态的特征表示 X i :

1

1

2

X i = [p , p ,..., p , p CLS , p ,..., p , p SEP ] (3)

N l

N v

i v i v i v i l i l i l i l

| {z } | {z }

视觉特征 p v 文本特征 p l

3.3 隐式感知的因果注意力模块 (ICA)

图 1(c), (d) 中, 相较于“标语 (a sign)”“彩虹旗 (rainbow flags)”这些具有浅层语义的短语, “支持 (support)”这类

短语的语义较深并且稀疏, 需要模型进一步理解深层语义才能将其与“人们举着手的动作”这一常识性区域相对齐.

虽然已有的 PVG 方法取得了不错的进展, 但是它们普遍忽略了类似“支持 (support)”的隐式短语-区域对齐关系问

题. 基于此, 本文提出了一种隐式增强的因果建模短语视觉定位方法 (ICM) 来有效建模短语-区域间的隐式关系.