Page 288 - 《软件学报》2025年第9期

P. 288

陈建炜 等: 基于掩码信息熵迁移的场景文本检测知识蒸馏 4199

表 4 展示了 MaskET 与对比方法在精确率 P、召回率 R 和 F1 上检验结果. 结果为–1, 代表 MaskET 方法在该

指标上的均值低于对比方法; 结果为 1, 代表在 95% 的置信度下认为 MaskET 方法在对应指标上显著优于对比方

法; 检验结果为 0, 代表 MaskET 方法在对应指标上并不显著优于对比方法. 此外, 我们也在括号中报告了检验得

到的 p 值.

从表 4 可以看出, MaskET 在仅精确率 P 上不显著优于 FitNets、SD 及 IFVD; 仅在召回率 R 上不显著优于

VID. 除此之外, MaskET 在精确率 P 和召回率 R 上都显著优于对比方法, 且在 F1 上显著优于所有对比方法.

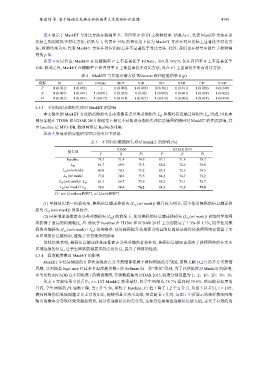

表 4 MaskET 与其他蒸馏方法 Wilcoxon 秩和检验结果 h (p)

指标 ST KA FitNets SKD VID SD SAD CD IFVD

P 1 (0.021) 1 (0.002) −1 1 (0.002) 1 (0.005) 0 (0.381) 1 (0.011) 1 (0.020) 0 (0.240)

R 1 (0.001) 1 (0.001) 1 (0.001) 1 (0.025) 0 (0.42) 1 (0.002) 1 (0.001) 1 (0.028) 1 (0.022)

F1 1 (0.001) 1 (0.001) 1 (0.017) 1 (0.011) 1 (0.021) 1 (0.019) 1 (0.002) 1 (0.021) 1 (0.034)

4.3.3 不同知识蒸馏损失项对 MaskET 的影响

本文提出的 MaskET 方法的蒸馏损失是由逐像素点分类蒸馏损失 L p 和掩码信息熵迁移损失 L e 组成, 因此本

i

t

部分实验在 TD500 和 ICDAR 2015 数据集上探究不同知识蒸馏损失和信息熵图的掩码对 MaskET 的性能影响, 其

中 baseline 是 MV3-DB, 教师网络是 ResNet50-DB.

从表 5 所展示的实验结果可以得出以下结论.

表 5 不同知识蒸馏损失项对 MaskET 的影响 (%)

TD500 ICDAR 2015

损失项

P R F1 P R F1

baseline 78.7 71.4 74.9 87.1 71.8 78.7

81.7 69.9 75.3 86.2 72.6 78.8

L pi

L et (w/o mask) 80.8 70.3 75.2 85.5 72.5 78.5

L et (w/ mask) 77.0 74.0 75.5 84.2 74.7 79.2

83.3 69.7 75.9 85.2 73.1 78.7

L et (w/o mask)+ L pi

L et (w/ mask)+ L pi 78.0 74.4 76.2 84.3 75.8 79.8

注: w/o 是without的缩写, w/ 是with的缩写

(1) 单独使用某一项损失项, 掩码信息熵迁移损失 (L et (w/ mask)) 提升较为明显, 而不使用掩码的信息熵迁移

损失 (L et (w/o mask)) 效果较差.

(2) 同样增加逐像素点分类蒸馏损失 (L pi ) 的情况下, 使用掩码的信息熵迁移损失 (L et (w/ mask)) 训练的学生网

络获得了最高的检测精度, F1 相较于 baseline 在 TD500 和 ICDAR 2015 上分别提高了 1.3% 和 1.1%, 而不使用掩

码的蒸馏损失 (L et (w/o mask)+ L pi ) 效果略差. 使用掩码提升效果更为明显的原因是该操作使教师网络仅保留了文

本区域的信息熵知识, 避免了背景噪声的影响.

这些结果表明, 掩码信息熵迁移是逐像素点分类蒸馏的有效补充, 掩码信息熵知识反映了教师网络的在文本

区域边缘的信息, 让学生网络获得更多的泛化信息, 提升了网络的性能.

4.3.4 温度超参数对 MaskET 的影响

MaskET 中信息熵图的计算和逐像素点分类蒸馏都依赖于教师网络的分割图, 按照文献 [4,25] 的多分类蒸馏

思路, 分割图是 logit map 经过带有温度超参数 τ 的 Softmax 归一化“软化”得到, 为了评估温度对 MaskET 的影响,

本节比较 MV3-DB 在不同温度 τ 的测试精度, 实验数据集为 ICDAR 2015, 温度分别设置为 1、2、10、20、30、50.

从表 6 实验结果可以看出, τ = 1 时 MaskET 效果最好, 将学生网络从 78.7% 提高到 79.8%. 然而随着温度的

升高, 学生网络的 F1 逐渐下降, 当 τ 升至 50, 相较于 baseline, F1 值下降了 1.2 个百分点. 从图 5 以看出, τ = 1 时,

τ 升高, 与图 1 中所展示的那样教师网络

教师网络的信息熵图蕴含更丰富的知识, 能够明显分辨出边缘, 但是随着

输出的概率分布软化效果越加明显, 其分布逐渐接近均匀分布, 这使得信息熵值逐渐接近最大值, 丢失了有效的边