Page 322 - 《软件学报》2025年第7期

P. 322

黄靖 等: 基于特征融合动态图网络的多标签文本分类算法 3243

G = (V,E), 其中, 节点指的是标签, 边是由标签先验共现信息构建的, 如果两个标签之间

方面, 本文定义了一个图

存在共现关系, 则对应节点之间由一条边相连. 接下来利用 LightGCN [39] 在标签共现图上学习标签表示, 最后得到

标签表示 E ∈ R m×d . 公式如下:

1

− 2 ˜

ˆ A = D AD − 2 1 (5)

∑ 1

e (k+1) = √ √ e (k) (6)

i z

|N i | |N z |

z∈N i

其中, D 为节点的度矩阵, 当节点度数为 0, 会存在分母为 0 的问题. 于是本文先对邻接矩阵进行归一化, 其中

˜ A = A+ A , A 为单位对角矩阵, A 为标签共现二值矩阵, 是基于训练集构建的. 若标签 和标签 之间共现次数大

E

E

i

j

于 0, 则 A i j 为 1. e (k+1) 为节点 i 在第 k+1 层的表示, |N i | 是节点 i 的度. 可见节点的表示是通过对其邻居节点的表示

i

进行加权平均来得到的.

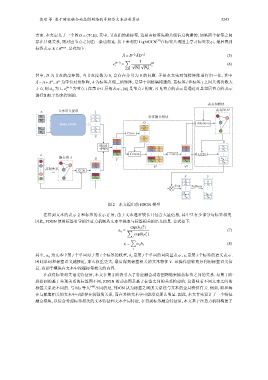

动态图模块

文本语义提取 动态图 A d

x i

W 1 z 1 特征融合模块

z 2

W 2 G

· · · MHA+FNN · · · Attention

W n−1 z 3 v g

v g

z n

Conv · ·

W n ·

Z v g

v 1 v g

U

v 2

MHA · u 1

+FNN · · v 1 v g v 1 u 2

v m−1 v 2 v g v 2

L v m Concat · · · · · · Conv · · · GCN · · ·

静态图 A E v m−1 v g v m−1

V u m−1

v m v g v m

u m

e 1 c V m

· · 共现关系 e 2 · V

· GCN · ·

e m−1

S y

e m

S 1 y 1

diag S 2 Softmax y 2

· ·

· · · ·

S m−1 y m−1

S m y m

图 2 本文提出的 FDGN 模型

在得到文本的表示 Z 和标签的表示 E 后, 由于文本通常较长且包含大量信息, 其中只有少部分与标签相关.

因此, FDGN 使用标签引导的注意力机制从文本中提取与标签相关的语义信息. 公式如下:

T

exp(h j e )

i

α i j = ∑ (7)

T

exp(h j e )

j i

∑

v i = α i j h j (8)

j

其中, α ij 为文本中第 j 个单词对于第 i 个标签的权重, h j 是第 j 个单词的词向量表示, e i 是第 i 个标签的语义表示.

因此单词和标签语义越接近, 那么权重更大, 最后得到标签相关的文本特征 V . 该操作能够充分利用标签语义信

息, 有助于模块在文本中挖掘标签相关的内容.

在获得标签相关语义特征后, 本文在第 2 阶段引入了特征融合动态图网络来捕获标签之间的关系. 与第 1 阶

段提到的基于共现关系的标签图不同, FDGN 的动态图是基于标签之间的关系构建的, 这意味着不同文本之间的

标签关系是不同的. 与 Ma 等人 [40] 不同的是, FDGN 认为标签之间的关系还与文本的全局特征有关. 例如, 船和海

在与航海相关的文本中可能存在较强的关系, 而在其他文本中可能没有那么明显. 因此, 本文首先设计了一个特征

融合模块, 以综合考虑标签相关的文本特征和文本全局特征. 在得到标签融合特征后, 本文基于注意力机制构建了