Page 397 - 《软件学报》2025年第5期

P. 397

王晨旭 等: 基于半监督和自监督图表示学习的恶意节点检测 2297

其中, λ 1 与 λ 2 ∈ [0,1] 为超参, 用于调节局部视图信息与全局视图信息的比例. 将 h (final) 作为分类器 f Θ : h (final) 7→ p

的输入进行下游分类任务, 具体过程如公式 (21) 所示:

( )

p = σ Wh (final) +b (21)

其中, W 和 b 为可训练的参数, σ 为 Softmax 函数.

4.1 基于图扩散的数据增强

常用的图数据增强方法大致可以分为以下两种: (1) 节点特征变换: 通过噪声注入、特征掩码、特征置换等方

式对初始节点特征进行特征空间增强; (2) 图拓扑变换: 通过添加或删除边、添加或删除节点、重采样边权等方式

改变图的拓扑结构, 或使用最短距离或扩散矩阵生成全局视图. 节点特征变换可能会改变图的语义信息, 导致原本

的标签不适用于新生成的样本, 并且其可能会引入一些噪声或者模糊, 降低模型的性能. 而图拓扑变换中的对边或

节点的增加删除等操作可能会导致图数据原本的信息被破坏. 研究表明 [21] , 大多数情况下, 通过图扩散卷积将邻

接矩阵转换为扩散矩阵, 并将两个矩阵视为同一图结构的两个一致视图可以取得最佳结果. 基于这个思路, 本节中

采用基于个性化 PageRank 的图扩散卷积模型, 根据原始图的邻接矩阵得到扩散矩阵, 具体计算方式如公式 (22)

所示:

( ) −1

S PPR = α I n −(1−α)D −1/2 AD −1/2 (22)

A ∈ R n×n α ∈ (0,1) 表示个性化 PageRank α 越小则表示越倾向于利

其中, 表示原始图的邻接矩阵, 中的传送概率,

用大邻域的信息, 而 α 越大则越倾向于保持局域性, I n ∈ R n×n 表示单位矩阵, D ∈ R n×n 为度矩阵, 对角线上的值为每

个节点的度数.

与基于原始邻接矩阵的表示学习不同, 基于上述扩散矩阵进行图节点表示学习, 聚合过程中节点会从更大的

邻域范围内获取信息, 因而学习到的节点表示可以反映图的全局结构和特征. 将扩散矩阵 S PPR 作为原始图 ϕ 1 的全

局视图 ϕ 2 , 并在这两个视图上进行表示学习, 以同时挖掘图中的局部信息与全局信息.

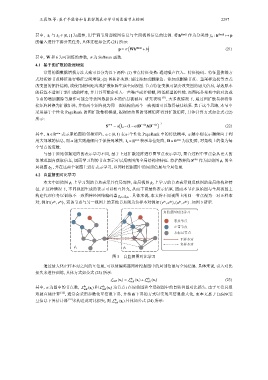

4.2 自监督图对比学习

ϕ 2 上学习的节点表示则反映图的全局结构和特

本文中原始图 ϕ 1 上学习到的节点表示具有局部性, 全局视图

征. 在这种情况下, 不同视图生成的表示可以相互补充, 从而丰富最终表示结果. 因而本节在原始图与全局视图上

. 具体来说, 本文将不同视图上的同一节点视为一对正样本

构建代理任务以训练不一致图神经网络编码器

g ϕ 1 ,g ϕ 2

( ) ( ) ( )

ϕ 1

ϕ 1

ϕ 1

对, 例如 v ,v ϕ 2 , 而该节点与另一视图上的其他节点则为负样本对例如 v ,u ϕ 2 , u ,v ϕ 2 . 如图 3 所示.

自监督图对比学习

恶意节点

正常节点

未标记节点

正样本对

负样本对

ϕ 1

ϕ 2

图 3 自监督图对比学习

通过最大化正样本对之间的互信息, 可以使编码器同时挖掘图中的局部信息与全局信息. 具体来说, 引入对比

损失来进行训练, 具体方式如公式 (23) 所示:

L self (x i ) = L ϕ 1 (x i )+L ϕ 2 (x i ) (23)

self self

i

ϕ 1 ϕ 2

其中, n 为图中的节点数, L (x i ) 和 L (x i ) 为节点 在原始图和全局视图中的自监督图对比损失. 由于互信息很

self self

难被直接计算 [22] , 通常会采用参数化互信息下界, 并抬高下界的方式以实现互信息最大化, 而本文基于 InfoNCE

互信息下界估计器 [22] L ϕ 1 (x i ) 具体如公式 (24) 所示:

来构造此对比损失, 则 self