Page 393 - 《软件学报》2025年第5期

P. 393

王晨旭 等: 基于半监督和自监督图表示学习的恶意节点检测 2293

s 确定. 具体来说, 本文利用特征空间的信息, 引入一个与图结构无关的多层感知机

中得到的节点类型相似度

s v . 如公式 (4) 所示:

(MLP) 从节点的原始特征提取类别信息, 计算每个节点 v 的类别概率分布向量

s v = σ(W s x v +b) (4)

x v ∈ R d x W s ∈ R d s ×d x σ 为 Softmax 函数. 此方

其中, 为节点的原始特征向量, 为可训练的参数矩阵, d s 为隐层维度,

法中的 MLP 可以看作一个非线性的神经网络分类器, 通过最小化其预测类别的损失来对其进行优化, 具体如公

式 (5) 所示:

1 ∑

mlp

Θ = argminL mlp = argmin J(ˆ s ,y v ) (5)

∗

m v

|V train |

Θ m Θ m

v∈V train

∗

其中, J(·) 为损失函数, Θ m 为 MLP 中的参数, Θ 为优化后的参数, V train 为训练集的节点, ˆ s v mlp 则为训练集中的节

m

v 经过 MLP

v

点 预测得到的类别概率分布向量, y v 为节点 的真实标签.

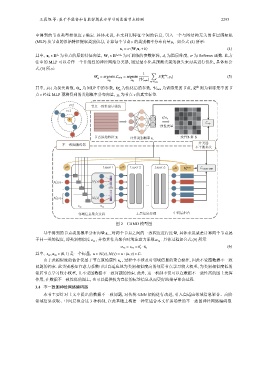

r=2 节点一致性度量模块

r=1

T

v s v ·s u

mlp

一致性度量

节点原始特征 X 一致性矩阵 S

计算类别概率 s v

分类器

不一致图编码器

不平衡损失

v (0) Layer 1 v (1) Layer 2 Layer L

v (L) h v (final) CAIM−GNN

1 (v) 1 (v)

...

2 (v) 2 (v)

s vu α vu

邻域信息聚合过程 L 层信息传播 中间层组合

图 2 CAMD 模型图

s v , 对两个节点之间的一致程度进行度量, 具体来说就是计算两个节点属

基于得到的节点类别概率分布向量

于同一类的程度, 即类别相似度 s vu , 并将其作为聚合时的注意力系数 α vu . 具体过程如公式 (6) 所示.

⊤

α vu = s vu = s ·s u (6)

v

其中, s vu ,α vu ∈ (0,1) 是一个标量, u ∈ N(v),N(v) = u : (u,v) ∈ E .

x v , 过程中不涉及对邻域信息的聚合操作, 因此不受图数据不一致

由于此相似度的估计仅基于节点原始属性

问题的约束. 此类别感知注意力系数可以自适应地为类别相似度高的邻居节点学习较大权重, 为类别相似度低的

邻居节点学习较小权重, 且不受图数据不一致问题的约束. 此外, 这一机制不仅可以在数据不一致性高的图上发挥

作用, 在数据不一致性低的图上, 也可以提供较为直接的标签信息从而更好地指导聚合过程.

3.4 不一致图神经网络编码器

本节主要针对上文中提出的数据不一致问题, 对传统 GNN 架构进行改进, 引入自适应邻域信息聚合、高阶

邻域信息获取、中间层组合这 3 种机制, 在此基础上构建一种更适合本文任务场景的不一致图神经网络编码器.