Page 392 - 《软件学报》2025年第5期

P. 392

2292 软件学报 2025 年第 36 卷第 5 期

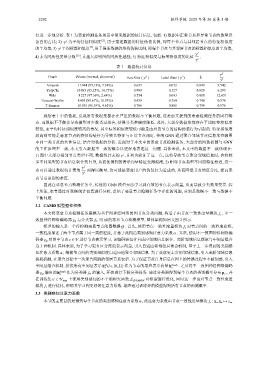

行进一步地分析. 表 1 为恶意检测任务场景中常见数据的统计信息, 包括: 1) 数据中正常节点和异常节点的数量及

f

各自的占比; 2) γ 为平均特征相似度 [2] , 用于描述数据的特征伪装比例, 即每个节点与其邻居节点的特征相似度

[2]

l

γ 平均标签相似度 , 用于描述数据的结构伪装比例, 即每个节点与其邻居节点的标签相似度的平均值;

的平均值; 3)

γ f

ˆ

ˆ

4) h 为同质性度量分数 [15] , h 越大说明图的同质性越强; 5) 特征相似度与标签相似度的比值 γ l .

表 1 数据统计信息

γ f

Graph #Users (normal, abnormal) f l ˆ h

Feat Simi ( γ ) Label Simi ( γ ) l

γ

Amazon 11 944 (93.13%, 7.38%) 0.687 0.072 0.049 9.542

YelpChi 10 893 (85.25%, 14.75%) 0.988 0.157 0.029 6.293

Wiki 8 227 (97.36%, 2.64%) 0.554 0.043 0.010 12.651

Tencent-Weibo 8 405 (89.67%, 10.33%) 0.439 0.760 0.748 0.578

T-finance 10 035 (95.39%, 4.61%) 0.786 0.805 0.799 0.976

观察表 1 中的数据, 发现所有数据集都存在严重的数据不平衡问题, 这是前文提到的恶意检测任务的固有特

点. 而数据不平衡会导致模型对少数类过拟合, 使得分类准确度降低. 此外, 大部分数据集都存在平均标签相似度

较低, 而平均特征相似度较高的情况. 其中标签相似度较低可能是由恶意节点的结构伪装行为引起的. 特征相似度

较高则可能是恶意节点的特征伪装行为导致其特征与正常节点相近. 传统 GNN 通过聚合邻域节点信息来挖掘图

中同一类节点的共性信息, 结合对数据的分析, 发现对于本文中的恶意节点检测任务, 大部分的图数据都与 GNN

的工作原理不一致, 本文引入数据不一致的概念以更好地表述这一问题. 具体来说, 本文中的数据不一致体现在:

l ˆ 列也验证了这一点, 这将导致节点聚合邻域信息时, 会将较

1) 图中大部分相邻节点类型不同, 数据统计表的 γ , h

多不同类型的节点信息聚合到自身, 从而使得到的表示向量特征变得混淆; 2) 相邻节点类型不同而特征相近, 这一

γ f

点可以通过数据统计表的 列得以衡量, 这可能是恶意用户的伪装行为造成的, 从而降低节点的区分度, 提高恶

γ l

意节点识别的难度.

因此在恶意节点检测任务中, 传统的 GNN 模型无法学习到有效的节点表示向量, 从而导致分类效果变差. 综

上所述, 本节通过对数据统计信息进行分析, 总结了恶意节点检测任务中存在的问题, 分别是数据不一致与数据不

平衡问题.

3.2 CAMD 模型整体框架

f s , 不一

本文将恶意节点检测任务建模为基于图神经网络的图节点分类问题, 构造了由节点一致性度量模块

致图神经网络编码器 g ϕ 与分类器 f Θ 组 成的恶意节点检测模型, 整体架构如后文图 2 所示.

模型的输入是一个待检测恶意节点的图数据 G . 首先, 使用节点一致性度量模块 f s 对节点间的一致程度建模,

α . 其次, 使用不一致图神经网络编

一致程度描述了两个节点属于同一类的程度, 并基于此构造类别感知注意力系数

码器 g ϕ 对图中节点 v ∈ V 进行节点表示学习, 该编码器包含自适应邻域信息聚合、高阶邻域信息获取与中间层组合

这 3 种机制. 具体来说, 为了学习更有区分度的表示向量, 引入自适应邻域信息聚合机制, 基于上一步得到的类别感

知注意力系数 α , 根据节点间的类别相似度自适应地聚合邻域信息. 为了获取更丰富的邻域信息, 引入高阶邻域信息

获取机制, 在聚合过程中一次聚合两跳的邻居节点表示. 为了保证节点自身信息在图上的传播过程中不被削弱, 引入

(l) (final) . 之后将不一致图神经网络编码

中间层组合机制, 拼接所有中间层表示 h (l ∈ [0,L]) 作为节点的最终表示向量 h

v v

器 g ϕ 输出的 h (final) 作为分类器 f Θ 的输入, 开始进行下游分类任务. 通过分类器得到每个节点的类别概率分布 p v , 并

v

′ L LDAM-RW 对模型进行优化, 同时这一步也对节点一致性度量

在训练集 v ∈ V train 上使用类别感知的不平衡损失函数

模块 f s 进行优化, 帮助其学习到更好的注意力系数. 最终通过训练好的模型得到所有节点的预测概率.

3.3 类别感知注意力系数

本节的主要目的是得到每个节点的类别感知注意力系数 α , 此注意力系数由节点一致性度量模块 f s : x v ,x u 7→ s vu