Page 261 - 《软件学报》2025年第5期

P. 261

杨红红 等: 基于平行多尺度时空图卷积网络的三维人体姿态估计算法 2161

表 4 单视角模型在 Human3.6M 测试集上基于 Protocol #1 和 Protocol #2 评价指标对比结果 (mm)(续)

Protocol 模型 Dir. Disc. Eat Greet Phone Photo Pose Purch. Sit SitD. Smoke Wait WalkD. Walk WalkT. Avg

[29]

P-STMO * (T=81) 41.7 44.5 41.0 42.9 46.0 51.3 42.8 41.3 54.9 61.8 45.1 42.8 43.8 30.8 30.7 44.1

Bai等人 [30] 44.4 49.7 48.2 49.2 56.9 66.3 47.7 46.4 65.6 71.2 52.7 49.6 53.6 39.4 43.3 52.1

#1 Li等人 [31] 47.9 50.0 47.1 51.3 51.2 59.5 48.7 46.9 56.0 61.9 51.1 48.9 54.3 40.0 42.9 50.5

Han等人 [32] 41.0 42.4 49.6 47.4 46.7 44.4 41.5 50.7 65.1 49.2 53.2 41.8 35.9 47.9 40.6 46.9

Ours (T=81) 41.2 45.5 42.1 44.6 47.3 57.2 43.2 43.5 57.3 63.1 46.3 44.1 45.6 31.2 32.1 45.6

Martinez等人 [25] 39.5 43.2 46.4 47.0 51.0 56.0 41.4 40.6 56.5 69.4 49.2 45.0 49.5 38.0 43.1 47.7

Zou等人 [16] 38.6 42.8 41.8 43.4 44.6 52.9 37.5 38.6 53.3 60.0 44.4 40.9 46.9 32.2 37.9 43.7

HPGCN [9] 37.5 41.1 38.2 42.2 40.9 46.9 39.0 37.9 48.6 53.1 42.1 38.3 44.3 37.7 32.9 41.6

Liu等人 [26] 35.9 40.0 38.0 41.5 42.5 51.4 37.8 36.0 48.6 56.6 41.8 38.3 42.7 31.7 36.2 41.2

[24]

GraphSH (T=64) 33.9 37.2 36.8 38.1 43.5 43.5 37.8 35.0 47.2 53.8 40.7 38.3 41.8 30.1 31.4 39.0

HGN [17] 35.8 39.7 36.3 40.6 40.2 45.9 36.8 35.8 47.3 53.7 40.7 36.4 43.1 29.8 32.8 39.6

Cai等人 [7] 35.7 37.8 36.9 40.7 39.6 45.2 37.4 34.5 46.9 50.1 40.5 36.1 41.0 29.6 33.2 39.0

#2

[12]

VideoPose 3D (T =243) 34.1 36.1 34.4 37.2 36.4 42.2 34.4 33.6 45.0 52.5 37.4 33.8 37.8 25.6 27.3 36.5

Chen等人 [18] 36.9 39.3 40.5 41.2 42.0 34.9 38.0 51.2 67.5 42.1 42.5 37.5 30.6 40.2 34.2 41.6

[6]

GAST-Net (T=81) 33.2 35.9 34.1 37.3 37.1 42.5 33.3 32.4 45.7 48.5 40.1 33.3 36.5 32.0 29.1 36.7

[29]

P-STMO * (T=81) 31.3 35.2 32.9 33.9 35.4 39.3 32.5 31.5 44.6 48.2 36.3 32.9 34.4 23.8 23.9 34.4

Bai等人 [30] 33.5 37.3 37.4 39.3 40.8 46.2 34.0 33.7 50.5 56.8 39.2 36.8 40.3 29.8 33.6 39.3

Han等人 [32] 50.2 54.4 50.1 52.0 53.6 46.7 50.1 61.5 65.1 52.2 57.1 49.2 41.2 54.5 46.6 52.8

Ours (T=81) 31.1 34.8 33.6 34.8 37.2 42.5 33.1 33.7 44.5 49.9 35.9 31.8 35.9 23.7 25.9 35.2

注: *代表基于纯Transformer模型的方法

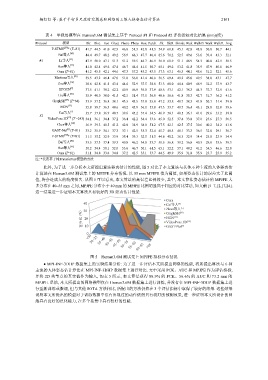

此外, 为了进一步分析本文所提出算法姿态估计的性能, 图 5 对比了本文算法与其他 6 种主流的人体姿态估

计算法在 Human3.6M 测试集上的 MPJPE 分布情况. 以 55 mm MPJPE 值为阈值, 如果姿态估计的误差大于此阈

值, 将会造成大的精度损失. 从图 5 可以看出, 本文算法的高误差比例较少, 其中, 本文算法姿态估计的 MPJPE 大

多分布在 40–55 mm 之间, MPJPE 分布小于 40 mm 的 MPJPE 比例明显高于相应的对比算法, 如文献 [5−7,12,17,24].

这一结果进一步证明本文算法具有较好的 3D 姿态估计性能.

Ours

40 Cai等人 [7]

[5]

Zhao等人 [24]

30

百分比 (%) 20 HGN [17] [6] [12]

GraphSH

VideoPose 3D

10

GAST-Net

0

<30 30−35 35−40 40−45 45−50 50−55 55−60 60−65 >65

图 5 Human3.6M 测试集上 MPJPE 指标分布情况

● MPI-INF-3DHP 数据集上的实验结果分析: 为了进一步评估本文所提出网络的性能, 将所提出算法与 6 种

主流的人体姿态估计算法在 MPI-INF-3DHP 数据集上进行对比. 文中采用 PCK、AUC 和 MPJPE 作为评估指标,

并将 2D 关节点的真实值作为输入, 如表 5 所示, 本文算法获得 88.9% 的 PCK、56.6% 的 AUC 和 73.2 mm 的

MPJPE. 虽然, 本文所提出的网络模型仅在 Human3.6M 数据集上进行训练, 并没有在 MPI-INF-3DHP 数据集上进

行重新训练或微调, 但与其他 SOTA 方法相比, 所提出的方法仍然在 3 个评估指标中取得了较好的结果. 这些结果

说明本文所提出的模型对于训练数据中没有出现过的动作依然具有较好的预测效果, 进一步证明本文所设计的网

络具有良好的泛化能力, 在多个场景中具有较好的性能.