Page 260 - 《软件学报》2025年第5期

P. 260

2160 软件学报 2025 年第 36 卷第 5 期

分别对 3D 人体姿态估计中的关节点进行图卷积操作, 本文所设计的网络获得更小的 MPJPE 值 (45.6 mm vs.

[5]

48.8 mm , 45.6 mm vs. 60.8 mm ). 尽管文献 [5,7] 中的模型根据人体骨架的结构信息设计了特殊的约束条件以满

[7]

足 3D 人体姿态估计, 但其性能仍低于本文算法. 此外, 将本文算法与其他具有特殊涉及结构的基于 GCN 的 3D 人

体姿态估计算法进行比较, 如文献 [33] 中提出的 UGCN、文献 [17] 中构造的 HGN、文献 [9] 中设计的 HPGCN

和文献 [24] 中设计的 GraphSH 网络, 本文算法展示出较好的性能. 进一步验证了本文网络设计的合理性. 在本文

所提出的 PMST-GNet 网络中, 其不仅通过设计 DDA-STGConv 卷积层, 从时间和空间维度出发对骨架关节点信

息进行基于自约束和注意力机制约束的建模, 增强节点间的信息交互, 有效地对骨架关节的时空信息进行建模. 而

且, 以 DDA-STGConv 为基本单元, 通过设计图拓扑聚合函数, 构造不同尺度的图拓扑结构以建立平行多尺度子网

络模块, 实现不同尺度节点特征的聚合, 有效提取骨架关节点局部和全局的特征信息. 此外, 构造 MFEB 模块, 实

现平行子图网络之间多尺度信息的交互, 进一步提高网络特征表达的能力. 因此, 如表 4 所示, 本文所设计的网络

表现出较好的 3D 姿态估计性能. 但是, 本文方法的 MPJPE 和 P-MPJPE 均大于文献 [28] 中的值, 这是因为本文方

法是一种基于单视角单假设的 3D 姿态估计, 文献 [28] 通过构建多假设生成模型, 提取关键特征的依赖关系, 消除

深度模糊和遮挡对姿态估计的影响. 这一现象激励本文在未来的工作中进一步在时空特征提取中引入多假设模

型, 提高模型姿态估计的性能. 此外, 文献 [29] 是一种基于纯 Transformer 进行关节时空特征提取的网络模型, 其

相比本文模型来说, 能更好利用 Transformer 机制捕捉关节时空域的全局上下文信息, 故而文献 [29] 的实验结果

优于本文方法, 但是会带来模型复杂度的增加.

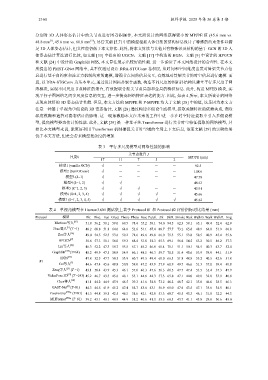

表 3 平行多尺度模型对网络性能的影响

关节点数目 J

尺度k MPJPE (mm)

17 11 7 5 2

模型1 (vanilla GCN) √ - - - - 92.5

模型2 (SemGConv) √ - - - - 108.6

模型3 (k=1) √ - - - - 47.78

模型4 (k=1, 2) √ √ - - - 46.63

模型5 (k=1, 2, 3) √ √ √ - - 45.91

模型6 (k=1, 2, 3, 4) √ √ √ √ - 45.66

模型7 (k=1, 2, 3, 4, 5) √ √ √ √ √ 45.62

表 4 单视角模型在 Human3.6M 测试集上基于 Protocol #1 和 Protocol #2 评价指标对比结果 (mm)

Protocol 模型 Dir. Disc. Eat Greet Phone Photo Pose Purch. Sit SitD. Smoke Wait WalkD. Walk WalkT. Avg

Martinez等人 [25] 51.8 56.2 58.1 59.0 69.5 78.4 55.2 58.1 74.0 94.5 62.3 59.1 65.1 49.4 52.4 62.9

[5]

Zhao等人 (T =1) 48.2 60.8 51.8 64.0 64.6 53.6 51.1 67.4 88.7 57.7 73.2 65.6 48.9 64.8 51.9 60.8

Zou等人 [16] 49.0 54.5 52.3 53.6 59.2 71.6 49.6 49.8 66.0 75.5 55.1 53.8 58.5 40.9 45.4 55.6

[9]

HPGCN 50.6 57.3 50.1 56.0 59.3 68.4 53.8 54.3 65.3 69.1 56.6 54.5 63.2 50.5 46.2 57.3

Liu等人 [26] 46.3 52.2 47.3 50.7 55.5 67.1 49.2 46.0 60.4 71.1 51.1 50.1 54.5 40.3 43.7 52.4

[24]

GraphSH (T=64) 45.2 49.9 47.5 50.9 54.9 66.1 48.5 46.3 59.7 71.5 51.4 48.6 53.9 39.9 44.1 51.9

[17]

HGN 47.8 52.5 47.7 50.5 53.9 60.7 49.5 49.4 60.0 66.3 51.8 48.8 55.2 40.5 42.6 51.8

#1

Cai等人 [7] 44.6 47.4 45.6 48.8 50.8 59.0 47.2 43.9 57.9 61.9 49.7 46.6 51.3 37.1 39.4 48.8

[27]

Zeng等人 (T =1) 43.1 50.4 43.9 45.3 46.1 57.0 46.3 47.6 56.3 61.5 47.7 47.4 53.5 35.4 37.3 47.9

[12]

VideoPose 3D (T =243) 45.2 46.7 43.3 45.6 48.1 55.1 44.6 44.3 57.3 65.8 47.1 44.0 49.0 32.8 33.9 46.8

Chen等人 [18] 41.1 44.2 44.9 45.9 46.5 39.3 41.6 54.8 73.2 46.2 48.7 42.1 35.8 46.6 38.5 46.3

[6]

GAST-Net (T=81) 44.3 44.8 41.9 45.2 47.4 54.7 43.6 43.1 56.9 61.0 47.6 43.5 47.1 35.6 34.5 46.1

[23]

PoseFormer * (T=81) 41.5 44.8 39.8 42.5 46.5 51.6 42.1 42.0 53.3 60.7 45.5 43.3 46.1 31.8 32.2 44.3

[28]

MHFormer * (T=81) 39.2 43.1 40.1 40.9 44.9 51.2 40.6 41.3 53.5 60.3 43.7 41.1 43.8 29.8 30.6 43.0