Page 464 - 《软件学报》2025年第4期

P. 464

1870 软件学报 2025 年第 36 卷第 4 期

练阶段中使用的训练样本有两种主要来源.

1) 公开数据集, 如谷歌公司的 Waymo 开放数据集, 其拥有在超过 25 个城市的公共道路上行驶超过 2 000 万

英里的真实数据, 以及超过百亿英里的模拟行驶数据.

2) 商业数据集, 如各厂商在车辆测试过程中采集的数据, 这种数据采集方法的优点是可以自定义数据特征, 情

景与采样方式, 例如特斯拉提出的影子驾驶模式.

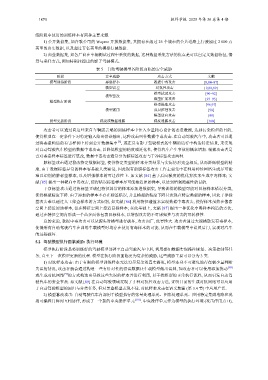

表 5 自动驾驶模型各阶段面临的安全威胁

阶段 安全威胁 攻击方式 文献

模型训练阶段 恶意样本 数据中毒攻击 [8,84–87]

模型误差 对抗性攻击 [9,88,89]

模型扰动攻击 [90–92]

模型篡改

模型扩展攻击 [93–95]

模型执行阶段

模型提取攻击 [96,97]

模型滥用 成员推理攻击 [98]

模型逆向攻击 [99]

模型更新阶段 梯度或数据泄露 梯度泄露攻击 [100]

攻击者可以通过向这些来自车辆或云端的训练样本中注入少量精心设计的恶意数据, 达到污染模型的目的,

使得模型在一定条件下对特定输入给出错误输出, 这种攻击叫作数据中毒攻击. 在自动驾驶汽车中, 攻击者可以通

过将恶意构造的有害样例上传到公开数据集中 [8] , 或在具有影子驾驶模式的车辆的运行中构造特定情景, 来实现

对自动驾驶汽车模型的数据中毒攻击, 以降低模型的精度或泛化性, 使得汽车产生事故的概率增加. 根据攻击者是

否对恶意样本标签进行篡改, 数据中毒攻击通常分为脏标签攻击与干净标签攻击两种.

脏标签攻击通过篡改特定数据标签, 使得特定类型的样本分类结果与实际情形完全相反, 从而降低模型的精

度. 由于数据标签异常的样本容易被人类察觉, 因此现有的脏标签攻击工作主要集中在利用神经网络生成尽可能

难以识别的脏标签样本, 以及增强样本的可迁移性上. 如文献 [84] 基于后向梯度的优化算法来生成中毒样本; 文

献 [85] 提出一种靶向中毒攻击, 使得错误标签样本尽可能接近原始样本, 以达到增强隐蔽性的目的.

干净标签攻击通过将标签正确但特征异常的样本添加进数据集, 导致训练的模型可能对目标样本错误分类,

使得模型精度下降. 由于添加的样本不存在标签错误, 并且模型的精度下降只表现在特定类型的样本, 因此干净标

签攻击难以通过人工筛查样本的方式识别, 如文献 [86] 利用特征碰撞来实现数据中毒攻击, 使得样本虽然在像素

空间上接近原始样本, 但在特征空间上接近目标样本; 在此基础上, 文献 [87] 提出一种优化中毒样本构造的方法,

通过在特征空间内形成一个凸多面体包裹目标样本, 以增强攻击的不可感知性与攻击的可转移性.

总的来说, 数据中毒攻击可以从源头对模型进行破坏, 攻击面广, 危害性大. 攻击者通过大规模散发有毒样本,

使得所有自动驾驶汽车在训练车载模型时均存在使用有毒样本的可能, 从而在车载模型中设置后门, 实现对汽车

的远程破坏.

5.2 驾驶模型执行面临威胁: 执行环境

模型执行阶段是将训练好的驾驶模型部署至自动驾驶汽车中后, 利用感知数据实现路径规划、决策控制等任

务, 直至下一次模型更新的过程. 模型在执行阶段面临更为复杂的威胁, 这些威胁主要可以分为 3 类.

1) 对抗样本攻击: 由于有限的模型训练样本无法穷尽复杂的真实路况, 模型本身不可避免地存在极少量判断

失误的情况, 攻击者就会通过构造一些有针对性的错误数据让车载模型做出误判, 如攻击者可以使用添加扰动 [88]

或生成对抗网络 [9] 的方式构造出导致这些失误的样本并进行利用, 以干扰模型的正常执行流程, 从而引发自动驾

驶汽车的安全事故. 如文献 [89] 在自动驾驶领域复现了 5 种对抗性攻击方法, 证明目前的生成对抗网络可以应用

于自动驾驶模型的回归与分类任务, 但对黑盒模型表现不佳. 对抗样本攻击在语义欺骗 (第 3.4 节) 中应用广泛.

2) 模型篡改攻击: 自动驾驶汽车内部用于模型执行的张量处理单元、图形处理单元、应用特定集成电路和现

场可编程门阵列互相协作, 形成了一个新的中央操作单元 [101] . 中央操作单元作为模型的执行环境 (攻击作用点 H),