Page 424 - 《软件学报》2025年第4期

P. 424

1830 软件学报 2025 年第 36 卷第 4 期

在输入嵌入部分, 时间序列先通过 RevIN 归一化为零均值和单位标准差 [46] , 然后分成不同的 patch 进行

embedding [47] . 接下来, 在 patch 重编程部分, 为了将时序输入特征对齐到自然语言文本域上, TIME-LLM 使用交叉

注意对两种模态进行转换, 此外 TIME-LLM 采用了一个简单的线性层来提取文本原型, 从而降低计算复杂度. 在

提示为前缀部分, TIME-LLM 将定制的前缀提示的自然语言嵌入向量与经过模态转换对齐后的时序嵌入拼接后输

入到预训练好的 LLM 中, 最后得到的输出经过线性投影层后进行预测. 然而, 由于 TIME-LLM 在重编程部分并未

结合具体的领域知识, 因此仍有提升的空间.

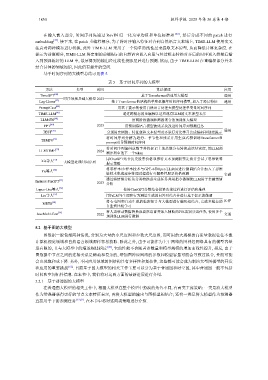

基于时间序列的大模型总结可见表 5.

表 5 基于时间序列的大模型

方法 类型 时间 算法描述 应用

[42]

TimeGPT 基于Transformer的通用大模型 通用

时序领域基础大模型 2023

Lag-Llama [43] 基于Transformer的结构的单变量概率时间序列模型, 加入了滞后特征 通用

[44]

PromptCast 用基于提示的使用自然语言处理大模型处理单变量时间序列

TIME-LLM [45] 通过跨模态的重编程以适应现有LLM的文本原型表示

会出现饱和或下降. 另外, 不同应用领域的图结构具有多样性和复杂性, 这些都可能会成为制约大型图模型的开发

LLM4TS [48] 用两阶段微调和两级聚合的预训练大模型

FPT [49] 2023 用预训练语言模型的残差块改进时间序列预测任务

TEST [50] 分别用实例级、特征级和文本原型对齐进行对比学习完成编码和创建提示 通用

将时间序列分解为趋势、季节性和残差并用生成式预训练Transformer和

[51]

TEMPO

prompt引导预测时间序列

将时间序列编码成数字并将标记上的离散分布转换成连续密度, 用LLM预

LLMTIME [52] 2024

测序列中的下一个token

用ChatGPT结合历史股票价格和推特文本预测股票走势并尝试了思维链等

Xie等人 [53] 大模型处理时间序列 提示策略

将零样本/少样本技术与GPT-4和Open LLaMA进行微调结合并加入了思维

[54]

Yu等人

链技术集成逐步推理过程进行可解释性股票价格预测 金融

通过将情绪分析从分类转换成生成任务并用指令微调使LLM用于金融情绪

[55]

Instruct-FinGPT

2023 分析

Lopez-Lira等人 [56] 使用ChatGPT分数结合投资决策过程进行评估和推理

Liu等人 [57] 用PaLM与生理和行为测量生成的问答对结合并进行基于提示的微调

将心电图和自动生成的临床报告与大模型进行编码相结合, 完成多模态的 医疗

[58]

METS

自监督比较学习

将人类移动数据转换成自然语言并加入辅助的POI类别分类任务, 使用多个

AuxMobLCast [59] 2022 交通

预训练LLM进行微调

5.2 基于图的大模型

图数据一般包括两种情况, 分别为大量的小尺度图和少数大尺度图, 而可用的大规模的高质量数据往往不像

计算机视觉领域和自然语言领域那样容易获取. 除此之外, 由于可能作为主干网络的图神经网络具有的模型容量

是有限的, 且与大模型中的缩放规律相反 [60] , 它的性能不会随着参数量和模型规模的增加而线性提升, 相反, 由于

图数据中节点之间的连接关系是稀疏和复杂的, 增加图神经网络的参数和模型容量可能会导致过拟合, 性能可能

和应用的重要挑战 [61] . 目前基于图大模型的相关工作主要可以分为基于普通图和时空图, 其中普通图一般不包括

时间和空间拓扑信息. 在本节中, 我们将对这两方面的最新进展进行介绍.

5.2.1 基于普通图的大模型

在普通图大模型的相关工作中, 根据大模型在整个模型中扮演的角色不同, 有两类主流策略: 一类是将大模型

作为增强器获得更好的节点文本特征表示, 再将大模型的输出与图模型相结合; 还有一类是将大模型作为预测器

直接用于下游预测任务 [61,62] . 在本节中将对这两类策略进行介绍.