Page 423 - 《软件学报》2025年第4期

P. 423

邹慧琪 等: 基于图神经网络的复杂时空数据挖掘方法综述 1829

架构 [26] 中采用的多头自注意力机制能够较好地处理不同频率和特征的时间序列, 同时 Transformer 对长距离依赖

具有优秀的提取能力, 能够对不同长度的时间序列信息进行有效挖掘, 因此, 对于不同应用场景的复杂时间序列,

TimeGPT 采用了与 Transformer 类似的基础模型结构. 在训练集的选择上, 为了获得不同特征和频率的时间序列,

TimeGPT 采用了包含超过 1 000 亿个数据的最大的公开时间序列数据集, 其中还包括了噪声值和异常值, 以应对

真实复杂的通用应用场景. 在推断目标时间序列时, TimeGPT 采用滚动预测来估计误差. 在这项工作的最后,

Garza 等人 [42] 提出, 未来的时序大模型预测可以考虑将基础知识融入到预测过程中. 此外, 在进行时间序列分类时,

需要对时间序列之间的相似性进行标准设定, 这也是未来值得进一步研究的方向, 可能在提高预测准确性和可解

释性方面具有显著的效果.

除了 TimeGPT, Rasul 等人 [43] 提出了一个通用单变量概率时序预测模型 Lag-Llama, 与 TimeGPT 使用共形预

测不同的是, Lag-Llama 直接使用概率预测. Lag-Llama 同样使用一个基于 Transformer 的结构, 为了向量化特定频

率的单变量时间序列, 该模型使用了滞后特征. 在训练时, 输入的单变量序列及其协变量首先通过一个共享的线性

投影层, 从而将时间序列的不同特征进行维度映射对齐, 接下来, 通过 M 个掩码解码块进行投影, 然后将输出和位

置编码一起输入到分布头中预测概率分布的参数, 最后利用对数概率计算损失.

### Domain: <domain knowledge>

5.1.2 现有大模型处理时间序列

除了时间序列的基础大模型, 还有一些使用现有大模型处理通用时间序列的研究工作. 其中一项最新工作是

Xue 等人 [44] 提出的 PromptCast, 这是一种基于提示的首次使用自然语言处理大模型, 而没有修改现有的大语言模

型结构来进行时间序列预测的方法. 该方法使用了一个涵盖多应用场景的大规模时间序列数据集 PISA, 基于不同

模板构造的提示将连续时间步上的数值转换为自然语言句子进行描述, 并将转换得到的文本输入到大语言模型

中, 以类似自然语言处理任务中句子到句子的方式进行预测. 由于这项工作主要聚焦于单变量时间序列预测任务,

未来可以通过在时间序列相关的数据集中补充多变量时间序列, 以适应更多的应用场景.

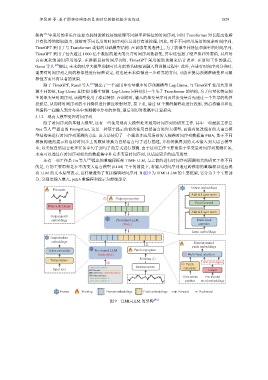

还有一项工作是 Jin 等人 [45] 提出的重编程框架 TIME-LLM, 与之前的进行时间序列预测相关的研究工作不同

的是, 它的主要思想是在不改变大语言模型 (LLM) 主干的前提下, 将输入时间序列通过跨模态的重编程以适应现

有 LLM 的文本原型表示, 这样做避免了直接编辑时间序列. 如图 9 为 TIME-LLM 的主要框架, 它分为 3 个主要部

分, 分别是输入嵌入, patch 重编程和提示为前缀部分.

Output embeddings

Forecasts

Add & Layer norm

⑤ Output projection

Feed forward

Flatten & Linear

Add & Layer norm

Output patch

embeddings Pre-trained LLM Multi-head

(Body) attention

Input embeddings

Output token

embeddings Reprogrammed

patch embeddings

Token embedder Pre-trained LLM Patch reprogram

(Embedder) ③ Multi-head attention

Patching ①

Tokenization

④ ② Patch Text prototypes

Instance norm

<dataset description> embedder

Input text Linear

### Instruction: <task information>

### Input statistics: Time series Pre-trained

<time series statistic 1>

<time series statistic 2> … patches word embeddings

Frozen Training Prompt embeddings Patch embeddings Forward Backward

图 9 TIME-LLM 的架构 [45]