Page 232 - 《软件学报》2025年第4期

P. 232

1638 软件学报 2025 年第 36 卷第 4 期

机器学习的重要特点之一是所训练的模型会“记住”训练集信息. 由于机器学习借助历史数据预测未来行为或

倾向, 其模型难免包含训练集中用户个人信息, 存在信息泄露的风险 [1] . 以基于协同过滤的推荐系统为例 [2] , 假设

某推荐系统根据用户群体的书籍阅读历史来建模计算用户之间的相似度, 从而为各用户推荐相似用户阅读的书

籍. 在这种情况下, 若某用户 A 试图删除自己与艾滋病主题相关的阅读记录, 而对应的用户相似度模型没有做出

相应改变, 则攻击者仍可根据与用户 A 相似的用户所拥有的阅读记录 (这些用户很可能阅读了艾滋病主题的书

籍), 推断出用户 A 也曾阅读过艾滋病主题的书籍. 因此, 在机器学习场景下, 仅从数据集中删除用户数据, 并不足

以保护用户隐私, 用户数据很可能被内化到了机器学习模型中, 在本例中即为用户相似度模型. 此外, 对自然语言

模型进行增量训练时, 可通过训练前后模型的差异推断出模型新使用的训练数据 [3] ; 通过成员推理攻击, 攻击者能

判断某条数据是否在模型训练集中 [4] , 等等. 以上现象均说明, 模型会记忆训练集信息, 且不会随着时间流逝而自

行“遗忘”, 易引起隐私泄露.

机器学习隐私问题越发突出, 人们对个人信息的保护也越发重视. 欧盟委员会在 2012 年首次提出被遗忘权

(the right to be forgotten), 指出个人出于合法目的可要求数据收集者删除其数据, 强调赋予用户处理个人隐私数据

的合法权利 [5] . 许多国家开始重视大数据下的隐私问题, 我国于 2018 年生效的《信息安全技术个人信息安全规范》

√

指出, 用户应有权删除个人数据 [6] . 同年, 欧盟公布的《通用数据保护条例》(General Data Protection Regulation,

GDPR) 正式生效, 该条例指出, 自动化算法 (包括机器学习系统) 需保证用户拥有被遗忘权 [7] .

为了支持被遗忘权, 模型拥有者需确定模型具有遗忘的能力 [8] . 但如前文所述, 由于模型仍可能泄露用户信息,

单从训练集里删除用户个人数据并不够. 即使用户个人数据被删除, 这些数据对模型的影响仍然存在, 产生隐私泄

露的隐患.

由此产生了机器遗忘 (machine unlearning) 的概念. 当遗忘某些数据的请求到来时, 机器遗忘不仅要求删除训

练集中的这些数据, 还要求删除它们对模型的影响 [9] , 让模型表现得与从未使用这些数据进行训练的结果相近.

让模型遗忘某些数据, 最简单的方法是在不包含这些数据的训练集上重新训练模型. 然而, 很多情况下, 重新

训练模型代价巨大, 如在 15G 训练集上训练一个参数量为 110M 的谷歌 BERT 模型, 花费在 2 000–5 万美元之间 [10] ,

且耗时较长. 机器遗忘的核心问题是: 在训练集中移除某些数据后, 如何以代价低于重新训练的方式, 得到与重新

训练结果尽可能接近的模型 [11] , 其本质是获取近似模型. 若有代价更小的方法达到模型遗忘的效果, 用户希望模

型遗忘个人数据的需求就更容易被满足, 其隐私也就能得到更好的保护.

最后, 除了隐私保护外, 机器遗忘还有其他应用, 如: 在机器学习模型遇到后门攻击 (backdoor attack) 或存在被

污染样本时, 使用机器遗忘来除去恶意样本, 提高模型维护效率 [12−14] ; 在训练集存在冗余时, 用户对模型语料进行

压缩, 可通过机器遗忘来高效地获得压缩训练集后的模型.

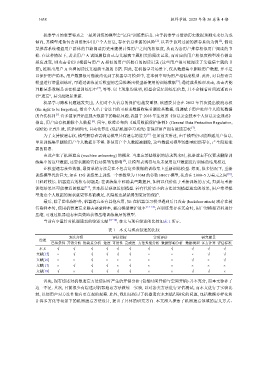

当前有少量针对机器遗忘的综述文献 [15−18] , 本文与现有综述的比较如表 1 所示.

表 1 本文与现有综述的比较

方法介绍 评估指标 实验评估 研究前景

综述

已知条件 开销分析 优缺点分析 速度 可用性 完成度 方法性能分析 数据影响分析 数据类型 多方计算 评估标准

本文 √ √ √ √ √ √ √ √ √ √

文献[15] × √ √ √ √ √ × × × √ √

文献[16] × × √ × × × × × √ × √

文献[17] × √ √ √ × √ × × × × ×

文献[18] √ × √ √ √ √ × × √ √ ×

首先, 现有综述对机器遗忘方法使用时产生的开销分析 (包括时间开销与空间开销) 并不充分, 而本文弥补了

这一不足. 其次, 目前很少有综述对机器遗忘方法做统一实验, 以对各类方法进行评估测试, 而本文进行了实验比

较, 以便用户对方法性能有更直观的观察. 此外, 我们还探讨了机器遗忘未来值得研究的问题, 包括数据多样化和

计算多方化等场景下的机器遗忘方法设计, 提出了具体的研究方向. 本文深入探索了机器遗忘领域的定义方式、