Page 223 - 《软件学报》2025年第4期

P. 223

郁俊杰 等: 面向低资源关系抽取的自训练方法 1629

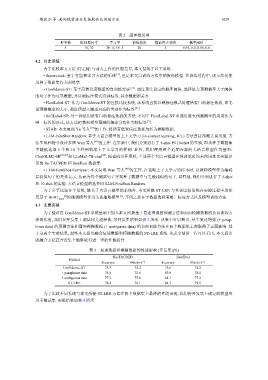

表 2 超参数设置

种子数 批处理尺寸 学习率 训练轮次 提前停止轮次 概率阈值

5 16, 32 3E–5, 5E–5 20 5 0.95, 0.9, 0.85, 0.8

4.2 对比系统

为了比较本文方法 ST-LRE 与前人工作的性能差异, 本文复现了以下系统.

• Supervised: 基于有监督学习方法的系统 [3] , 也是本文自训练方法中的教师模型. 在训练过程中, 该方法仅使

用种子数据集作为训练集.

• Confidence-ST: 基于高置信度数据的自训练方法 [11] . 通过预先设定的概率阈值, 选择最大预测概率大于阈值

的句子作为可靠数据, 并以硬标注模式得到标签, 其余数据则丢弃.

• HardLabel-ST: 作为 Confidence-ST 的直接比较系统, 该系统直接以硬标注模式处理所有自动标注数据, 即无

论预测概率的大小, 都选用最大概率对应的类别作为标签 [21] .

• SoftLabel-ST: 另一种使用所有自动标注数据的方法. 不同于 HardLabel-ST 中选用最大预测概率的类别作为

Re-TACRED

唯一标签的形式, 该方法把教师模型预测的概率分布作为软标签 [9] .

• STAD: 本文复现 Yu 等人 [47] 的工作, 将所有低置信度数据均转为模糊数据.

• LLM-FewShot-Random: 基于大语言模型的上下文学习 (in-context learning, ICL) 方法直接预测关系类别. 方

法实现和指令设计参照 Wan 等人 [48] 的工作. 在实验中, 我们分别进行了 5-shot 和 10-shot 的实验, 即从种子数据集

中随机选取 5 个和 10 个样例构成上下文学习的样例. 此外, 我们使用两个近期开源的大语言模型作为基石:

ChatGLM2-6B [42,43] 和 LLaMa2-7B-chat [49] . 经查阅公开资料, 上述两个大语言模型在预训练时均未使用本文实验涉

及的 Re-TACRED 和 SemEval 数据集.

• LLM-FewShot-Retriever: 本文复现 Wan 等人 [48] 的工作, 在选取上下文学习的样本时, 以教师模型作为编码

层提供句子的关系表示, 从而为每个测试句子寻找种子数据中与之最相似的句子. 同样地, 我们分别进行了 5-shot

和 10-shot 的实验. 大语言模型的选择同 LLM-FewShot-Random.

为了公平比较各个系统, 除基于大语言模型的系统外, 本文所提 ST-LRE 与其余比较系统在实验过程中均使

用基于 BERT base 的微调模型作为关系抽取模型 [3] , 不同之处在于数据选择策略、标注方式以及模型训练方法.

[2]

4.3 主要实验

为了验证在 Confidence-ST 系统基础上加入本文所提基于复述增强的预测方法和面向模糊数据的负向训练方

法的作用, 我们在开发集上调试相关超参数, 其开发集结果如表 3 所示. 从表中可以看出, 基于复述增强 (+ parap-

hrase data) 的预测方法和面向模糊数据 (+ ambiguous data) 的负向训练方法在两个数据集上都取得了正面影响. 基

于这两个实验结果, 最终本文提出融合复述数据和模糊数据的 ST-LRE 系统. 从表中最后一行可以看出, 本文提出

的融合方法在开发集上能够取得进一步的性能提升.

表 3 复述数据和模糊数据的性能影响 (开发集)(%)

SemEval

Method

Accuracy Macro-F1 Accuracy Macro-F1

Confidence-ST 75.3 74.2 78.6 74.2

+ paraphrase data 76.4 75.6 83.9 78.1

+ ambiguous data 77.2 75.8 84.1 77.2

ST-LRE 78.4 76.1 84.7 79.5

为了比较不同系统与本文所提 ST-LRE 方法在两个数据集上最终的性能表现, 我们将开发集上确定的模型应

用于测试集. 实验结果如表 4 所示.