Page 456 - 《软件学报》2024年第6期

P. 456

3032 软件学报 2024 年第 35 卷第 6 期

5 讨 论

为了更好地说明本文提出的自动化数据增强算法 SGES AA 能够在搜索耗时和模型准确率方面实现更好的

平衡, 本节对不同算法的时间复杂度以及模型准确率进行了综合对比分析. 由于不同自动化数据增强算法的设计

原则以及技术细节存在较大差异, 难以准确计算每个算法的时间复杂度. 在自动化数据增强算法的搜索阶段, 搜索

策略自身的计算开销往往占比不大, 模型的训练评估开销通常占据了大部分的计算开销. 为此, 本节以模型参数训

练次数估计各个算法的时间复杂度. 表 20 对比分析了不同自动化数据增强算法在搜索阶段时间复杂度以及模型

准确率, N epoch 和 C epoch 分别代表模型训练的 epoch 数量及每个 epoch 的时间开销.

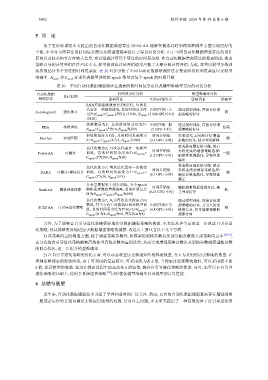

表 20 不同自动化数据增强算法在搜索阶段时间复杂度以及模型准确率方面的对比分析

自动化数据 设计原则 时间复杂度分析 模型准确率分析

增强算法 影响因素 时间开销大小 影响因素 准确率

RNN控制器收敛需要T次迭代, 每次迭

代需要一次模型训练, 总的时间复杂度 时间开销巨大 通过模型训练, 直接评估增

AutoAugment 强化学习 高

为T×N epoch ×C epoch (T约为15 000, N epoch (5 000 GPU小时) 强策略的好坏

增强策略搜索的起始阶段, 由于可利用的信息较少, 可采用较大的

为120)

种群数量为P, 总的时间复杂度为P× 时间开销一般 通过模型训练, 直接评估增

PBA 种群训练 较高

N epoch ×C epoch (P为16, N epoch 为200) (5 GPU 小时) 强策略的好坏

训练集划分为K份, 总的时间复杂度为 时间开销低 在验证集上间接评估增强

Fast AA 密度匹配 一般

K×N epoch ×C epoch (K为5, N epoch 为200) (3.5 GPU 小时) 策略的好坏, 缺少理论解释

将离散问题近似可微, 然后

迭代次数为T, 每次迭代需要一次模型

Faster AA 可微分 训练, 总的时间复杂度为T×N epoch × 时间开销低 再将连续的增强策略选择/ 一般

C epoch (T为200, N epoch 为20) (1.5 GPU 小时) 幅度参数离散化, 导致性能

偏差

将离散问题近似可微, 然后

迭代次数为T, 每次迭代需要一次模型

时间开销低 再将连续的增强策略选择/

DADA 可微分+梯度估计 训练, 总的时间复杂度为T×N epoch × (0.1 GPU 小时) 幅度参数离散化, 导致性能 一般

C epoch (T为20, N epoch 为15)

偏差

在全量数据集上进行训练, 每个epoch 时间开销低

Rand AA 随机网格搜索 随机选择数据增强策略, 总的时间复杂 (0.23 GPU 小时) 随机搜索数据增强方法, 缺 低

度为N epoch ×C epoch (N epoch 为200) 乏理论指导

迭代次数为T, N s 为每次迭代搜索方向 通过模型训练, 直接评估增

数量, 每个方向上对偶执行两次模型训 时间开销中等 强策略的好坏, 并引入历史

SGES AA 自引导进化策略 高

练, 总的时间复杂度为T×N S ×2×N epoch × (4.8 GPU 小时) 梯度信息, 指导增强策略的

C epoch (N 为8, N epoch 为60, 并发度m为8) 搜索方向

另外, 为了能够让自引导进化策略更好地指导数据增强策略的搜索, 本文也从多个层面进一步改进自引导进

化策略, 使其能够更好地适应于数据增强策略的搜索. 改进点主要包含以下几个方面.

1) 在策略向量的构造方面, 除了增强策略参数外, 将模型的架构参数以及部分超参数嵌入到策略向量中 [36,37] ,

充分发挥自引导进化策略能够高效处理高维参数向量的优势, 从而实现增强策略参数以及架构参数或模型超参数

的联合优化, 进一步提升模型准确率.

2) 在自引导进化策略的优化方面, 可以动态设置历史梯度矩阵的梯度数量, 令 k 为采用的历史梯度的数量. 在

k 值. 当搜索过程逐渐收敛时, 可以采用较小的

k 值, 保证模型的收敛. 通过在搜索过程中动态改变 k 的取值, 提升自引导进化策略的性能. 另外, 也可以在自引导

进化策略的基础上, 使用多目标遗传策略 [38] 同时优化模型准确率以及模型的计算性能.

6 总结与展望

近年来, 自动化数据增强技术引起了学界和业界的广泛关注. 然而, 已有的自动化数据增强算法存在增强效果

一般或者运行时长难以满足实际应用场景的问题. 针对以上问题, 本文研究提出了一种高效的基于自引导进化策