Page 438 - 《软件学报》2024年第6期

P. 438

3014 软件学报 2024 年第 35 卷第 6 期

matches the current optimal automated data augmentation methods without significantly increasing the time consumption of searches.

Key words: deep learning; data augmentation; automated machine learning; self-guided evolution strategy

近年来, 深度学习技术已广泛应用于图像处理、语音识别以及文本分析等领域, 并且取得了巨大的成功. 然

而, 在实际应用场景中, 由于数据获取成本高、缺少大规模带标签数据, 导致深度学习模型的训练容易产生过拟合

等问题. 数据增强 (data augmentation, DA) 技术 [1] (如图像处理领域中的图像翻转、裁剪、色彩调整等) 是提升训

练数据规模和多样性的有效途径, 其能够从原始数据中加工出具有更强表示能力的数据, 从而提升深度学习模型

的泛化能力. 与超参数优化类似, 对于给定的数据集及应用场景, 设计良好的数据增强策略往往需要大量的专家经

验和领域知识. 除了选择合适的数据增强操作外, 还需要考虑增强操作的组合以及每一种增强操作的幅度 (如图像

旋转角度). 因此, 数据增强策略设计是一种复杂的组合优化问题, 需要反复尝试, 费时费力.

为了降低机器学习门槛, 提升 AI 建模效率, 近年来, 自动化机器学习 (automated machine learning, AutoML) 技

术 [2] 应运而生. AutoML 的本质是以 AI 设计 AI, 将机器学习模型选择以及架构设计等问题抽象为搜索问题, 通过

设计良好的搜索空间和搜索方法, 实现机器学习模型的自动化设计. 基于 AutoML 技术的核心思想, Google 的研

究者首次提出了基于强化学习的自动化数据增强 (automated data augmentation, AutoAugment) 技术 [3] , 即从给定训

PBA

练数据中自动去学习到一个最优的数据增强策略. 凭借着巨大的应用价值, 自动化数据增强技术已引起了国内外

学术界和工业界的广泛关注.

已有的自动化数据增强方法主要聚焦在提升模型准确率以及搜索效率两个方面. Google AA 虽然能够达

到目前最优的模型准确率, 但是其在增强策略搜索过程中, 需要评估每个采样策略, 导致搜索开销巨大, 如在

CIFAR-10 数据集上搜索耗时高达 5 000 个 GPU 小时. 近年来, 为了提升增强策略的搜索效率, 基于种群并行训

[5]

[4]

练的 PBA (population based augmentation) 、基于密度匹配的 Fast AutoAugment (Fast AA) 、基于可微分机制

的 Faster AutoAugment (Faster AA) 及 DADA (differentiable automated data augmentation) 、基于随机数据增强

[7]

[6]

[8]

的 Rand AA 等方法陆续被提出, 可将增强策略的搜索效率提升 1 000 倍以上, 大大降低了增强策略的搜索耗

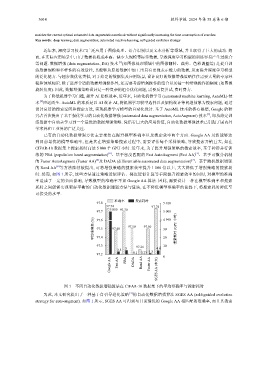

时. 然而, 如图 1 所示, 这些方法通过策略近似评估、梯度近似计算等手段提升搜索效率的同时, 对模型的准确

率造成了一定的负面影响, 导致模型的准确率不如 Google AA 算法. 因此, 需要设计一种在模型准确率和搜索

耗时之间能够实现更好平衡的自动化数据增强方法与算法, 在不降低模型准确率的前提下, 将搜索耗时降低至

可接受的水平.

准确率 搜索耗时

97.8 5 010

97.74 97.74

5 000 97.70

97.7 5 000

平均准确率 (%) 97.5 97.48 97.50 97.50 30 搜索耗时 (GPU 小时)

4 990

97.6

97.4

20

97.3 97.26 10

3.5 5 1.5 4.8

0.1 0.23

97.2 0

Google AA Fast AA DADA Rand AA Faster AA SGES AA (本文)

图 1 不同自动化数据增强算法在 CIFAR-10 数据集下的平均准确率与搜索耗时

为此, 本文研究提出了一种基于自引导进化策略 [9] 的自动化数据增强算法 SGES AA (self-guided evolution

strategy for auto-augment). 如图 1 所示, SGES AA 可得到与目前最优的 Google AA 相匹配的准确率, 而且其搜索