Page 330 - 《软件学报》2024年第4期

P. 330

1908 软件学报 2024 年第 35 卷第 4 期

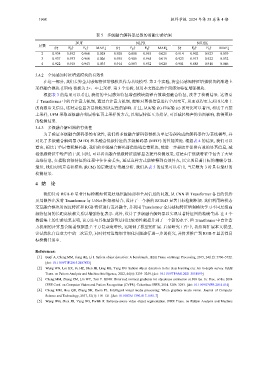

表 5 多级融合解码器层数的消融实验结果

DUT NLPR NJU2K

层数

S↑ F β ↑ E ξ ↑ MAE↓ S↑ F β ↑ E ξ ↑ MAE↓ S↑ F β ↑ E ξ ↑ MAE↓

2 0.934 0.932 0.960 0.028 0.920 0.888 0.953 0.025 0.914 0.902 0.923 0.039

3 0.937 0.933 0.960 0.026 0.935 0.905 0.965 0.019 0.923 0.913 0.922 0.032

4 0.922 0.918 0.943 0.035 0.914 0.883 0.952 0.028 0.901 0.888 0.910 0.046

3.4.2 全局感知特征增强模块的有效性

在这一部分, 我们去掉全局感知特征增强模块作为基线模型. 第 2 个实验, 将全局感知特征增强模块的渐进上

采样融合模块 (UFM) 替换为 2×、4×上采样. 第 3 个实验, 使用本文提出的全局感知特征增强模块.

根据表 3 的结果可以看出, 我们的全局感知特征增强模块能够有效增强融合特征, 改善了检测结果. 这得益

于 Transformer 中的自注意力机制, 通过自注意力机制, 能够对图像信息进行全局交互, 从而获得更大范围尺度上

的高级语义信息, 这对定位显著目标起到决定性的影响. 并且, 从实验 (b) 和实验 (c) 的对比可以看出, 相比于直接

上采样, UFM 采取逐级融合邻层特征再上采样的方式, 以邻层特征互为指导, 可以减轻噪声的负面影响, 获得更好

的检测结果.

3.4.3 多级融合解码器的有效性

为了验证多级融合解码器的有效性, 我们将多级融合解码器替换为单层卷积构成的解码器作为基线模型, 并

对比了多级融合解码器 (MFD) 和未融合低级特征的多级解码器 (MFD') 的性能差距. 根据表 4 的结果, 我们可以

看出, 相比于单层卷积解码器, 我们的多级融合解码器借助残差卷积块, 能进一步提取并保留有效的显著信息, 减

轻低级特征中噪声的干扰. 同时, 可以看出融合低级特征能够显著提升检测效果, 这是由于低级特征中包含了大量

边缘信息, 在提取高级特征的过程中往往会丢失, 通过这种方式能够得到有效补充, 以实现显著目标的精确分割.

最后, 我们对残差卷积模块 (RCM) 的层数进行消融分析. 我们从表 5 的结果可以看出, 当层数为 3 时具有最好的

检测结果.

4 结 论

我们针对 RGB-D 显著目标检测如何更好地挖掘局部和全局信息的问题, 从 CNN 和 Transformer 各自的优势

及局限性出发将 Transformer 与 U-Net 框架相结合, 设计了一个新的 RGB-D 显著目标检测框架. 我们利用跨模态

交互融合模块对深度特征和 RGB 特征进行互补融合, 并利用 Transformer 全局感知特征增强模块学习不同层级高

级特征间的长距离依赖关系以增强特征表示. 此外, 设计了多级融合解码器以实现显著特征图的精确生成. 在 5 个

数据集上的实验结果表明, 该方法与其他最新算法相比较将性能提升到了一个新的水平. 但 Transformer 中自注意

力机制的计算量会随着数据量呈平方复杂度增长, 这限制了模型的扩展. 后续研究工作中, 我们将扩展本文模型,

尝试优化自注意力中的二次运算, 同时针对边缘细节细化问题进行进一步的研究, 并将其推广到 RGB-T 显著性目

标检测任务中.

References:

[1] Borji A, Cheng MM, Jiang HZ, Li J. Salient object detection: A benchmark. IEEE Trans. on Image Processing, 2015, 24(12): 5706–5722.

[doi: 10.1109/TIP.2015.2487833]

[2] Wang WG, Lai QX, Fu HZ, Shen JB, Ling HB, Yang RG. Salient object detection in the deep learning era: An in-depth survey. IEEE

Trans. on Pattern Analysis and Machine Intelligence, 2022, 44(6): 3239–3259. [doi: 10.1109/TPAMI.2021.3051099]

[3] Cheng MM, Zhang ZM, Lin WY, Torr P. BING: Binarized normed gradients for objectness estimation at 300 fps. In: Proc. of the 2014

IEEE Conf. on Computer Vision and Pattern Recognition (CVPR). Columbus: IEEE, 2014. 3286–3293. [doi: 10.1109/CVPR.2014.414]

[4] Cheng MM, Hou QB, Zhang SH, Rosin PL. Intelligent visual media processing: When graphics meets vision. Journal of Computer

Science and Technology, 2017, 32(1): 110–121. [doi: 10.1007/s11390-017-1681-7]

[5] Wang WG, Shen JB, Yang RG, Porikli F. Saliency-aware video object segmentation. IEEE Trans. on Pattern Analysis and Machine