Page 310 - 《软件学报》2024年第4期

P. 310

1888 软件学报 2024 年第 35 卷第 4 期

与上述工作相比, 我们的模型是一种异构图结构, 可以结合意图信息和槽位信息以充分考虑不同粒度的句级

语义信息和词级信息之间的特征和差异. 同时, 我们利用了窗口机制来关注话语槽的局部连续性.

3 方 法

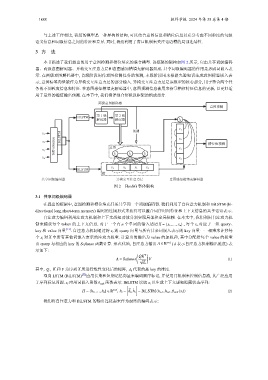

本节描述了我们提出的用于意图检测和槽位填充的联合模型. 该框架的架构如图 2 所示, 它由共享词级编码

器、两级意图解码器、异构交互注意力层和意图感知槽填充解码器组成. 共享词级编码器的作用是形成词嵌入表

示. 在两级意图解码器中, 首级阶段用作意图检测任务的预测, 末级阶段用来根据先验知识生成意图标签嵌入表

示, 意图标签向量被作为异构交互注意力层的部分输入. 异构交互注意力层是该模型的核心部分, 用于整合两个任

务的不同粒度信息和特征. 在意图感知槽填充解码器中, 意图预测信息被用来指导槽位特征信息的更新, 以更好适

用于最终的槽值输出预测. 在本节中, 我们将详细介绍拟议框架的组成部分.

两级意图解码器

意图预测

第 1 级 第 2 级

BiLSTM

解码器 解码器 I 2

预测 x 1

x 1 BiLSTM

Self-attention 意图

x 2 x 2 槽位值预测

x 3 I 1 I 2 I 3 x 3

x 4

x 4

BiLSTM x 1 x 2 x 3 x 4

槽

共享词级编码器 异构交互注意力层 意图感知槽填充解码器

图 2 HcoSG 整体架构

3.1 共享词级编码器

在提出的框架中, 意图检测和槽位填充任务共享同一个词级编码器. 我们利用了自注意力机制和 BiLSTM (bi-

directional long short-term memory) 编码的连接形式来获得可以整合词序时间特征和上下文信息的共享话语表示.

自注意力编码利用注意力机制和上下文感知功能分别实现局部和全局依赖. 在本文中, 我们利用自注意力机

制来捕获每个 token 的上下文信息. 对于一个有 n 个单词的输入话语 X = {x 1 ,..., x n } , 每个 x i 对应于一组 query、

key 和 value 向量 [12] . 自注意力机制通过将 x i 的 query 向量与所有其余词嵌入表示的 key 向量一一相乘来计算每

X 中所有其他词嵌入表示的注意力权重. 计算出的输出为 value 的加权和, 其中分配给每个 value 的权重

个 x i 对

由 query 与相应的 key 的 Softmax 函数计算. 形式化地, 自注意力输出 A ∈ R n×d ( d 表示自注意力机制输出维度) 表

示如下:

( T )

QK

A = Softmax √ V (1)

d k

,

其中, Q K 和 V 为序列 X 所进行线性变化后的矩阵, d k 代表的是 key 的维度.

双向 LSTM (BiLSTM) [22] 应用长期和短期记忆向量来编码顺序标记, 并使用门机制来控制信息流, 其广泛应用

于序列标记问题. x i 应用词嵌入函数 θ emb 函数表示. BiLSTM 读取 x i 以生成上下文感知隐藏状态序列:

[ ]

⃗

←

H = {h 1 ,...,h n } ∈ R n×d , h i = h i ,h i = BiLSTM(h i−1 ,h i+1 ,θ emb (x i )) (2)

我们将自注意力和 BiLSTM 的输出连接起来作为最终的编码表示: