Page 191 - 《软件学报》2024年第4期

P. 191

赵文竹 等: 多视角融合的时空动态 GCN 城市交通流量预测 1769

注意力头的数量可以增强模型学习输入交通序列中局部和全局依赖关系的能力, 从而提升模型的性能. 同时

提高模型学习不同层次的特征表示的能力, 有效捕捉交通数据中的复杂模式和动态关系, 实现精准的交通长

期预测. 但增加注意力数量也会增加模型的计算复杂度和参数量, 导致训练和推理时间增加. 从图中可以看

出, 增加的性能提升出现递减趋势. 因此, 为了在有限的计算资源下实现更好的模型性能, 本文在实际对比实

验中选择注意力头的数量为 8.

当两种图表示融合比例取值为 0.5 时, 模型的预测效果最佳, 过低或过高的图表示融合比例均会影响模

型的预测效果. 这是由于静态的空间结构可以捕捉道路网络的拓扑信息, 动态的时序关联能够捕获交通流量

的动态变化, 过高或过低的图表示融合比例会导致模型过于依赖静态或动态信息, 导致模型泛化能力下降,

降低模型预测性能. 同时, 当两种图融合比例为 0.5 时, 能够更好地平衡模型的参数量和复杂度, 提高模型的

训练效率和稳定性.

当全局表示融合比例取值为 0.5 时, 模型的预测效果最佳, 过高或过低的全局表示融合比例同样会降低

模型预测性能. 这是由于当全局相关性权重较大时, 模型更加注重整个路网的拓扑结构和交通流量的传播规

律; 当局部相关性权重较大时, 模型更加注重局部区域的空间结构和动态变化. 因此, 当全局表示融合比例

为 0.5 时, 能够更好地捕捉路网中局部结构和全局相关性之间的依赖关系, 充分利用两种信息的优势, 从而提

升模型预测的准确度. 在实际应用中, 最优的融合比例可能会受到数据集的不同而有所差异, 因此需通过相

应的实验和调参以确定最优的全局表示融合比例.

3.7 效率实验

为了更加直观和有效地展现本文模型效果, 验证方法的绿色低碳成果, 我们比较了本文方法和深度学习

方法在 4 个真实高速公路数据集中每个迭代(epoch)所需的平均训练时间和推理时间. 所有实验均在配备

NVIDIA RTX 4090 显卡, 13th Gen Intel(R) Core(TM) i9-13900K CPU, 128G RAM 运行内存的计算服务器上进

行训练, 表 5 显示了效率实验的结果.

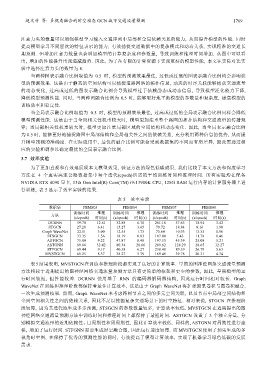

表 5 效率实验

数据集 PEMS03 PEMS04 PEMS07 PEMS08

方法 训练时间 推理 训练时间 推理 训练时间 推理 训练时间 推理

(s/epoch) 时间(s) (s/epoch) 时间(s) (s/epoch) 时间(s) (s/epoch) 时间(s)

DCRNN 59.70 12.61 32.88 6.78 261.18 57.65 18.94 3.42

STGCN 27.28 6.41 15.27 3.65 79.72 18.84 8.16 1.98

Graph WaveNet 22.11 3.00 12.55 1.73 75.60 10.93 13.35 0.96

STSGCN 33.35 1.56 18.19 0.83 107.00 5.43 11.78 0.46

ASTGCN 75.80 9.22 47.87 8.48 197.53 45.39 25.08 5.21

ASTGNN 89.66 32.42 80.34 28.66 289.62 128.29 28.65 12.27

STFGCN 69.44 9.17 40.38 6.27 238.48 89.39 26.79 5.63

MVSTGCN 65.25 8.37 38.27 5.79 169.49 39.78 20.31 4.74

表 5 结果表明, MVSTGCN 在训练和推理阶段都实现了良好的计算效率. 早期的图神经网络交通流量预测

方法相较于近期提出的图神经网络交通流量预测方法具有更简单的框架和更少的参数, 因此, 早期模型的运

行时间较短, 但性能较差. DCRNN 使用基于 RNN 的编码器解码器结构, 因此运行时间相对较长. Graph

WaveNet 在训练和推理阶段都保持着最佳计算效率, 这是由于 Graph WaveNet 将扩张因果卷积与图卷积融合,

一次生成预测结果. 然而, Graph WaveNet 未考虑路网节点之间的多元空间关联, 以及节点中局部空间结构和

全局空间相关性之间的依赖关系, 因此不足以挖掘复杂交通场景下的时空特征. 相对来说, STGCN 在推理阶

段较慢, 因为其迭代地生成多步预测, STSGCN 的参数数量较多, 计算效率较低. MVSTGCN 在近期提出的图

神经网络交通流量预测方法中训练时间和推理时间上都保持了最短时间. ASTGCN 设置了 3 个独立分量, 分

别模拟交通流量的近期依赖性、日周期性和周周期性, 因此计算效率较低. 同样的, ASTGNN 对周期性进行建

模, 增加了运行时间. STFGNN 需要生成时空融合图, 因此运行速度较慢. 而 MVSTGCN 使用了预先生成的多

视角时空图, 在保持了优秀的预测性能的同时, 有效提高了模型计算效率, 实现了机器学习绿色低碳的发展

需求.