Page 174 - 《软件学报》2021年第10期

P. 174

3146 Journal of Software 软件学报 Vol.32, No.10, October 2021

例数据,均包含相同类别的罪名及不同数量的案例.不同于他们的工作,我们加入了第 2.1 节中提到的案件辅助

句,根据其映射关系,分别标注 3 个数据集的案例.根据案例数量分别命名为数据集 S、数据集 M 和数据集 L,其

训练集、测试集和验证集的数量划分见表 2.

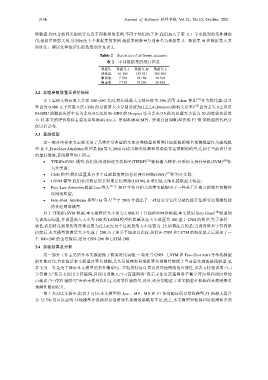

Table 2 Statistics of different datasets

表 2 不同数据集的统计信息

数据集 数据集 S 数据集 M 数据集 L

训练集 61 586 153 521 306 900

测试集 7 700 19 180 38 360

验证集 7 750 19 250 38 420

3.2 实验参数设置及评价指标

由于案例文档长度大多在 500~650 之间,我们设最大文档长度为 596.采用 Adam 算法 [21] 作为优化器;学习

率设为 0.000 1;字符嵌入层 CNN 的过滤器大小分别设置为(1,2,3,4),Dropout(随机失活率) [22] 设为丢失 0.2;单层

Bi-GRU 的随机失活率设为丢失 0.2;双层 Bi-GRU 的 Dropout 设为丢失 0.5;批次处理大小设为 10;训练轮次设置

为 12.本文的评价指标主要采用准确率(Acc.)、宏观准确率(MP)、宏观召回(MR)和宏观 F1 值.该模型的代码会

在以后公布.

3.3 基线模型

这一部分内容本文主要采用了几类非常典型的文本分类模型和两类比较新颖的罪名预测模型作为基线模

型.其中,Few-Shot Attributes 模型是 Hu 等人 2018 年提出解决低频和易混淆罪名预测的模型,达到了当前该任务

的最好效果,基线模型如下所示.

TFIDF+SVM 模型:我们使用词频逆文档频率(TFIDF) [23] 提取输入特征,并采用支持向量机(SVM) [24] 作

为分类器;

CNN 模型:我们设置具有多个过滤器宽度的卷积神经网络(CNN) [17] 作为分类器;

LSTM 模型:我们使用两层的长短期记忆网络(LSTM),并采用最大池化提取最大特征;

[9]

Fact-Law Attention 模型:Luo 等人 于 2017 年结合相关法律文献提出了一种基于注意力的罪名预测神

经网络模型;

Few-Shot Attributes 模型:Hu 等人 [15] 于 2018 年提出了一种结合罪名区分属性提升低频罪名预测性能

的神经网络模型.

对于 TFIDF+SVM 模型,本文将特征大小设为 2 000,对于其他神经网络模型,本文使用 Skip-Gram [18] 模型预

先训练词向量,并设置嵌入大小为 100.将 LSTM 模型的隐藏状态大小设置为 100.基于 CNN 的模型,为了保持一

致性,我们将过滤器的宽度都设置为(2,3,4,5),每个过滤器的大小设置为 25.值得注意的是:当词向量和字符向量

拼接后,本文模型的表示大小变成了 200.为了更公平地加以比较,我们在 CNN 和 LSTM 的池化层之后添加了一

个 100200 的全连接层,记为 CNN-200 和 LSTM-200.

3.4 实验结果及分析

这一部分工作主要结合本文模型做了两类对比实验:一类是与 CNN、LSTM 和 Few-Shot Attri.等基线模型

的性能对比,旨在验证本文模型对罪名预测,尤其是低频和易混淆罪名预测性能优于当前最先进的基线模型,见

表 3;另一类是为了验证本文模型的案件辅助句、多粒度特征计算以及高速网络的有效性,见表 4.特别说明:“()

字符嵌入”表示未使用字符编码,只使用词嵌入;“()高速网络”表示未使用高速网络平衡字符向量和词向量的

贡献比;“()案件辅助句”表示未使用我们定义的案件辅助句.此外,还分别验证了本文模型在低频和易混淆罪名

预测性能的提升.

第 1 类对比实验中,由表 3 可知:本文模型的 Acc.、MP、MR 和 F1 值均超过所有基线模型,F1 值最大提升

为 32.5%.这可以证明:基线模型在低频和易混淆罪名预测效果略有不足;反之,本文模型对低频和易混淆罪名预