Page 171 - 《软件学报》2021年第10期

P. 171

郭军军 等:融入案件辅助句的低频和易混淆罪名预测 3143

2.1 案件辅助句的构建与多粒度特征提取

2.1.1 案件辅助句的构建

为了改进低频罪名数据量小和易混淆罪名案情描述相似导致其预测准确率低这一问题,我们基于司法领

域构建案件辅助句.借助于案件辅助句扩充低频罪名的构成元素和易混淆罪名的有效区分因素.采用如图 1 所

示的方式分析了大量的中国刑事案件数据后,共定义了 9 类具有案件核心语义信息的案件辅助句,案件辅助句

的详细介绍见表 1.值得一提的是,我们定义案件辅助句时均遵循法律规定和案件判决的客观事实.

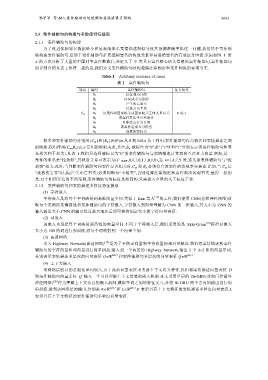

Table 1 Auxiliary sentence of cases

表 1 案件辅助句

罪名 编号 案件辅助句 是否相关

B 1 以牟利为目的

B 2 以买或卖为目的

B 3 产生死亡事实

B 4 以暴力为手段

C m B 5 该案件和国家机关或国家相关工作人员有关 0 或 1

B 6 该案件发生于公共场合

B 7 以非法占有为目的

B 8 该案件造成人身伤害

B 9 故意犯罪行为

罪名和案件辅助句分别用{C m }和{B n }表示(m 从 0 到 148,n 从 1 到 9).案件辅助句作为罪名和案情描述之间

的映射,我们使用(C m ,B n )表示它们的映射关系,其中,B n 被标注为“0”或“1”(“0”和“1”分别表示该案件辅助句和罪

名相关和不相关),见表 1.我们只选择被标记为“0”的案件辅助句与案情描述计算双向互注意力向量.例如,某一

案件的罪名是“抢劫罪”,其映射关系可表示为(C 抢劫罪,0,1,1,0,1,1,0,1,0),当 n=1,4,7,9 时,这几条案件辅助句与“抢

劫罪”相关.此外,当判断案件辅助句和案件是否相关时,C m 和 B n 必须符合该案件的客观事实描述.比如,当 C m 是

“故意伤害罪”时,B 3 (产生死亡事实)必须判断为“不相关”,否则违背法律规定和案件判决客观事实.值得一提的

是:对于相同罪名的不同案例,案件辅助句的标注是相同的,只需投入少量的人工标注工作.

2.1.2 案件辅助句和案情描述多粒度特征提取

(1) 字符嵌入

字符嵌入是将每个字符映射到高维向量空间.类似于 Kim 等人 [17] 的工作,我们使用 CNN(卷积神经网络)获

取每个案例的案情描述和案件辅助句的字符嵌入.字符嵌入到向量理解为 CNN 的一维输入,其大小为 CNN 的

输入通道大小.CNN 的输出经过最大池化后即可获得固定大小的字符向量表征.

(2) 词嵌入

词嵌入也是把每个词映射到高维的向量空间.不同于字符嵌入层,我们采用的是 Skip-Gram [18] 模型对嵌入

大小为 100 的词进行预训练,将每个词映射到一个向量空间.

(3) 高速网络

引入 Highway Network(高速网络) [19] 是为了平衡词向量和字符向量的相对贡献比.我们把案情描述和案件

辅助句的字符向量和词向量进行简单拼接,输入到一个两层的 Highway Network,输出 2 个 d2 维的向量序列,

分别表示案情描述多层次的向量表征 D 2dT 和案件辅助句多层次的向量表征 Q 2dJ .

(4) 上下文嵌入

该网络层的目的是细化单词嵌入,由于此前向量表征未考虑上下文语义特征,我们将案情描述向量表征 D

和案件辅助句向量表征 Q 输入一个可以理解上下文信息的嵌入机制.本文采用单层的 Bi-GRU(双向门控循环

神经网络) [20] 作为理解上下文信息的嵌入机制,模拟单词之间的特征交互,并将 Bi-GRU 两个方向的输出进行简

单拼接,得到该网络层的输出,分别是 K 2dT 和 L 2dJ .K 表示具有上下文特征的案情描述多粒度向量表征,L

表示具有上下文特征的案件辅助句多粒度向量表征.