Page 186 - 《软件学报》2021年第5期

P. 186

1410 Journal of Software 软件学报 Vol.32, No.5, May 2021

型 f 称为δ-公平的,如果满足:

P (| =Ya 0, ,O Π )

ln ≤ , δ

P (| =Ya 1, ,O Π )

其中,O 表示观察变量,Π 表示因果路径,δ是常数.δ≥0 可以看作在观察到 O 和Π 的条件下,弱势群体和非弱势群

体输出结果概率分布间距离的度量;δ越大,不同受保护属性A对应 Y 的概率分布差距越悬殊,对不同群体实行

差别待遇行为的程度越严重,公平性越低;δ为 0 是一种理想情况,即 P(Y |a=0,O,Π )=P(Y |a=1,O,Π ),此时,受保护

属性A不对输出结果产生影响.换言之,公平机器学习算法满足受保护属性与输出结果之间的独立性假设:对给

定条件,受保护属性A和输出结果 Y 独立.即

(Y⊥A)|(O,Π ),

其中,⊥表示 Y 中的元素和A中的元素在 O 和Π 中元素的条件下是相互不影响的,即

P Y ) = P ( , ,Y O Π ) P ( ,,A O Π O Π ) .

( , ,,A

⋅

P (, O Π ) P ( , O Π ) P ( , O Π )

在现实世界中,不同机器学习任务关注的焦点不同,很难确定一种通用的公平性定义.本节总结现有文献中

提出的公平性定义,根据受保护属性在实现公平机器学习算法过程中的作用,现有公平机器学习算法中公平性

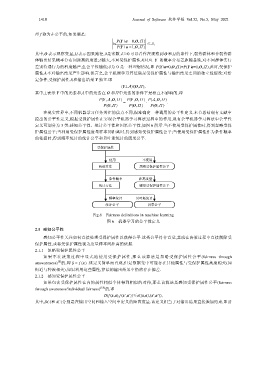

定义可划分为 3 类:感知公平性、统计公平性和因果公平性,如图 6 所示.当不使用受保护属性时,得到忽略受保

护属性公平;当利用受保护属性度量样本间距离时,得到感知受保护属性公平;当使用受保护属性作为条件概率

的依据时,得到频率统计的统计公平和贝叶斯统计的因果公平.

受保护属性

使用 不使用

构造算法 忽略受保护属性公平

条件概率 距离度量

统计方法 感知受保护属性公平

频率统计 贝叶斯统计

统计公平 因果公平

Fig.6 Fairness definitions in machine learning

图 6 机器学习的公平性定义

2.1 感知公平性

感知公平性关注如何直接处理受保护属性以获得公平.这类公平符合直觉,其或在决策过程中直接剔除受

保护属性,或将受保护属性视为度量样本间距离的依据.

2.1.1 忽略受保护属性公平

如果不在决策过程中显式地使用受保护属性,那么该算法是忽略受保护属性公平(fairness through

[8]

unawareness) 的,即 ˆ =y f ()x .该定义简单而直观,但是数据集中可能存在其他属性与受保护属性高度相关(如

街道与种族相关),如果利用这些属性,算法的输出结果中仍然存在偏差.

2.1.2 感知受保护属性公平

如果包含受保护属性在内的属性相似个体得到相似的对待,那么该算法是感知受保护属性公平(fairness

through awareness/individual fairness) [18] 的,即

D(f (x,a),f (x′,a′))≤d((x,a),(x′,a′)),

其中,D(⋅)和 d(⋅)分别是在输出空间和输入空间中定义的距离度量.该定义相当于对输出结果直接施加约束,即要