Page 183 - 《软件学报》2021年第5期

P. 183

刘文炎 等:可信机器学习的公平性综述 1407

1.1 不公平算法的危害及典型案例

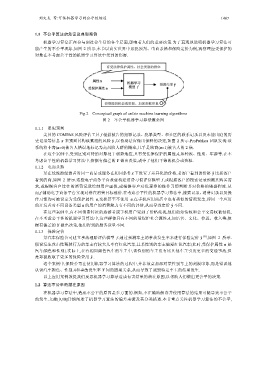

机器学习算法正在参与到社会生活的各个层面,影响着人们的重要决策.为了直观地说明机器学习算法可

能产生的不公平现象,如图 2 所示,本节以真实世界中累犯预判、电商杀熟和保险定价为例,观察理应受保护的

对象在不考虑公平性的机器学习算法中受到的伤害.

Fig.2 Conceptual graph of unfair machine learning algorithms

图 2 不公平机器学习算法概念图

1.1.1 累犯预判

美国的 COMPAS 风险评估工具 f 根据被告的犯罪记录、犯罪类型、和社区的联系记录以及未能出庭的历

史记录等信息 x 来预判其构成累犯的风险 ˆ y ,以协助法官做出保释的决定,如图 2 所示.ProPublica 团队发现:该

系统将非裔(a=0)被告人错误地标记为高风险人群的概率,几乎是欧裔(a=1)被告人的 2 倍.

在这个案例中,受到区别对待的对象处于弱势地位,具有受法律保护的属性A,如种族、性别、年龄等.在不

考虑公平性的机器学习算法中,依据有偏差的 Y 做出决策,剥夺了他们平等的机会或资源.

1.1.2 电商杀熟

某在线旅游经营者对同一商品或服务在相同条件 x 下设置了差异化的价格,老客户看到的价格 ˆ y 比新客户

看到的高,如图 2 所示.这些电子商务平台故意构建消费习惯评估模型 f ,或根据客户的搜索记录预测其购买需

求,或根据客户过往的消费记录绘制用户画像,或根据客户对优惠券的操作习惯判断其对价格的敏感程度.从

而,f 辅助电子商务平台实现对潜在消费目标涨价.在考虑公平性的机器学习算法中,搜索记录、消费记录以及操

作习惯均可被设定为受保护属性 a,变换甚至不使用 a.在手机应用商店中也有类似的情况发生,即同一个应用

的开发者对不同设备类型 a 的用户的消费能力有不同的评估,从而导致定价 ˆ y 不同.

在这些案例中,有不同消费特征的旅游者或手机用户受到了价格歧视,他们的知情权和公平交易权被侵犯.

在不考虑公平性的机器学习算法中,这些群体具有不同的受保护社会属性A,如语言、文化、位置、收入等,依

据有偏差的 Y 做出决策,他们得到的服务质量不同.

1.1.3 保险定价

某汽车保险公司建立事故理赔评估模型 f ,通过预测车主的事故发生率来进行保险定价 ˆ y [8] ,如图 2 所示.

假设发生攻击性驾驶行为的车主有较大几率有红色汽车,且某性别的车主偏爱红色汽车(此时,受保护属性 a 是

汽车颜色和性别).实际上,在有相同颜色汽车的车主中,该性别的车主没有比其他车主引发更多的交通事故,但

是却被收取了更多的保险费用 ˆ y .

这个案例中,保险公司在使用机器学习算法的过程中,并非故意加深对某性别车主的刻板印象,而是错误地

认识汽车颜色、性别A和事故发生率 Y 间的因果关系,从而导致了诋毁特定车主的结果发生.

以上应用案例敦促我们反思机器学习算法造成有害结果的潜在原因,以帮助人们做出更公平的决策.

1.2 算法不公平的潜在原因

在机器学习算法中,造成不公平的原因是多方面的.例如,不正确地解读并使用算法的结果可能导致不公平

的发生.文献[9,10]详细阐述了机器学习算法的偏差来源及其分类描述.本节重点关注机器学习算法的不公平,