Page 20 - 《软件学报》2020年第9期

P. 20

葛道辉 等:轻量级神经网络架构综述 2641

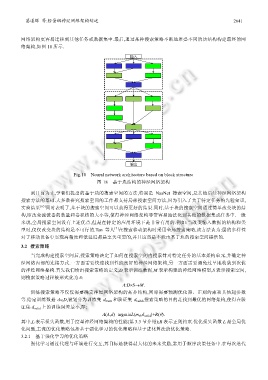

网络架构更容易迁移到其他任务或数据集中.最后,通过某种搜索策略不断地堆叠不同的块结构构建最终的网

络架构,如图 18 所示.

输入

输出

Fig.18 Neural network architecture based on block structure

图 18 基于块结构的神经网络架构

到目前为止,学者们提出的基于块的搜索空间的方法,特别是 NasNet 搜索空间,是其他后续神经网络架构

搜索方法的基础.大多数研究搜索空间的工作都支持局部搜索空间方法,因为引入了关于特定任务的先验知识,

实验结果 [65] 同时表明了,基于块的搜索空间可以获得更好的结果.同时,基于块的搜索空间通过简单改变块的结

构,即改变滤波器的数量和卷积核的大小等,使得神经网络架构非常容易地泛化到其他的数据集或任务中.一般

来说,全局搜索空间没有上述优点,但是在特定的应用环境下是非常有用的.例如:当改变输入数据的结构和类

[7]

型时,仅仅改变块的结构是不可行的.Tan 等人 在搜索移动架构时采用全局搜索策略,该方法认为:层的多样性

对于移动设备中实现高精度和低延迟都是至关重要的,并且这些是不能由基于块的搜索空间提供的.

3.2 搜索策略

当完成构建搜索空间后,搜索策略决定了如何在搜索空间内搜索针对特定任务的基本架构单元,并确定神

经网络内部的连接方式.一方面需要快速找到性能良好的神经网络架构,另一方面需要避免过早地收敛到次优

的神经网络架构.首先我们给出搜索策略的定义,D 表示训练数据,M 表示构建的神经网络模型,S 表示搜索空间,

则搜索策略过程被形式化为Λ:

Λ:D×S→M.

训练搜索策略不仅仅需要确定神经网络架构的拓扑结构,同时需要预测优化器、正则约束和其他超参数

等.给定训练数据 d∈D,被划分为训练集 d train 和验证集 d valid ,搜索策略的目的是找到最优的网络架构,使得在验

证集 d valid 上的训练误差最小,即:

Λ(A,d)=argminL(m θ ,d valid )+R(θ).

其中,L 表示损失函数,用于度量神经网络架构的性能(第 3.3 节介绍);R 表示正则约束.优化损失函数 L 是全局优

化问题,主流的优化策略包括基于强化学习的优化策略和基于进化算法的优化策略.

3.2.1 基于强化学习的优化策略

强化学习通过代理与环境进行交互,其目标是获得最大化的未来奖励,常用于顺序决策任务中.在每次迭代