Page 166 - 《软件学报》2020年第9期

P. 166

陈晋音 等:基于 PSO 的路牌识别模型黑盒对抗攻击方法 2787

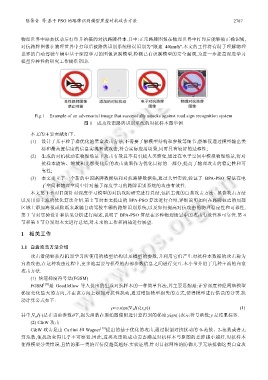

物理世界中添加扰动后打印并拍摄的对抗路牌样本.其中:正常路牌图像在物理世界中打印后能够被正确识别,

对抗路牌图像在物理世界中打印后被路牌识别系统错误识别为“限速 40km/h”.本文的工作将有助于理解物理

世界的自动驾驶车辆中基于深度学习的图像识别模型,检测已有识别模型的安全漏洞,为进一步提高深度学习

模型鲁棒性的研究工作提供帮助.

Fig.1 Example of an adversarial image that successfully attacks against road sign recognition system

图 1 成功攻击路牌识别系统的对抗样本图举例

本文的主要贡献如下.

(1) 设计了基于粒子群优化的黑盒攻击方法,不需要了解模型结构和参数等细节,能够仅通过模型输出类

标和最高置信度的信息实现有效攻击,符合实际应用场景,同时具有较好的迁移性;

(2) 生成的对抗扰动在物理场景下攻击有效且不易引起人类警觉,通过在电子空间中模拟物理场景,将对

抗样本旋转、缩放和光影变化后的攻击效果作为优化目标的一部分,提高了物理攻击的稳定性和可

靠性;

(3) 本文建立了一个新的中国路牌数据集和对抗路牌数据集,通过大量实验,验证了 BPA-PSO 算法在电

子空间和物理空间中针对基于深度学习的路牌识别系统的攻击有效性.

本文第 1 节对目前针对深度学习模型的对抗攻防研究进行总结,包括主流的白盒攻击方法、黑盒攻击方法

以及目前主流的优化算法介绍.第 2 节对本文提出的 BPA-PSO 算法进行介绍,详细说明如何在路牌标志的局部

区域上添加海报或贴纸来欺骗自动驾驶车辆的路牌识别系统,以及如何提高对抗攻击的物理稳定性和可靠性.

第 3 节对实验设计和结果分析进行阐述,说明了 BPA-PSO 算法在多种物理场景中的攻击有效性和可靠性.第 4

节和第 5 节分别对本文进行总结,对未来的工作和挑战进行展望.

1 相关工作

1.1 白盒攻击方法介绍

攻击者能够获得机器学习所使用的模型结构以及模型的参数,并利用它们产生对抗样本数据的攻击称为

白盒攻击,在这种攻击过程中,更多地需要与模型的内部参数信息之间进行交互.本小节介绍了几种主流的白盒

攻击方法.

(1) 快速梯度符号法(FGSM)

FGSM [18] 是 Goodfellow 等人提出的生成对抗样本的一种简单算法,其主要思想是:计算深度神经网络模型

梯度变化最大的方向,并在该方向上添加对抗性扰动,通过增加模型损失的方式,使得模型进行错误的分类.扰

动计算公式如下:

ρ=ε⋅sign(∇ x J(θ,x,y)) (1)

其中,∇ x J(⋅)是在当前参数θ下,损失函数在原始图像附近计算得到的梯度;sign(⋅)表示符号函数;y 是结果标签.

(2) C&W 攻击

C&W 攻击是由 Carlini 和 Wagner [19] 提出的基于优化的攻击,通过限制对抗扰动的 0-范数、2-范数或者无

穷范数,使扰动变得几乎不可察觉.因此,这类攻击的成功需要满足对抗样本与原图的差距越小越好.对抗样本

使得模型分类错误,且错的那一类的置信度越高越好.实验证明,针对目标网络的防御几乎无法抵御这类白盒攻