Page 117 - 《软件学报》2020年第12期

P. 117

于东 等:中文文本蕴含类型及语块识别方法研究 3783

输入至 BiLSTM 层中,分别得到每个字嵌入的输出信息 C i ,最后将其输入至 CRF 层进行分类.在 CRF 层分类时,

词块 i 对应的预测标签受周围其他词块预测结果的影响.

5.4 实验设计和结果分析

5.4.1 实验设计

本组实验的训练数据有 8 771 条蕴含句对,验证数据和测试数据分别为 1 097 条.在本实验中共有 17 个“位

置-类型”标签,句对中每个字都拥有对应的标签.

ESIM 系统的超参数设置为 hidden_units=300,embedding_size=300.为了充分训练并得到实验的有好结果,

我们采取 Early stopping 机制,轮数设置为 15.

BERT 系统的数据输入格式为[CLS]+P+[SEP]+H+[SEP],其中,超参数设置为 max_seq_length=128,train_

batch_size=16.由于 BERT 体量较大,所以为了以最少的训练时间得到最优效果,我们设置 learning_rate=

0.00002,微调轮数为 3.

BiLSTM+CRF 系统的超参数设置为训练轮数 40,hidden_dim=300,embedding_dim=300,采用 Adam 优化器,

学习率为 0.001.

BERT+BiLSTM+CRF 系统的超参数设置为 max_seq_length=128,hidden_units=1000.经过多次实验调整,这

些参数能够得到本实验的最好效果.

为了评估本文提出的边界识别方法的有效性,实验采用 F1 值(F1-measure)作为评价指标.F1 值定义为在指

定的数据集上准确率(precision)和召回率(recall)的综合平均,同时反映了两者的数值高低,F1 值越高,效果越好.

5.4.2 结果分析

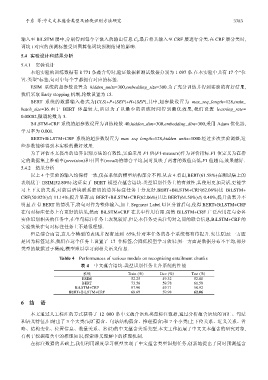

以上 4 个实验的输入均保持一致,仅在系统的模型结构部分不同.从表 4 看出,BERT(61.58%)在测试集上的

表现优于 ESIM(52.80%).这证实了 BERT 模型在蕴含语块-类型识别任务上的有效性,其使用更加灵活,更能学

习上下文的关系,对前后语块联系密切的边界标注任务十分友好.BERT+BiLSTM+CRF(62.06%)比 BiLSTM+

CRF(50.92%)高 11.14%,提升显著.而 BERT+BiLSTM+CRF(62.06%)只比 BERT(61.58%)高 0.48%,提升效果并不

明显.在有 BERT 的情况下,将句对作为整体输入,加上 Segment Label 以区分前后句,使得 BERT+BiLSTM+CRF

在句对标注任务上有更好的结果,然而 BiLSTM+CRF 在其中作用有限.虽然 BiLSTM+CRF 广泛应用在与命名

实体识别相关的任务中,在单句标注任务上表现较好,但是本任务更关注句对之间的联合信息,BiLSTM+CRF 的

实验效果在句对标注任务上不是很理想.

但是综合而言,这几个模型的表现并没有达到 65%,针对本任务的各个系统都有待提升.究其原因:一方面

是因为标签过多,我们在这个任务上设置了 17 个标签,会降低模型学习效果;另一方面是数据分布不平均,部分

类型的数据过于稀疏,模型难以学习到相关语义信息.

Table 4 Performances of various models on recognizing entailment chunks

表 4 中文蕴含语块-类型识别任务上各系统的性能

系统 Train (%) Dev (%) Test (%)

ESIM 52.25 49.32 52.80

BERT 73.56 59.78 61.58

BiLSTM+CRF 87.90 49.71 50.92

BERT+BiLSTM+CRF 68.69 59.98 62.06

6 结 语

本文通过人工标注的方式获得了 12 000 条中文蕴含语块类型标注数据,通过分析蕴含语块的词汇、句法

和语义特征,归纳出了 3 个大类(词汇蕴含、句法结构蕴含、推理蕴含)和 7 个小类(上下位关系、近义关系、省

略、结构变化、位置信息、数量关系、常识)的中文蕴含关系类型.本文工作拓展了中文文本蕴含的研究对象,

有利于挖掘蕴含中的推理知识,探索语义理解中的推理机制.

在标注数据的基础上,我们利用深度学习模型实现了中文蕴含类型识别任务,创新地提出了同时预测蕴含