Page 391 - 《软件学报》2026年第1期

P. 391

388 软件学报 2026 年第 37 卷第 1 期

提出了更高要求. 除此之外, SRv6 相比传统 IP 网络的转发行为存在显著差异, 端到端路径动态多变, 流量工程策

略灵活多样. 传统监测运维技术难以直接应用于 SRv6 场景. 面对这些挑战, 研究人员从 SID 编码优化、软硬件转

发加速和性能监测等层面提出了一系列优化策略, 以期在保证性能和效率的同时最小化资源消耗.

3.1.1 SID 编码优化

为了应对 SRH 带来的头部开销问题, 研究人员提出了多种 SID 编码优化方案. 这些方案主要通过压缩 SID

的长度或减少 SID 的数量, 来达到优化 SRH 头部开销的目的. 其中, G-SRv6 和基于功能解耦的 FDSRM 方案采用

了紧凑编码的思路, 而 Micro SID 方案则通过引入微指令的方式实现了 SID 的极致压缩.

文献 [42] 提出了 G-SRv6, G-SRv6 通过移除 SID 列表中重复的公共前缀和参数部分实现了 32 位 SID. 理论

上可以减少高达 75% 的开销. 使得大多数商用芯片组能够处理多达 10 个 SID, 而无需引入数据包重新循环, 显著

缓解了 SRv6 硬件处理开销的挑战. 文献 [43] 提出 FDSRM 的机制, 它通过逻辑上解耦 SID/G-SID 的功能, 结合机

器学习算法优化标签分配, 取得了比 G-SRv6 更优的效果. 文献 [44] 提出的 Micro SID 的压缩率接近 75%, 但这种

极致的压缩方式损失了一定的灵活性.

除了优化 SID 编码外, 另一类 SRH 开销减小方案是基于路径语义的压缩技术. 这类方案利用 SR 路径的拓扑

特性, 通过提取和编码路径的差异信息或关键节点, 在保证转发语义不变的情况下最小化 SRH 长度.

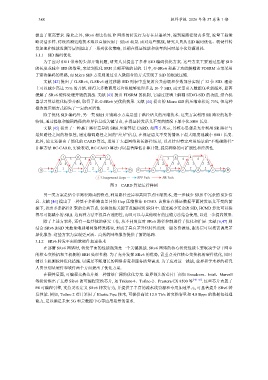

文献 [45] 提出了一种基于路径差异的 SRH 压缩算法 CARD. 如图 5 所示, 其核心思想是充分利用 SR 路径与

最短路径之间的相似性, 通过编码路径之间的“差异”信息, 在保证语义不变的情况下最大限度地减小 SRH 长度.

此外, 论文还提出了简化的 CARD 算法, 适用于大型网络和长路径场景, 以及针对特定应用场景的“不精确路径”

计算方法 RC-CARD, 实验表明, RC-CARD 算法可以显著降低计算开销, 提高网络的可扩展性和经济性.

f g h i f g h i

3 4 4 3 4 4

2 2 3 4 2 1 2 1 2 2 3 4 2 1 2 1

1 1 1 2 2 1 1 1 1 2 2 1

S a b c d e D S a b c d e D

i Compressed Hops SPF Path SR Path

图 5 CARD 算法运行样例

另一类方案是结合多路径路由的特点, 利用路径差异和共同节点压缩技术, 进一步减少 SRH 中冗余的 SID 信

息. 文献 [46] 提出了一种基于多维路由差异的 Hop 压缩算法 HCMD. 该算法在保证数据平面转发语义不变的前

提下, 找出多条路径汇聚的公共节点, 仅将这些关键节点编码到 SRH 中. 通过减少冗余的 SID, HCMD 算法可以获

得尽可能减小的 SRH. 这两种方法不仅具有通用性, 而且可以与其他现有的压缩方法结合使用, 以进一步提高效果.

除了上述方案外, 还有一些其他的研究工作, 从不同角度对 SRv6 路径控制进行了优化和扩展. 文献 [6,47] 则

结合 SRv6 BSID 来抽象端到端网络转发路径, 形成了具有差异化特性的统一服务资源池, 服务层可以按需调度差

异化服务. 这些方案为实现更灵活、高效的网络服务提供了新的思路.

3.1.2 SRv6 转发平面的软硬件加速技术

在部署 SRv6 网络时, 转发平面的性能瓶颈是一个关键挑战. SRv6 网络的核心转发性能主要取决于骨干网中

的核心交换机和主机侧的 SRH 处理性能. 为了充分发挥 SRv6 的优势, 需重点关注核心交换机的硬件优化, 同时

辅以主机侧软件优化措施. 以满足不断增长的网络带宽和服务质量需求. 为了应对这一挑战, 业界和学术界的研究

人员分别从硬件和软件两个方面提出了优化方案.

在硬件层面, 可编程交换芯片是一种前景广阔的优化方案. 业界领先的芯片厂商如 Broadcom、Intel、Marvell

等纷纷推出了支持 SRv6 的可编程交换芯片, 如 Trident-4、Tofino-2、Prestera CX 8500 等 [48−50] . 这些芯片内置了

P4 可编程引擎, 支持灵活定义 SRv6 转发行为, 并提供了丰富的流水线资源和专用加速单元, 可显著提升 SRv6 转

发性能. 例如, Tofino 2 芯片采用了 Elastic Pipe 技术, 可提供高达 12.8 Tb/s 的交换容量和 4.8 Bpps 的数据包处理

能力, 足以满足未来 5G 和云数据中心等应用场景的需求.